RECORDANDO A HAWKING

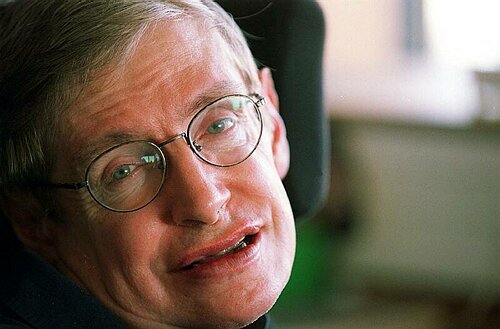

Stephen Hawking, físico teórico británico, es mundialmente

conocido por sus intentos de unificar la Relatividad General con la Teoría Cuántica

y por sus aportaciones relacionadas con la Cosmología y los agujeros negros.

Hawking está considerado actualmente como uno de los físicos más importantes de

la segunda mitad del siglo XX y comienxos del XXI.

Stephen William Hawking nació el 8 de enero de 1942 en Oxford, Inglaterra. La

casa de sus padres estaba en el norte de Londres, pero durante la segunda

guerra mundial se consideraba que Oxford era un lugar más seguro para tener

niños. Cuando tenía ocho años, su familia se mudó a St

Albans, un pueblo a unas 20 millas del norte de Londres.A

los once años Stephen fue a la Escuela de St Albans,

y luego al Colegio Mayor Universitario en Oxford, el antiguo colegio de su

padre. Stephen quería hacer Matemáticas, pese a que su padre habría preferido

Medicina. Como Matemáticas no podía estudiarse en el Colegio Universitario, él

optó por Física en su lugar. Después de tres años obtuvo el título de primera

clase con honores en Ciencias Naturales.Stephen fue

entonces a Cambrigde para investigar en Cosmología.

Tras obtener el Doctorado pasó a ser Investigador, y más tarde Profesor en los

Colegios Mayores de Gonville y Caius.

Después de abandonar el Instituto de Astronomía en 1973, entró en

el Departamento de Matemáticas Aplicadas y Física Teórica, y desde 1979 ocupa

el puesto de Profesor Lucasiano de Matemáticas de

Cambridge, ocupado años atrás por Isaac Newton.

Stephen Hawking ha trabajado en las leyes básicas que gobiernan el Universo.

Junto con Roger Penrose mostró que la Teoría General de la Relatividad de

Einstein implica que el espacio y el tiempo han de tener un principio en el Big

Bang y un final dentro de agujeros negros. Semejantes

resultados señalan la necesidad de unificar la Relatividad General con la

Teoría Cuántica, el otro gran desarrollo científico de la primera mitad del

siglo XX.Una consecuencia de

tal unificación era que los agujeros negros no eran totalmente negros, sino que

podían emitir radiación y eventualmente evaporarse y desaparecer. Otra

conjetura es que el Universo no tiene bordes o límites en el tiempo imaginario.

Esto implicaría que el modo en que el Universo empezó queda completamente

determinado por las leyes de la Ciencia.

Más tarde depuró este concepto considerando todas estas teorías como intentos

secundarios de describir una realidad, en la que conceptos como la singularidad

no tienen sentido y donde el espacio y el tiempo forman una superficie cerrada

sin fronteras. Ha escrito diversos libros de Física Y Astronomía, y también

libros de divulgación científica como "A hombros de gigantes",

"El Universo en una cáscara de nuez" y el famoso "Historia del

tiempo: del Big Bang a los agujeros negros"

(1988) y otras obras que se han convertido en best-sellers.

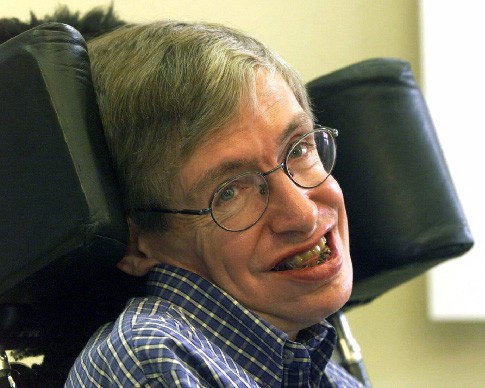

Hawking ha hecho importantes aportaciones a la Ciencia en los

campos de la Física y la Astronomía (Cosmología y Agujeros Negros, mientras

lucha contra la esclerosis lateral amiotrófica, una enfermedad incurable del

sistema nervioso. En 1989 le fue concedido el Premio Príncipe de Asturias de la

Concordia.El Profesor Hawking tiene doce doctorados

honoríficos, ha ganado el CBE en 1982 y fue designado Compañero de Honor en

1989. Ha obtenido numerosos premios, galardones y medallas y es Miembro de

Honor de la Royal Society y de la US National Academy of Sciencies.

Stephen Hawking combina la vida en familia y su investigación en

Física teórica, junto con un extenso programa de

viajes y conferencias.

He aquí algunas de sus conferencias más

interesantes

El 29 de

abril de 1980, di mi conferencia inaugural como profesor de matemáticas de la

cátedra Lucasiana en Cambridge. El título era: “¿Está

a la vista el fin de la Física Teórica? y en ella describí el progreso que ya

habíamos experimentado en el entendimiento del universo durante los últimos

siglos, al mismo tiempo que me preguntaba cuales eran

las posibilidades de encontrar finalmente una teoría completa y unificada del

todo hacia finales de siglo. Bien, el final del siglo ya está casi aquí. Aunque

hemos recorrido un largo camino, particularmente durante los últimos 3 años, no

parece que vayamos a conseguirlo.

El 29 de

abril de 1980, di mi conferencia inaugural como profesor de matemáticas de la

cátedra Lucasiana en Cambridge. El título era: “¿Está

a la vista el fin de la Física Teórica? y en ella describí el progreso que ya

habíamos experimentado en el entendimiento del universo durante los últimos

siglos, al mismo tiempo que me preguntaba cuales eran

las posibilidades de encontrar finalmente una teoría completa y unificada del

todo hacia finales de siglo. Bien, el final del siglo ya está casi aquí. Aunque

hemos recorrido un largo camino, particularmente durante los últimos 3 años, no

parece que vayamos a conseguirlo.

En mi lectura de 1980 describí cómo habíamos dividido el problema

de encontrar una teoría del todo en un número de partes más manejables.

Primeramente habíamos dividido la descripción del universo que nos

rodea en dos partes. La primera de ellas es un conjunto de leyes locales que

nos dicen cómo evoluciona cada región del universo en el tiempo si sabemos su

estado inicial, y cómo es afectada por otras regiones. La otra parte consta de

un conjunto de lo que denominamos condiciones límite. Estas, especifican lo que

sucede en el borde del espacio y el tiempo. Ellas determinan cómo empezó el

universo, y quizás, cómo va a terminar.

Mucha gente, incluyendo probablemente a la mayoría de los físicos,

sienten que las tareas de la física teórica deberían estar confinadas a la

primera parte, es decir a formular leyes locales que describan cómo evoluciona

el universo a medida que el tiempo transcurre. Ellos considerarían la cuestión

del cómo se determinó el estado inicial como algo que va más allá del ámbito de

la física, perteneciendo al reino de la metafísica o la religión. Pero yo soy

un desvergonzado racionalista. En mi opinión las condiciones límite que

determinan el estado inicial del universo son una materia tan legítima y sujeta

al escrutinio de los científicos como lo son las leyes que gobiernan su

evolución posterior.

A principios de la década de los 60, las fuerzas que los físicos

conocían se clasificaron en cuatro categorías que parecerían estar separadas e

independizadas entre sí. La primera de las cuatro categorías era la de la

fuerza gravitatoria, la cual es portada por una partícula llamada gravitón.

La gravedad es, con mucho, la más débil de las cuatro fuerzas. Sin

embargo, corrige su baja potencia mediante la posesión de dos importantes

propiedades. La primera es que es universal, es decir, afecta a cada partícula

del universo en la misma forma. Todos los cuerpos se atraen entre si. Ninguno deja de sentirse afectado o repelido por la

gravedad. La segunda propiedad importante de la fuerza gravitatoria es que

puede operar a través de largas distancias. Juntas, estas dos propiedades

significan que las fuerzas gravitatorias entre las partículas de un cuerpo

grande se suman entre si, y pueden dominar por encima

de las otras fuerzas.

La segunda de las cuatro categorías en las que se dividen las

fuerzas corresponde a la fuerza electromagnética, la cual es portada por una

partícula llamada fotón. El electromagnetismo es un millón de billones de

billones de billones de billones más poderoso que la fuerza gravitatoria, y al

igual que la gravedad, puede actuar a través de grandes distancias. Sin

embargo, al contrario que la gravedad, no actúa en todas las partículas de la

misma forma. Algunas partículas son atraídas por ella, otras no son afectadas y

otras son repelidas.

La atracción y repulsión entre las partículas en dos cuerpos

grandes anulará cada una casi exactamente, al contrario que las fuerzas

gravitatorias entre las partículas, que sería atractiva con todas. Esto explica

que nos caigamos hacia el suelo, y no hacia el aparato de televisión. Por otro

lado, en la escala de las moléculas y los átomos, con solo un relativamente

pequeño número de partículas, las fuerzas electromagnéticas dominan

completamente a las gravitatorias. En la escala aún más pequeña de los núcleos

atómicos, es decir la trillonésima parte de un centímetro, la tercera y cuarta

categorías: las fuerzas nucleares débil y fuerte, dominan al resto de fuerzas.

La gravedad y el electromagnetismo se describen en función de lo

que llamamos teorías de campos, en las que hay un conjunto de números en cada

punto del espacio y tiempo que determinan las fuerzas gravitatoria y

electromagnética. Cuando yo empecé a investigar en 1962, se creía generalmente

que las fuerzas nuclear débil y fuerte no podían ser descritas por una teoría

de campo. Pero los informes de la muerte de la teoría de campos demostraron ser

una exageración. Un nuevo tipo de teoría de campos fue presentada por Chen Ning

Yang y Robert Mills. En 1967, Abdus Salam y Steven Weinberg demostraron que una teoría de este

tipo no solo describiría las fuerzas nucleares débil y fuerte sino que también

podría unificarlas con la fuerza electromagnética. Recuerdo que la mayoría de

los físicos trataron con desprecio a esta teoría de campo. Sin embargo,

concordaba tan bien con los experimentos que en 1979 se le otorgó el Premio

Nóbel a Salam, Weinberg y Glashow,

que habían propuesto teorías unificadas similares. El comité del Nóbel

realmente se arriesgó con su decisión ya que la confirmación final de la teoría

no llegaría hasta 1983, con el descubrimiento de las partículas W y Z. (Siento

la pronunciación de W y Z, sobre todo para aquellos que son británicos y no

usan un sintetizador de voz americano).

El éxito

provocó la búsqueda de una sola teoría de “gran unificación” de Yang-Mills que

describiese a los tres tipos de fuerza. Las teorías de gran unificación no son

muy satisfactorias. En realidad, su nombre es básicamente una exageración. No

son realmente grandes ya que contienen al menos 40 números que no pueden

predecirse con antelación sino que tienen que ajustarse para que casen con los

experimentos. Se podría esperar que la teoría final del universo sea única y

que no contenga cantidades ajustables. ¿Cómo va a ser que estos valores sean

elegidos?

El éxito

provocó la búsqueda de una sola teoría de “gran unificación” de Yang-Mills que

describiese a los tres tipos de fuerza. Las teorías de gran unificación no son

muy satisfactorias. En realidad, su nombre es básicamente una exageración. No

son realmente grandes ya que contienen al menos 40 números que no pueden

predecirse con antelación sino que tienen que ajustarse para que casen con los

experimentos. Se podría esperar que la teoría final del universo sea única y

que no contenga cantidades ajustables. ¿Cómo va a ser que estos valores sean

elegidos?

Pero la objeción más poderosa a las grandes teorías de unificación

era que no estaban unificadas completamente. No incluían a la gravedad y no

existía ninguna forma aparente de ampliarlas de modo que lo hicieran. Pudiera

ser que no existiera una única teoría fundamental. En lugar de eso, podría

haber una colección de teorías aparentemente diferentes, cada una de las cuales

funcionaría bien en ciertas situaciones. Las teorías diferentes concordarían

entre si en aquellas regiones de validez en la que se

superpusieran. Por ello, podrían ser contempladas como aspectos diferentes de

la misma teoría. Pero tal vez no existiese una única formulación de la teoría

que pudiese aplicarse en todas las situaciones.

Podemos comparar la física teórica al hecho de cartografiar la

Tierra. Se puede representar exactamente una pequeña región de la superficie de

la tierra, en forma de mapa, en una hoja de papel. Pero si se intenta hacer un

mapa de una región más grande se obtendrían distorsiones debido a la curvatura

de la Tierra. No es posible representar cada punto de la superficie de la

Tierra en un único mapa. En lugar de ello, usamos una colección de mapas que

concuerdan en aquellas regiones donde se superponen.

Como dije, incluso si encontramos una teoría unificada completa,

tanto con una única formulación, como con una serie de teorías superpuestas,

solo habremos solucionado la mitad del problema. La teoría unificada nos dirá como evoluciona el universo en el tiempo dado un estado

inicial. Pero la teoría no especificará en si misma las condiciones límites en

el borde del espacio y el tiempo que determinan el estado inicial. Esta

cuestión es fundamental para la cosmología. Podemos observar el estado presente

del universo, y podemos usar las leyes de la física para calcular cómo pudo ser

en épocas anteriores. Pero todo lo que esto nos dice es que el universo es

ahora como es, porque entonces era como era. No podemos entender por qué el

universo tiene el aspecto que tiene a no ser que la cosmología se convierta en

una ciencia, en el sentido de que pueda hacer predicciones. Y para hacer esto

necesitamos una teoría de las condiciones límite del universo.

Ha habido

varias sugerencias para las condiciones iniciales del universo, tales como la

hipótesis del túnel y el así llamado escenario pre-big

bang. Pero en mi opinión, la más elegante, con mucho,

es la que Jim Hartle y yo llamamos la propuesta de la

ausencia de límites. Esta puede enunciarse como: la condición de límite del

universo es que no tiene límite. En otras palabras, el espacio y el tiempo

imaginario unidos se curvan hacia atrás sobre si mismos de modo que forman una

superficie cerrada como la superficie de la Tierra, pero con más dimensiones.

La superficie de la Tierra tampoco tiene límites. No existen informes fiables

de que alguien haya caído en el abismo del fin del mundo.

Ha habido

varias sugerencias para las condiciones iniciales del universo, tales como la

hipótesis del túnel y el así llamado escenario pre-big

bang. Pero en mi opinión, la más elegante, con mucho,

es la que Jim Hartle y yo llamamos la propuesta de la

ausencia de límites. Esta puede enunciarse como: la condición de límite del

universo es que no tiene límite. En otras palabras, el espacio y el tiempo

imaginario unidos se curvan hacia atrás sobre si mismos de modo que forman una

superficie cerrada como la superficie de la Tierra, pero con más dimensiones.

La superficie de la Tierra tampoco tiene límites. No existen informes fiables

de que alguien haya caído en el abismo del fin del mundo.

La condición de no-límite y las otras teorías son simplemente

proposiciones para las condiciones de límite del universo. Para probarlas

tenemos que calcular qué predicciones pueden extraerse de ellas y compararlas

con las nuevas observaciones que están empezando a hacerse. De momento, las

observaciones no son lo bastante buenas como para distinguir entre estas

diferentes clases de mapa. Pero en los próximos años, se acometerán nuevas

observaciones que podrán salvar esta cuestión. La cosmología vive un período

excitante. Apuesto mi dinero por la condición de no-límite. Se trata de una

explicación tan elegante que estoy seguro que Dios la habría elegido.

El progreso efectuado con los intentos de unificar la gravedad con

el resto de fuerzas ha sido enteramente teórico. Esto ha llevado a alguna gente

como al físico John Horgan a afirmar que la física esta muerta porque se ha convertido simplemente en un juego

matemático, no relacionado con la experimentación. Pero yo no estoy de acuerdo.

Aunque no podamos producir partículas de la energía de Planck – la energía a la

cual la gravedad se unificaría con las otras fuerzas – existen predicciones que

pueden ser verificadas a niveles más bajos de energía. El Super Colisionador

Superconductor que estaba siendo construido en Texas podría haber alcanzado

esas energías pero fue cancelado cuando los Estados Unidos iniciaron una fase

de recesión económica. De modo que tendremos que esperar a que se concluya el

Gran Colisionador de Hadrones que está siendo construido en Ginebra.

Asumiendo que los experimentos de Ginebra confirmen la teoría

actual, ¿cuáles son las perspectivas de completar una teoría unificada? En 1980

dije que pensaba que había una oportunidad del 50% de encontrar una teoría

completa de unificación durante los siguientes 20 años. Esa es aún mi

estimación, pero los próximos 20 años empiezan ahora. Volveré dentro de otros

20 años para decirles si lo hemos conseguido.

Esta

conferencia versa sobre si podemos predecir el futuro o bien éste es arbitrario

y aleatorio. En la antigüedad, el mundo debía de haber parecido bastante

arbitrario. Desastres como las inundaciones o las enfermedades debían de haber

parecido producirse sin aviso o razón aparente. La gente primitiva atribuía

esos fenómenos naturales a un panteón de dioses y diosas que se comportaban de

una forma caprichosa e impulsiva. No había forma de predecir lo que harían, y

la única esperanza era ganarse su favor mediante regalos o conductas. Mucha

gente todavía suscribe parcialmente esta creencia, y tratan de firmar un pacto

con la fortuna. Se ofrecen para hacer ciertas cosas a cambio de un

sobresaliente en una asignatura, o de aprobar el examen de conducir.

Sin

embargo, la gente se debió de dar cuenta gradualmente de ciertas regularidades

en el comportamiento de la naturaleza. Estas regularidades eran más obvias en

el movimiento de los cuerpos celestes a través del firmamento. Por eso la

Astronomía fue la primera ciencia en desarrollarse. Fue puesta sobre una firme

base matemática por Newton hace más de 300 años, y todavía usamos su teoría de

la gravedad para predecir el movimiento de casi todos los cuerpos celestes.

Siguiendo el ejemplo de la Astronomía, se encontró que otros fenómenos

naturales también obedecían leyes científicas definidas. Esto llevó a la idea

del determinismo científico, que parece haber sido expresada públicamente por

primera vez por el científico francés Laplace. Me pareció que me gustaría citar

literalmente las palabras de Laplace. y le pedí a un amigo que me las buscara.

Por supuesto que están en francés, aunque no esperaba que la audiencia tuviera

ningún problema con esto.

Sin

embargo, la gente se debió de dar cuenta gradualmente de ciertas regularidades

en el comportamiento de la naturaleza. Estas regularidades eran más obvias en

el movimiento de los cuerpos celestes a través del firmamento. Por eso la

Astronomía fue la primera ciencia en desarrollarse. Fue puesta sobre una firme

base matemática por Newton hace más de 300 años, y todavía usamos su teoría de

la gravedad para predecir el movimiento de casi todos los cuerpos celestes.

Siguiendo el ejemplo de la Astronomía, se encontró que otros fenómenos

naturales también obedecían leyes científicas definidas. Esto llevó a la idea

del determinismo científico, que parece haber sido expresada públicamente por

primera vez por el científico francés Laplace. Me pareció que me gustaría citar

literalmente las palabras de Laplace. y le pedí a un amigo que me las buscara.

Por supuesto que están en francés, aunque no esperaba que la audiencia tuviera

ningún problema con esto.

El problema es que Laplace, como Prewst [N.

del T.: Hawking probablemente se refiere a Proust], escribía frases de una

longitud y complejidad exageradas. Por eso he decidido parafrasear la cita. En

efecto, lo que él dijo era que, si en un instante determinado conociéramos las

posiciones y velocidades de todas las partículas en el Universo, podríamos

calcular su comportamiento en cualquier otro momento del pasado o del futuro.

Hay una historia probablemente apócrifa según la cual Napoleón le preguntó a

Laplace sobre el lugar de Dios en este sistema, a lo que él replicó

"Caballero, yo no he necesitado esa hipótesis". No creo que Laplace

estuviera reclamando que Dios no existe. Es simplemente que El no interviene

para romper las leyes de la Ciencia. Esa debe ser la postura de todo

científico. Una ley científica no lo es si solo se cumple cuando algún ser

sobrenatural lo permite y no interviene.

La idea de que el estado del universo en un instante dado

determina el estado en cualquier otro momento ha sido uno de los dogmas centrales

de la ciencia desde los tiempos de Laplace. Eso implica que podemos predecir el

futuro, al menos en principio. Sin embargo, en la práctica nuestra capacidad

para predecir el futuro está severamente limitada por la complejidad de las

ecuaciones, y por el hecho de que a menudo exhiben una propiedad denominada

caos. Como sabrán bien todos los que han visto Parque Jurásico, esto significa

que una pequeña perturbación en un lugar puede producir un gran cambio en otro.

Una mariposa que bate sus alas puede hacer que llueva en Central Park, Nueva

York. El problema es que eso no se puede repetir. La siguiente vez que una

mariposa bata sus alas, una multitud de otras cosas serán diferentes, lo que

también tendrá influencia sobre la meteorología. Por eso las predicciones

meteorológicas son tan poco fiables.

A pesar de estas dificultades prácticas, el determinismo científico

permaneció como dogma durante el siglo 19. Sin embargo, en el siglo 20 ha

habido dos desarrollos que muestran que la visión de Laplace sobre una

predicción completa del futuro no puede ser llevada a cabo. El primero de esos

desarrollos es lo que se denomina mecánica cuántica. Fue propuesta por primera

vez en 1900, por el físico alemán Max Planck, como hipótesis ad hoc para

resolver una paradoja destacada. De acuerdo con las ideas clásicas del siglo

19, que se remontan a los tiempos de Laplace, un cuerpo caliente, como una

pieza de metal al rojo, debería emitir radiación. Perdería energía en forma de

ondas de radio, infrarrojos, luz visible, ultravioleta, rayos x, y rayos gamma,

todos a la misma tasa. Esto no sólo significaría que todos moriríamos de cáncer

de piel, sino que además todo en el universo estaría a la misma temperatura, lo

que claramente no es así.

Sin embargo, Planck mostró que se puede evitar este desastre si se

abandonara la idea de que la cantidad de radiación puede tener cualquier valor,

y se dijera en su lugar que la radiación llega únicamente en paquetes o cuantos

de un cierto tamaño. Es un poco como decir que en el supermercado no se puede

comprar azúcar a granel, sino sólo en bolsas de un kilo. La energía en los

paquetes o cuantos es mayor para los rayos x y ultravioleta, que para la luz

infrarroja o visible. Esto significa que a menos que un cuerpo esté muy

caliente, como el Sol, no tendrá suficiente energía para producir ni siquiera

un único cuanto de rayos x o ultravioleta. Por eso no nos quemamos por

insolación con una taza de café.

Para Planck los cuantos no eran más que un truco matemático que no

tenía una realidad física, lo que quiera que eso signifique. Sin embargo, los

físicos empezaron a encontrar otro comportamiento, que sólo podía ser explicado

en términos de cantidades con valores discretos o cuantizados, más que

variables continuas. Por ejemplo, se encontró que las partículas elementales se

comportaban más bien como pequeñas peonzas girando sobre un eje. Pero la

cantidad de giro no podía tener cualquier valor. Tenía que ser algún múltiplo

de una unidad básica. Debido a que esa unidad es muy pequeña, uno no se da

cuenta de que una peonza normal decelera mediante una rápida secuencia de

pequeños pasos, más que mediante un proceso continuo. Pero para peonzas tan

pequeñas como los átomos, la naturaleza discreta del giro es muy importante.

Pasó algún tiempo antes de que la gente se diera cuenta de las

implicaciones que tenía este comportamiento cuántico para el determinismo. No

sería hasta 1926, cuando Werner Heisenberg, otro físico alemán, indicó que no

podrías medir exactamente la posición y la velocidad de una partícula a la vez.

Para ver dónde está una partícula hay que iluminarla. Pero de acuerdo con el

trabajo de Planck, uno no puede usar una cantidad de luz arbitrariamente

pequeña. Uno tiene que usar al menos un cuanto. Esto

perturbará la partícula, y cambiará su velocidad de una forma que no puede ser

predicha. Para medir la posición de la partícula con exactitud, deberás usar

luz de una longitud de onda muy corta, como la ultravioleta, rayos x o rayos

gamma. Pero nuevamente, por el trabajo de Planck, los cuantos de esas formas de

luz tienen energías más altas que las de la luz visible. Por eso perturbarán

aún más la velocidad de la partícula. Es un callejón sin salida: cuanto más

exactamente quieres medir la posición de la partícula, con menos exactitud

puedes conocer la velocidad, y viceversa. Esto queda resumido en el Principio

de Incertidumbre formulado por Heisenberg; la incertidumbre en la posición de

una partícula, multiplicada por la incertidumbre en su velocidad, es siempre mayor

que una cantidad llamada la constante de Planck, dividida por la masa de la

partícula.

La visión de Laplace del determinismo científico implicaba conocer

las posiciones y velocidades de las partículas en el universo en un instante

dado del tiempo. Por lo tanto, fue seriamente socavado por el Principio de

Incertidumbre de Heisenberg. ¿Cómo puede uno predecir el futuro, cuando uno no

puede medir exactamente las posiciones ni las velocidades de las partículas en

el instante actual? No importa lo potente que sea el ordenador de que

dispongas, si lo alimentas con datos deplorables, obtendrás predicciones

deplorables.

Einstein estaba muy descontento por esta aparente aleatoriedad en

la naturaleza. Su opinión se resumía en su famosa frase 'Dios no juega a los

dados'. Parecía que había presentido que la incertidumbre era sólo provisional,

y que existía una realidad subyacente en la que las partículas tendrían

posiciones y velocidades bien definidas y se comportarían de acuerdo con leyes

deterministas, en consonancia con Laplace. Esta realidad podría ser conocida

por Dios, pero la naturaleza cuántica de la luz nos impediría verla, excepto

tenuemente a través de un cristal.

La visión de Einstein era lo que ahora se llamaría una teoría de

variable oculta. Las teorías de variable oculta podrían parecer ser la forma

más obvia de incorporar el Principio de Incertidumbre en la física. Forman la

base de la imagen mental del universo, sostenida por muchos científicos, y

prácticamente por todos los filósofos de la ciencia. Pero esas teorías de

variable oculta están equivocadas. El físico británico John Bell, que murió

recientemente, ideó una comprobación experimental que distinguiría teorías de

variable oculta. Cuando el experimento se llevaba a cabo cuidadosamente, los

resultados eran inconsistentes con las variables ocultas. Por lo tanto parece

que incluso Dios está limitado por el Principio de Incertidumbre y no puede

conocer la posición y la velocidad de una partícula al mismo tiempo. O sea que

Dios juega a los dados con el universo. Toda la evidencia lo señala como un

jugador empedernido, que tira los dados siempre que tiene ocasión.

Otros

científicos estaban mucho más dispuestos que Einstein a modificar la visión

clásica del determinismo del siglo 19. Una nueva teoría, denominada la mecánica

cuántica, fue propuesta por Heisenberg, el austríaco Erwin Schroedinger,

y el físico británico Paul Dirac. Dirac fue mi penúltimo predecesor en la

cátedra Lucasiana de Cambridge. Aunque la mecánica

cuántica ha estado entre nosotros durante cerca de 70 años, todavía no es

generalmente entendida o apreciada, incluso por aquellos que la usan para hacer

cálculos. Sin embargo, debería preocuparnos a todos, puesto que es una imagen

completamente diferente del universo físico y de la misma realidad.

Otros

científicos estaban mucho más dispuestos que Einstein a modificar la visión

clásica del determinismo del siglo 19. Una nueva teoría, denominada la mecánica

cuántica, fue propuesta por Heisenberg, el austríaco Erwin Schroedinger,

y el físico británico Paul Dirac. Dirac fue mi penúltimo predecesor en la

cátedra Lucasiana de Cambridge. Aunque la mecánica

cuántica ha estado entre nosotros durante cerca de 70 años, todavía no es

generalmente entendida o apreciada, incluso por aquellos que la usan para hacer

cálculos. Sin embargo, debería preocuparnos a todos, puesto que es una imagen

completamente diferente del universo físico y de la misma realidad.

En la mecánica cuántica, las partículas no tienen posiciones ni

velocidades bien definidas. En su lugar, son representadas por lo que se llama

una función de onda. Esta es un número en cada punto del espacio. El tamaño de

la función de onda indica la probabilidad de que la partícula sea encontrada en

esa posición. La tasa con la que la función de onda cambia de punto a punto,

proporciona la velocidad de la partícula. Uno puede tener una función de onda

con un gran pico en una región muy pequeña. Esto significará que la

incertidumbre en la posición es muy pequeña. Pero la función de onda variará

muy rápidamente cerca del pico, hacia arriba en un lado, hacia abajo en el

otro. Por lo tanto la incertidumbre en la velocidad será grande. De la misma

manera, uno puede tener funciones de onda en las que la incertidumbre en la

velocidad es pequeña, pero la incertidumbre en la posición es grande.

La función de onda contiene todo lo que uno puede saber de la

partícula, tanto su posición como su velocidad. Si sabes la función de onda en

un momento dado, entonces sus valores en otros momentos son determinados por lo

que se llama la ecuación de Schroedinger. Por lo

tanto uno tiene aún un cierto determinismo, pero no del tipo que Laplace

imaginaba. En lugar de ser capaces de predecir las posiciones y las velocidades

de las partículas, todo lo que podemos predecir es la función de onda. Esto

significa que podemos predecir sólo la mitad de lo que podríamos de acuerdo con

la visión clásica del siglo 19.

Aunque la mecánica cuántica lleva a la incertidumbre cuando

tratamos de predecir la posición y la velocidad a un mismo tiempo, todavía nos

permite predecir con certidumbre una combinación de posición y velocidad. Sin

embargo, incluso este grado de certidumbre parece estar amenazado por

desarrollos más recientes. El problema surge porque la gravedad puede torcer el

espacio-tiempo tanto que puede haber regiones que no observamos.

Curiosamente, el mismo Laplace escribió un artículo en 1799 sobre

cómo algunas estrellas pueden tener un campo gravitatorio tan fuerte que la luz

no podría escapar, siendo por tanto arrastrada de vuelta a la estrella. Incluso

calculó que una estrella de la misma densidad que el Sol, pero doscientas

cincuenta veces más pequeña, tendría esta propiedad. Pero aunque Laplace podría

no haberse dado cuenta, la misma idea había sido propuesta 16 años antes por un

hombre de Cambridge, John Mitchell, en un artículo en Phylosophical

Transactions of the Royal Society. Tanto Mitchel

como Laplace concebían a la luz como formada por partículas, más bien como

bolas de cañón, que podían ser deceleradas por la gravedad, y hechas caer de

vuelta a la estrella. Pero un famoso experimento llevado a cabo por dos

americanos, Michelson y Morley, en 1887, mostraron que la luz siempre viajaba a

una velocidad de ciento ochenta y seis mil millas por segundo, no importa de

dónde viniera. Cómo podía entonces la gravedad decelerarla, y hacerla caer de

nuevo.

De acuerdo con las ideas sobre el espacio y el tiempo vigentes en

aquel momento esto era imposible. Sin embargo, en 1915 Einstein presentó al

mundo su revolucionaria Teoría General de la Relatividad en la cual espacio y

tiempo dejaban de ser entidades separadas e independientes. Por el contrario,

eran meramente diferentes direcciones de una única noción llamada

espacio-tiempo. Esta noción espacio-tiempo no era uniforme sino deformada y

curvada debido a su energía inherente. Para que se entienda mejor, imagínese

que colocamos un peso (que hará las veces de estrella) sobre una lámina de

goma. El peso (estrella) formará una depresión en la goma curvándose la zona

alrededor del mismo en contraposición a la planicie anterior. Si hacemos rodar

canicas sobre la lámina de goma, sus rastros serán espirales más que líneas

rectas.

En 1919, una expedición británica en el Oeste de África observaba

la luz de estrellas lejanas que cruzaba cerca del sol durante un eclipse.

Descubrieron que las imágenes de las estrellas variaban ligeramente de sus

posiciones habituales; esto revelaba que las trayectorias de la luz de las

estrellas habían sido curvadas por el influjo del espacio-tiempo que rodea al

sol. La Relatividad General había sido confirmada.

Imagínese ahora que colocamos pesos sobre la lámina de goma cada

vez más cuantiosos y de manera más intensiva. Hundirán la plancha cada vez más.

Con el tiempo, alcanzado el peso y la masa crítica se hará un agujero en la

lámina por el que podrán caer las partículas pero del que no podrá salir nada.

Según la Teoría General de la Relatividad lo que sucede con el

espacio-tiempo es bastante similar. Cuanto más ingente y más densa sea una

estrella, tanto más se curvará y distorsionará el espacio-tiempo alrededor de

la misma. Si una estrella inmensa que ha consumido ya su energía nuclear se

enfría encogiéndose por debajo de su masa crítica, formará literalmente un

agujero sin fondo en el espacio-tiempo por el que no puede pasar la luz. El

físico americano John Wheeler llamó a estos objetos “agujeros negros” siendo el

primero en destacar su importancia y los enigmas que encierran. El término se

hizo popular rápidamente. Para los americanos sugería algo oscuro y misterioso

mientras que para los británicos existía además la amplia difusión del Agujero

Negro de Calcuta. Sin embargo los franceses, muy franceses ellos, percibieron

algo indecente en el vocablo. Durante años se resistieron a utilizar el

término, demasiado negro, arguyendo que era obsceno; pero era parecido a

intentar luchar contra préstamos lingüísticos como “le weekend”

y otras mezcolanzas del “franglés”. Al final tuvieron

que claudicar. ¿Quién puede resistirse a una expresión así de conquistadora?

Ahora

tenemos evidencias de la existencia de agujeros negros en diferentes tipos de

entidades, desde sistemas de estrellas binarios al centro de las galaxias. Por

lo tanto, la existencia de agujeros negros está ampliamente aceptada hoy en

día. Con todo y al margen de su potencial para la ciencia ficción, ¿cuál sería

su relevancia para el determinismo? La respuesta reside en una pegatina de

parachoques que tenía en la puerta de mi despacho: “los agujeros negros son

invisibles”.

Ahora

tenemos evidencias de la existencia de agujeros negros en diferentes tipos de

entidades, desde sistemas de estrellas binarios al centro de las galaxias. Por

lo tanto, la existencia de agujeros negros está ampliamente aceptada hoy en

día. Con todo y al margen de su potencial para la ciencia ficción, ¿cuál sería

su relevancia para el determinismo? La respuesta reside en una pegatina de

parachoques que tenía en la puerta de mi despacho: “los agujeros negros son

invisibles”.

No sólo ocurre que las partículas y los astronautas desafortunados

que caen en un agujero negro no vuelven nunca, sino que la información que

estos portan se pierde para siempre, al menos en nuestra demarcación del

universo. Puede lanzar al agujero negro aparatos de televisión, sortijas de

diamantes e incluso a sus peores enemigos y todo lo que recordará el agujero

negro será su masa total y su estado de rotación. John Wheeler llamó a esto “un

agujero negro no tiene pelo”. Esto confirma las sospechas de los franceses.

Mientras hubo el convencimiento de que los agujeros negros

existirían siempre, esta pérdida de información pareció no importar demasiado.

Se podía pensar que la información seguía existiendo dentro de los agujeros

negros. Simplemente es que no podemos saber lo que hay desde fuera de ellos

pero la situación cambió cuando descubrí que los agujeros negros no son del

todo negros. La Mecánica Cuántica hace que estos emitan partículas y

radiaciones a un ritmo constante.

Estos hallazgos me asombraron no sólo a mí si no al resto del

mundo pero con la perspectiva del tiempo esto habría resultado obvio. Lo que se

entiende comúnmente como “el vacío” no está realmente vacío ya que está formado

por pares de partículas y antipartículas. Estas permanecen juntas en cierto

momento del espacio-tiempo, en otro se separan para después volver a unirse y

finalmente aniquilarse la una a las otra. Estas partículas y antipartículas

existen porque un campo, tal como los campos que transportan la luz y la

gravedad no puede valer exactamente cero. Esto denotaría que el valor del campo

tendría tanto una posición exacta (en cero) como una velocidad o ritmo de

cambio exacto (también cero). Esto violaría el Principio de Incertidumbre

porque una partícula no puede tener al tiempo una posición y una velocidad

constantes. Por lo tanto, todos los campos deben tener lo que se denomina

fluctuaciones del vacío. Debido al comportamiento cuántico de la naturaleza se

puede interpretar estas fluctuaciones del vacío como partículas y

antipartículas como he descrito anteriormente.

Estos pares de partículas se dan en conjunción con todas las

variedades de partículas elementarias. Se denominan

partículas virtuales porque se producen incluso en el vacío y no pueden ser

mostradas directamente por los detectores de partículas. Sin embargo, los

efectos indirectos de las partículas virtuales o fluctuaciones del vacío han

sido estudiados en diferentes experimentos, siendo confirmada su existencia.

Si hay un agujero negro cerca, uno de los componentes de un par de

partículas y antipartículas podría deslizarse en dicho agujero dejando al otro

componente sin compañero. La partícula abandonada puede caerse también en el

agujero o bien desplazarse a larga distancia del mismo donde se convertirá en

una verdadera partícula que podrá ser apreciada por un detector de partículas.

A alguien muy alejado del agujero negro le parecerá que la partícula ha sido

emitida por el mismo agujero.

Esta explicación de cómo los agujeros negros no son tan negros

clarifica que la emisión dependerá de la magnitud del agujero negro y del ritmo

al que esté rotando. Sin embargo, como un agujero negro no tiene pelo, citando

a Wheeler, la radiación será por otra parte independiente de lo que se deslizó

por el agujero. No importa lo que arroje a un agujero negro: aparatos de

televisión, sortijas de diamantes o a sus peores enemigos. Lo que de allí sale

es siempre lo mismo.

Pero ¿qué tiene esto que ver con el determinismo que es sobre lo

que se supone que versa esta conferencia? Lo que esto demuestra es que hay

muchos estados iniciales (incluyendo aparatos de televisión, sortijas de

diamantes e incluso gente) que evolucionan hacia el mismo estado final, al

menos fuera del agujero negro. Sin embargo, en la visión de Laplace sobre el

determinismo había una correspondencia exacta entre los estados iniciales y los

finales. Si usted supiera el estado del universo en algún momento del pasado

podría predecirlo en el futuro. De manera similar, si lo supiera en el futuro,

podría deducir lo que habría sido en el pasado. Con el advenimiento de la

Teoría del Cuanto en los años 20 del siglo pasado se redujo a la mitad lo que

uno podía predecir pero aún dejó una correspondencia directa entre los estados

del universo en diferentes momentos. Si uno supiera la función de onda en un

momento dado, podría calcularla en cualquier otro.

Sin embargo, la situación es bastante diferente con los agujeros

negros. Uno se encontrará con el mismo estado fuera del agujero,

independientemente de lo que haya lanzado dentro, a condición de que tenga la

misma masa. Por lo tanto, no hay una correspondencia exacta entre el estado

inicial y el estado final ya fuera del agujero negro. Habrá una correspondencia

exacta entre el estado inicial y el final ambos fuera

o ambos dentro del agujero negro. Sin embargo, lo importante es que la emisión

de partículas y la radiación alrededor del agujero provocan una reducción en la

masa del mismo y se empequeñece.

Finalmente, parece que el agujero negro llega a la masa cero y

desaparece del todo. Pero, ¿qué ocurre con todos los objetos que fueron

lanzados al agujero y con toda la gente que o bien saltó o fue empujada? No

pueden volver a salir porque no existe la suficiente masa o energía sobrante en

el agujero negro para enviarlos fuera de nuevo. Puede que pasen a otro universo

pero eso nos da lo mismo a los que somos lo suficientemente prudentes como para

no saltar dentro de un agujero negro. Incluso la información de lo que cayó

dentro del agujero no podría salir de nuevo cuando el agujero desaparezca por

último. La información no se distribuye gratuitamente como bien sabrán aquellos

de ustedes que paguen facturas telefónicas. La información necesita energía

para transportarse, y no habrá suficiente energía de sobra cuando el agujero

negro desaparezca.

Lo que todo esto significa es que la información se perderá de

nuestra demarcación del universo cuando se formen los agujeros negros para

después desvanecerse. Esta pérdida de información implica que podemos predecir

incluso menos de lo pensamos, partiendo de la base de la teoría cuántica. En

esta teoría puede no ser factible predecir con certidumbre la posición y la

velocidad de una partícula al mismo tiempo. Hay sin embargo una combinación de

posición y velocidad que sí puede ser predicha. En el caso de un agujero negro,

esta predicción específica concierne a los dos miembros de un par de

partículas-antipartículas pero únicamente podemos detectar la partícula

expulsada. No hay modo alguno, incluso en un principio, de poner de manifiesto

la partícula que se precipita al agujero. Por lo tanto, por lo que sabemos,

podría estar en cualquier estado. Esto significa que no podemos hacer ninguna

predicción concreta acerca de la partícula que expulsa el agujero.

Podemos calcular la probabilidad de que la partícula tenga esta o

aquella posición o velocidad pero no podemos predecir con precisión una

combinación de la posición y velocidad de sólo una partícula porque su

velocidad y posición van a depender de la otra partícula, la cual no está bajo

nuestra observación. Así que Einstein estaba sin lugar a dudas equivocado

cuando dijo, “Dios no juega a los dados”. No sólo Dios juega definitivamente a

los dados sino que además a veces los lanza a donde no podemos verlos.

Muchos científicos son como Einstein en el sentido de que tienen

un lazo emocional muy fuerte con el determinismo pero al contrario que Einstein

han aceptado la reducción en nuestra capacidad para predecir que nos había

traído consigo la teoría cuántica. Pero ya era mucho. A estos no les gustó la

consiguiente reducción que los agujeros negros parecían implicar. Pensar que el

universo es determinista, como creía Laplace, es simplemente inocente.

Presiento que estos científicos no se han aprendido la lección de la historia.

El universo no se comporta de acuerdo a nuestras preconcebidas ideas. Continúa

sorprendiéndonos.

Podría pensarse que no importa demasiado si el determinismo hizo

aguas cerca de los agujeros negros. Estamos casi seguros de estar al menos a unos pocos años luz de agujero negro de cualquier tamaño

pero según el Principio de Incertidumbre, cada región del espacio debería estar

llena de diminutos agujeros negros virtuales que aparecerían y desaparecerían

una y otra vez. Uno pensaría que las partículas y la información podrían

precipitarse en estos agujeros negros y perderse. Sin embargo, como estos

agujeros negros virtuales son tan pequeños (cien billones de billones más

pequeños que el núcleo de un átomo) el ritmo al cual se perdería la información

sería muy bajo. Esto es por lo que las leyes de la ciencia parecen

deterministas, observándolas con detenimiento. Sin embargo, en condiciones

extremas, tales como las del universo temprano o las de la colisión de

partículas de alta energía, podría haber una significativa pérdida de

información. Esto conduce a la imprevisibilidad en la evolución del universo.

En resumen, de lo que he estado hablando es de si el universo

evoluciona de manera arbitraria o de si es determinista. La visión clásica

propuesta por Laplace estaba fundada en la idea de que el movimiento futuro de

las partículas estaba determinado por completo, si su sabían sus posiciones y

velocidades en un momento dado. Esta hipótesis tuvo que ser modificada cuando

Heisenberg presentó su Principio de Incertidumbre el cual postulaba que no se

podía saber al mismo tiempo y con precisión la posición y la velocidad. Sin

embargo, sí que era posible predecir una combinación de posición y velocidad

pero incluso esta limitada certidumbre desapareció

cuando se tuvieron en cuenta los efectos de los agujeros negros: la pérdida de

partículas e información dentro de los agujeros negros dio a entender que las

partículas que salían eran fortuitas.

Se pueden calcular las probabilidades pero no hacer ninguna

predicción en firme. Así, el futuro del universo no está del todo determinado

por las leyes de la ciencia, ni su presente, en contra de lo que creía Laplace.

Dios todavía se guarda algunos ases en la manga.

Es todo lo que tengo que decir por el momento. Gracias por

escucharme

21

de julio, 2004

¿Pueden escucharme?

Quiero informar

que creo haber solucionado un gran problema en la física teórica que ha estado

rondando desde que descubrí que los agujeros negros radian termalmente, hace

treinta años. La pregunta es ¿Se pierde la información en la evaporación de un

agujero negro? Si es así la evolución no es unitaria y los estados cuánticos

puros, se descomponen en estados mixtos.

Quiero informar

que creo haber solucionado un gran problema en la física teórica que ha estado

rondando desde que descubrí que los agujeros negros radian termalmente, hace

treinta años. La pregunta es ¿Se pierde la información en la evaporación de un

agujero negro? Si es así la evolución no es unitaria y los estados cuánticos

puros, se descomponen en estados mixtos.

Le estoy agradecido a mi estudiante graduado Christophe

Galfard por su ayuda en la preparación de esta

conferencia.

La información de la paradoja sobre los agujeros negros, comenzó

en 1967, cuando Werner Israel mostró que la métrica de Schwarzschild,

era la única solución estática del vacío con agujeros negros. Esto fue

generalizado entonces por el teorema de no pelo, la única solución de las

ecuaciones de Einstein Maxwell son las métricas de Kerr Newman. El teorema de

no pelo implicaba que toda la información acerca del cuerpo en colapso, se

perdía desde la región exterior, aparte de tres cantidades conservadas, la masa,

el momento angular y la carga eléctrica.

Esta pérdida de información no era un problema en la teoría

clásica. Un agujero negro clásico duraría eternamente y la información podía

pensarse que quedaba conservada dentro de él, pero no muy asequible. Sin

embargo, la situación cambió cuando descubrí que los efectos cuánticos

ocasionarían que un agujero negro radiase a un ritmo persistente. Al menos en

la aproximación que estaba yo utilizando, la radiación del agujero negro sería

totalmente térmica y no llevaría información. Así que, qué es lo que sucedería

con toda la información encerrada en el interior de un agujero negro, que se

evaporaba y desaparecía completamente.

Parecía ser que la única manera como la información podía salir,

sería si la radiación no fuese exactamente térmica, pero que tuviera

correlaciones sutiles. Nadie ha encontrado un mecanismo para producir

correlaciones, pero la mayoría de los físicos creen que alguna debe de existir.

Si la información se perdiese en los agujeros negros, los estados puros del

cuanto se descompondrían en estados mezclados y la gravedad del cuanto no sería

unitaria.

Yo lancé primero la pregunta sobre pérdida de información en el 75

y el argumento continuo por años, sin ninguna resolución por ningún lado.

Finalmente, se reclamó que el asunto había sido resuelto en favor de la

conservación de la información por ADS, CFT. ADS, CFT, es una dualidad

conjeturada entre la súper-gravedad del espacio anti de Sitter

y una Teoría de Campo Conforme en las fronteras del espacio anti de Sitter en el infinito. Ya que la Teoría del Campo Conforme

es manifiestamente unitaria, el argumento es que la súper-gravedad debe

conservar la información. Cualquier información que cae en un agujero negro en

el espacio anti de Sitter, debe de volver a salir.

Pero aún no estaba claro como podía salir del agujero

la información.

Esta es la pregunta a la que voy a referirme.

La formación y evaporación de un agujero negro puede pensarse como

un proceso de interacción. Uno envía partículas y radiación desde el infinito y

mide que es lo que sale hacia el infinito. Todas las mediciones se realizan al

infinito, donde los campos son débiles y uno nunca sondea la región fuerte del

campo en el medio. De manera que uno nunca puede estar seguro que se forma un

agujero negro, no importa que tan cierto pueda esto ser en la teoría clásica.

Mostraré que esta posibilidad, permite que se conserve la información y que sea

regresada al infinito.

Adopto el acercamiento Euclidiano, la única manera sensata de

manejar la gravedad cuántica no perturbativa. Así, la

evolución temporal de un estado inicial está dada por una integra de caminos

sobre todas las métricas positivas que van entre dos superficies, que están

separadas una distancia T en el infinito. Entonces uno hace una rotación de

Wick del intervalo de tiempo, T, al Lorentziano.

La integral de caminos es tomada sobre métricas para todas las

topologías posibles que caben en medio de las superficies. Existe la topología

trivial, la superficie inicial por el intervalo de tiempo. Después están las

topologías no triviales que son todas las demás topologías posibles. La

topología trivial puede ser foliada por una familia de superficies de tiempo

constante. La integral de caminos de todas las mediciones con la topología

trivial, puede tratarse canónicamente con secciones temporales. En otras

palabras, la evolución temporal (incluyendo la gravedad) será generada por un

Hamiltoniano. Esto dará un mapa unitario desde la superficie inicial a la

final.

Las topologías no triviales, no pueden ser foliadas por una

familia de superficies de tiempo constante. Existirá un punto fijo en cualquier

campo vectorial de evolución temporal en una topología no trivial. Un punto

fijo en el régimen Euclidiano, se corresponde a un horizonte en el Lorentziano. Un pequeño cambio en el estado de la

superficie inicial, se propagaría como una onda lineal, sobre el fondo de cada

métrica en la integral de caminos. Si el fondo contenía un horizonte, la onda

caería a través de él y decaería exponencialmente en un tiempo posterior, fuera

del horizonte. Por ejemplo, las funciones de correlación decaen

exponencialmente en las métricas con agujeros negros. Esto significa que la

integral de caminos sobre todas las métricas topológicamente no triviales, será

independiente del estado de la superficie inicial. No se sumará a la amplitud

para ir desde el estado inicial hasta el final, que proviene de la integral de

caminos sobre todas las métricas topológicamente triviales.

De manera que el mapa desde los estados iniciales a los finales,

dado por la integral de caminos sobre todas las métricas, será unitario. Uno

podría dudar el uso de este argumento, del concepto de un estado cuántico para

el campo gravitacional, sobre una superficie spacelike

inicial o final. Esto sería un funcional de las geometrías de superficies spacelike, lo cual no es algo que pueda medirse en campos

débiles cerca del infinito. Uno puede medir los campos débiles gravitatorios,

en un tubo timelike alrededor del sistema, pero las

tapas de encima y de debajo, van a través del interior del sistema, donde los

campos pueden ser fuertes.

Una forma de deshacerse de las dificultades de las tapas, sería

unir la superficie final de regreso con la superficie inicial, e integrar todas

las geometrías espaciales de la unión. Si esta fuese una identificación bajo un

intervalo de tiempo Lorentziano, T, en el infinito,

introduciría curvas timelike cerradas. Pero si el

intervalo al infinito es la distancia Euclidiana, beta, la integral de caminos

proporciona la función de partición para la gravedad a la temperatura, uno

sobre beta.

La función de partición de un sistema, es la traza sobre todos los

estados, pesados con e a la menos beta H. Entonces se puede integrar beta a lo

largo de un contorno paralelo al eje imaginario, con el factor, e a la beta E0.

Esto proyecta los estados con energía, E0. En un colapso gravitatorio y

evaporación, uno está interesado en los estados de energía precisa, en vez de

los estados de temperatura precisa.

Existe un problema de infrarrojo con esta idea para un espacio

plano asintótico. La integral de caminos Euclidiana con período beta, es la

función de partición para espacio a temperatura, uno sobre beta. La función de

partición es infinita, porque el volumen del espacio es infinito. Este problema

de infrarrojo puede resolverse por una pequeña constante cosmológica negativa.

No afectará la evaporación de un agujero negro pequeño, pero cambiará el

infinito a espacio anti de Sitter y hará finita la

función de partición térmica.

La frontera en el infinito entonces es un toroide, S1, por S2. La

topología trivial, periódicamente identificada como espacio anti de Sitter, llena el toroide, pero también lo hacen las

topologías no-triviales, la más conocida de ellas siendo la Schwarzschild

anti de Sitter. Mientras que la temperatura sea

pequeña comparada con la temperatura de Hawking-Page, la integral de caminos

sobre todas las métricas topológicamente triviales, representa radiación auto

gravitante en el espacio asintótico de anti de Sitter.

La integral de caminos sobre todas las métricas de la topología ADS de Schwarzschild representa un agujero negro y radiación

térmica en el anti de Sitter asintótico.

La frontera en el infinito tiene topología S1 por S2. La topología

más simple que cabe dentro de estas fronteras, es la topología trivial, S1 por

D3, el tres-disco. La siguiente topología más simple y la primera topología no

trivial, es S1 por D2. Esta es la topología de la métrica de Schwarzschild anti de Sitter.

Existen otras topologías posibles que caben dentro de las fronteras, pero estas

dos son los casos importantes, métricas topológicamente triviales y el agujero

negro. El agujero negro es eterno. No puede convertirse en topológicamente

trivial más adelante.

En vista de esto, uno puede comprender porqué

la información se conserva en las métricas topológicamente triviales, pero

exponencialmente decae en métricas topológicamente no triviales. Un estado

final de espacio vacío sin un agujero negro, sería topológicamente trivial y

estaría foliado por superficies de tiempo constante. Estas formarían un

tres-ciclo módulo frontera en el infinito. Cualquier simetría global conduciría

a cargas globales conservadas en esos tres ciclos. Esto evitaría que las

funciones de correlación decayesen exponencialmente en las métricas

topológicamente triviales. En efecto, uno puede considerar la evolución

Hamiltoniana unitaria, de una métrica topológicamente trivial como la

conservación de la información a través de un tres-ciclo.

Por otra parte, una topología trivial, como un agujero negro, no

tendrá un tres-ciclo final. Por lo tanto no conservará ninguna cantidad, que

prevendría que las funciones de correlación decaigan exponencialmente. Así uno

es conducido al maravilloso resultado, que las amplitudes de tiempo posterior

de la integral de caminos sobre una métrica topológicamente no trivial, son

independientes del estado inicial. Esto fue notado por Maldacena

en el caso de anti de Sitter3 asintótico e interpretado como el hecho de

implicar que la información se pierde en la métrica BTZ de agujeros negros. Maldacena fue capaz de demostrar que las métricas

topológicamente triviales tienen funciones de correlación que no decaen y

tienen amplitudes del orden correcto para ser compatibles con una evolución

unitaria. Sin embargo Maldacena no se dio cuenta de

que desde un tratamiento canónico se sigue que la evolución de una métrica

topológicamente trivial será unitaria.

Así que al final, todos tenían razón, de alguna manera. La

información se pierde en métricas topológicamente no triviales, como el agujero

negro eterno. Por otro lado, la información se conserva en las métricas

topológicamente triviales. La confusión y paradoja vino porque la gente pensó

de manera clásica, en términos de una sola topología para el espacio-tiempo.

Era o R4 o un agujero negro. Pero la suma sobre historias de Feynman, permite

que sea ambas a la vez. Uno no puede afirmar qué topología contribuyó a la

observación más de lo que uno puede decir qué ranura atravesó el electrón en el

experimento de las dos ranuras. Todo lo que la observación en el infinito puede

determinar, es que existe un mapa desde los estados iniciales, hasta el final y

que esa información no se pierde.

Mi trabajo con Hartle, mostró que la

radiación podría ser pensada como un escape del interior de un agujero negro.

Por lo tanto era razonable suponer que podría llevar información hacia fuera

del agujero negro. Esto explica como puede formarse

un agujero negro y después ofrecer la información acerca de lo que hay adentro,

mientras se mantiene topológicamente trivial. No existe un universo bebé

ramificándose, como alguna vez pensé. La información permanece firmemente en

nuestro universo. Lo siento por desilusionar a los seguidores de la

ciencia-ficción, pero si la información se conserva, no existe la posibilidad

de utilizar a los agujeros negros para viajar a otros universos. Si usted cae

dentro de un agujero negro, su masa energía regresará a nuestro universo, pero

de una manera dañada, que contiene la información acerca de lo que era, pero en

un estado irreconocible.

Existe un problema en describir que es lo que pasa, por que estrictamente hablando, lo único observable en la

gravedad cuántica, son los valores del campo en el infinito. Uno no puede

definir el campo en un punto del medio, porque existe una incertidumbre

cuántica en relación con el lugar donde se hace la medición. Sin embargo, en

los casos en que existen un gran número, N, de campos de materia ligeros,

acoplados a la gravedad, uno puede despreciar las fluctuaciones gravitatorias,

porque sólo son una entre N lazos cuánticos. Uno puede entonces realizar la

integral de caminos sobre todos los campos de materia, en una métrica dada,

para obtener una acción efectiva que será un funcional de la métrica.

Uno puede agregar la clásica acción de Einstein Hilbert de la

métrica, a esta acción efectiva cuántica de los campos de materia. Si uno

integrase esta acción combinada sobre todas las otras métricas uno obtendría la

teoría cuántica completa. Sin embargo, la aproximación semiclásica, es la de

representar la integral sobre las métricas, por su punto de inflexión. Esto

obedecería las ecuaciones de Einstein, donde la fuente es el valor de

expectación del tensor de energía-momento, de los campos de materia en su

estado de vacío.

La única manera de calcular la acción efectiva de los campos de

materia, solía ser la teoría perturbativa. Esto no es

factible que funcione en el caso del colapso gravitatorio. Sin embargo, ahora

afortunadamente tenemos un método no-perturbativo en

ADS CFT. La conjetura de Maldacena dice que la acción

efectiva de un CFT en una métrica de fondo es igual a la acción efectiva de la

súper-gravedad del espacio anti de Sitter con esa

métrica de fondo en el infinito. En el gran límite N, la acción efectiva de

súper-gravedad es solamente la acción clásica. De ahí que el cálculo de la

acción efectiva cuántica de los campos de materia, es equivalente a resolver

las ecuaciones de Einstein clásicas.

La acción de un espacio anti de Sitter,

con una frontera al infinito, sería infinita así que hay que regularizar. Uno

introduce restas que dependen solo de la métrica de la frontera.

- El primer contrapunto es proporcional al

volumen de la frontera.

- El segundo contrapunto es proporcional a la

acción Einstein Hilbert de la frontera.

- Existe un tercer contrapunto, pero no está

definido covariantemente.

Ahora uno agrega la acción Einstein Hilbert de la frontera y se

busca un punto de inflexión de la acción total. Esto involucrará resolver las

ecuaciones Einstein acopladas de cuatro y cinco dimensiones. Probablemente

tenga que hacerse numéricamente.

En esta conferencia, he argumentado que la gravedad cuántica es

unitaria y la información es mantenida en la formación y evaporación de

agujeros negros. Considero que la evolución está dada por una integral de

caminos Euclidiana sobre las métricas de todas las topologías. La integral

sobre métricas topológicamente triviales puede hacerse dividiendo el intervalo

de tiempo en delgadas secciones y utilizando una interpolación linear a la

métrica de cada sección. La integral sobre cada sección, será unitaria y así

toda la integral de caminos será unitaria.

Por otro lado, la integral de caminos sobre métricas

topológicamente no triviales, perderá información y será asintóticamente

independiente de sus condiciones iniciales. Por lo tanto la integral de caminos

será unitaria y la mecánica cuántica estará a salvo.

Es grandioso resolver un problema que me ha estado preocupando por

casi treinta años, aunque la respuesta es menos apasionante que la alternativa

que sugerí. Este resultado no es todo negativo, pues indica que un agujero

negro se evapora, mientras permanece topológicamente trivial. Sin embargo, la

gran solución N es probable que sea un agujero negro que se contrae hasta cero.

Esto es lo que sugerí en 1975.

En 1997, Kip Thorne y yo, le apostamos a

John Preskill, que la información se perdía en los

agujeros negros. El perdedor o perdedores de la apuesta tienen que darle al

ganador o ganadores una enciclopedia de su elección, de la cual pueda obtenerse

información con toda facilidad. Ahora estoy listo para conceder la apuesta,

pero Kip Thorne no está convencido del todo. Yo le

daré a John Preskill la enciclopedia que pidió. John

es un “all American”, así que naturalmente quiere una

enciclopedia sobre béisbol. Tuve muchas dificultades en conseguir una por aquí,

así que le ofrecí una enciclopedia sobre críquet, como una alternativa, pero

John no se dejó convencer de la superioridad del críquet. Afortunadamente mi

asistente, Andrew Dunn, convenció a los editores de Sportclassic

Books, a enviar por avión una copia de Total

Baseball, The Ultimate Baseball Encyclopedia

a Dublín. Le daré a John la enciclopedia ahora. Si Kip

acepta reconocer la apuesta más tarde, puede devolvérmela.

En ciencia

ficción, la curvatura del espacio y del tiempo son eventos comunes. Se les

utiliza para viajes rápidos alrededor de la galaxia, o para viajes en el

tiempo. Pero a menudo, la ciencia ficción de hoy es la ciencia empírica del

mañana. De modo que ¿cuáles son las posibilidades de curvar el espacio y el tiempo?.

En ciencia

ficción, la curvatura del espacio y del tiempo son eventos comunes. Se les

utiliza para viajes rápidos alrededor de la galaxia, o para viajes en el

tiempo. Pero a menudo, la ciencia ficción de hoy es la ciencia empírica del

mañana. De modo que ¿cuáles son las posibilidades de curvar el espacio y el tiempo?.

La idea de que el espacio y el tiempo pueden sufrir torsiones o

curvarse, es bastante reciente. Durante más de dos mil años, los axiomas de la

geometría Euclídea fueron considerados verdades evidentes. Como todos aquellos

que se han visto forzados a estudiar geometría Euclídea en el colegio

recuerdan, una de las consecuencias de estos axiomas es, que los ángulos de un

triángulo, sumados en conjunto, dan como resultado 180 grados.

Sin embargo, durante el último siglo, la gente comenzó a darse

cuenta de que existían otras formas posibles de geometría, en la que los

ángulos de un triángulo, no necesariamente suman 180 grados. Considere, por

ejemplo, la superficie de la Tierra. Lo más cercano a una línea recta en la

superficie de la Tierra es lo que llamamos, un gran círculo. Estos son los

caminos más cortos entre dos puntos, por eso las compañías aéreas los emplean

como rutas de vuelo. Considere ahora el triángulo en la superficie de la Tierra

compuesto por el ecuador, la línea de 0 grados de longitud que atraviesa

Londres, y la linea de 90 grados longitud este que

atraviesa Bangladesh. Las dos líneas de longitud cortan el ecuador formando un

ángulo de 90 grados. Las dos líneas de longitud se encuentran también en el

polo norte formando otro ángulo de 90 grados. Por ello, tenemos un triángulo

con tres ángulos rectos. Los ángulos de este triángulo sumados en conjunto dan

como resultado 270 grados. Esto supera a los 180 grados de un triángulo sobre

una superficie plana. Si dibujamos un triángulo con una superficie en forma de

silla de montar, descubriremos que la suma de sus ángulos da un resultado menor

a 180 grados.

La superficie de la Tierra, es lo que conocemos como espacio bidimensional.

Lo cual significa que puedes moverte a través de la superficie de la Tierra en

dos direcciones, las cuales forman un ángulo recto entre si:

puedes moverte norte-sur, o este-oeste. Pero por supuesto, hay una tercera

dirección que forma ángulos rectos con las otras dos, y esa dirección es

arriba-abajo. Lo que es tanto como decir que la superficie de la Tierra existe

en un espacio tridimensional. El espacio tridimensional es plano. Lo cual

significa que obedece a la geometría Euclídea. La suma de los ángulos de un

triángulo es de 180 grados. Sin embargo, podríamos imaginar una raza de

criaturas bidimensionales que pudiesen moverse sobre la superficie de la

Tierra, pero que no pudiesen experimentar la tercera dirección, es decir

arriba-abajo. Ellos no conocerían el espacio plano tridimensional sobre el que

se apoya la superficie de la Tierra. Para ellos, el espacio sería curvo, y la

geometría no sería Euclídea.

Sería muy difícil diseñar un ser viviente que pudiese existir en

solo dos dimensiones.

La comida que la criatura no podría digerir, debería escupirla por

el mismo sitio por el que entró. Si hubiese un pasaje que atravesase al animal

a lo largo, tal y como nosotros tenemos, el pobre animal acabaría deshecho en

dos partes.

De modo que tres dimensiones, parecen ser las mínimas exigibles

para la vida. Pero así como se puede pensar en seres de dos dimensiones

viviendo sobre la superficie de la Tierra, también cabria imaginar que el

espacio tridimensional en el que vivimos, era la superficie de una esfera, en

otra dimensión que nosotros no vemos. Si la esfera fuese muy grande, el espacio

parecería ser casi plano, y la geometría Euclídea sería una estupenda

aproximación sobre distancias pequeñas. Pero nos daríamos cuenta de que la

geometría Euclídea no funcionaría para grandes distancias.

Como ilustración de esto, imaginemos un equipo de pintores, dando

capas de pintura sobre la superficie de una enorme bola. A medida que el grosor

de las capas de pintura se incrementa, el área de la superficie crece. Si la

bola estuviese en un espacio plano tridimensional, se podría seguir añadiendo

pintura indefinidamente, y la bola se haría más y más grande. Sin embargo, se

el espacio tridimensional fuera realmente la superficie de una esfera en otra

dimensión, su volumen sería enorme pero finito. A medida que se añaden más

capas de pintura, la bola llegaría eventualmente a llenar la mitad de la

superficie del espacio. Después de eso, los pintores descubrirían que están

atrapados en un región cuyo tamaño siempre decrece, y

casi la totalidad del espacio, estaría ocupado por la bola, y sus capas de

pintura. De modo que descubrirían que viven en un espacio curvado, y no plano.

Este ejemplo demuestra que no se puede deducir la geometría del

mundo partiendo de sus primeros principios, tal y como los antiguos griegos

pensaban. En lugar de eso, hay que medir el espacio en el que vivimos, y

descubrir su geometría experimentalmente. Sin embargo, aunque en 1854 el alemán

George Friedrich Riemann, desarrolló un modo para describir espacios curvos,

permaneció como una parte incompleta de las matemáticas durante 60 años. Podía

describir espacios curvos que existiesen en el abstracto, pero no había razones

por las que creer que el espacio físico en el que vivimos pudiese ser curvo.

Esa idea llegó solo en 1915, cuando Einstein presentó la Teoría General de la

Relatividad.

La Relatividad General fue una revolución intelectual fundamental

que ha transformado la forma en que pensamos sobre el universo. Es una teoría

no solo sobre la curvatura del espacio, sino también sobre la curvatura del

tiempo. En 1905, Einstein había comprendido que el espacio y el tiempo están

íntimamente conectados el uno con el otro. Se puede describir la localización

de un evento con cuatro números. Tres de ellos describen la posición del mismo.

Podrían ser, por ejemplo, millas al norte y al este de Oxford, y altura sobre

el nivel del mar. En una escala mayor, podrían representar la latitud y la

longitud galácticas, y la distancia desde el centro de la galaxia. El cuarto

número, es el tiempo del evento. Así, uno puede pensar sobre el espacio y el

tiempo en forma conjunta, como una entidad tetradimensional llamada

espacio-tiempo. Cada punto del espacio tiempo está determinado por cuatro

números que especifican su posición en el espacio y en el tiempo. Combinar de

esta forma el espacio y el tiempo resultaría bastante trivial, si uno pudiera descombinarlos de una manera única, es decir, si hubiera

una única forma de definir el tiempo y la posición de cada evento.

Sin embargo, en un importantísimo artículo escrito en 1905, cuando

era un empleado de la Oficina Suiza de Patentes, Einstein demostró que el

tiempo y la posición en los cuales uno piensa que ocurrió un evento, dependían

de cómo uno se estaba moviendo. Esto significaba que el espacio y el tiempo

estaban indisolublemente ligados el uno con el otro. Los tiempos que diferentes

observadores le asignarían a los eventos estarían de acuerdo si los

observadores no se estaban moviendo en relación de unos con los otros. Pero

diferirían en forma creciente de acuerdo a cuanto mayor fueran sus velocidades

relativas. Así que uno puede preguntarse cuán rápido debe moverse para que el

tiempo de un observador pudiera marchar hacia atrás con relación al tiempo de

otro observador. La respuesta se da en la siguiente jocosa quintilla:

Había una jovencita en Granada

Que más rápido que la luz viajaba,

Un día inició su partida

De una forma relativa

Y regresó en la previa alborada.

Así que todo lo que necesitamos para viajar en el tiempo es una

astronave que vaya más rápido que la luz. Desafortunadamente, en el mismo

artículo Einstein demostró que la energía necesaria para acelerar a una

astronave crecía cada vez más y más, a medida que se acercaba a la velocidad de

la luz. Así que se necesitaría una cantidad infinita de energía para acelerar

más allá de la velocidad de la luz.

El artículo de Einstein de 1905 parecía eliminar la posibilidad de

viajar hacia el pasado. También indicaba que el viaje espacial hacia otras

estrellas sería un asunto lento y tedioso. Si uno no podía viajar más rápido

que la luz, el viaje de ida y vuelta hasta la estrella más cercana tomaría por

lo menos ocho años, y hasta el centro de la galaxia un mínimo de ochenta mil

años. Si la nave viajara muy cerca de la velocidad de la luz, podría parecerle

a la tripulación abordo de la misma que el viaje al centro galáctico hubiera

durado solamente unos pocos años. Pero eso no sería de mucho consuelo, si

cuando volvieran a casa todos los que hubieran conocido hubieran estado muertos

y olvidados hace miles de años. Eso no era muy bueno para los “westerns”

espaciales, así que los escritores de ciencia-ficción tuvieron que buscar en

otros lados para soslayar esta dificultad.

En un artículo de 1915, Einstein mostró que los efectos de la

gravedad podrían ser descritos, suponiendo que el espacio-tiempo era curvado o

distorsionado por la materia y la energía que contenía. Podemos observar

realmente esta curvatura producida por la masa del Sol, en la ligera curvatura

sufrida por la luz o las ondas de radio que pasan cerca del Sol. Esto ocasiona

que la posición aparente de la estrella o de la fuente de radio-ondas se

traslade ligeramente, cuando el Sol se encuentra entre la Tierra y el objeto

observado. El cambio de posición es muy pequeño, de alrededor de una milésima

de grado, equivalente a un desplazamiento de una pulgada a la distancia de una

milla. No obstante, puede ser medido con mucha precisión, y concuerda con las

predicciones de la Relatividad General. Tenemos evidencia experimental de que

el espacio y el tiempo están curvados. La combadura en nuestro vecindario

espacial es muy pequeña, porque todos los campos gravitacionales en el sistema

solar son débiles. Sin embargo, sabemos que pueden ocurrir campos muy fuertes,

por ejemplo durante el Big Bang, o en los agujeros

negros.

Así, el espacio y el tiempo pueden ser lo suficientemente curvados

como para satisfacer las demandas de la ciencia-ficción, en cosas tales como

impulsos hiper-espaciales, agujeros de gusano, o

viajes en el tiempo. A primera vista, todo esto parece ser posible. Por

ejemplo, en 1948, Kurt Goedel halló una solución a

las ecuaciones de campo de la Relatividad General que representa un universo en

el que toda la materia está rotando. En este universo, sería posible partir

hacia el espacio en una astronave y regresar antes del despegue. Goedel estaba en el Instituto de Estudios Avanzados en

Princeton, donde Einstein pasó también sus últimos años. Era más conocido por

probar que no se podía probar nada como verdadero, aún en un asunto

aparentemente tan simple como la aritmética. Pero lo que probó acerca de que la