SINGULARIDAD

Guerra atómica

accidental

¡Un asesino en

serie anda suelto! ¡Un terrorista suicida! ¡Cuidado con la última mutación del

virus! Aunque las alertas que acaparan titulares infunden más temor, es más

probable que nos afecte el viejo y odioso cáncer. Aunque hay menos del 1% de

probabilidad al año de padecerlo, si se vive lo bastante hay muchas

posibilidades de contraerlo al fin. Lo mismo pasa con la guerra atómica

accidental. A lo largo del medio siglo que llevamos los humanos equipados para

un Armagedón nuclear, han habido noticias constantes de falsas alarmas que ya

podían haber desencadenado una guerra abierta, debidas a fallos en

computadoras, averías energéticas, desatinos en los servicios de inteligencia,

errores de navegación, atentados terroristas y estallidos de satélites. La

desclasificación progresiva de archivos ha revelado que algunos de estos

incidentes nucleares entrañaron riesgos mayores de lo que se creyó en su

momento. Por ejemplo, hasta 2002 no se supo a ciencia cierta que durante la

crisis de los misiles de Cuba, el destructor estadounidense Beale lanzó cargas

de profundidad contra un submarino no identificado que en realidad era una nave

soviética provista de armas nucleares y cuyos mandos discutieron si responder

con un torpedo nuclear.

A pesar del fin de

la Guerra Fría, lo más probable es que el peligro haya aumentado en los últimos

años. Misiles balísticos intercontinentales de poca precisión pero de gran

potencia afianzaron la estabilidad de la «destrucción mutua asegurada», porque

atacar primero no evitaría una respuesta masiva. La deriva hacia una navegación

de misiles más fina, tiempos de vuelo más cortos y el rastreo mejorado de

submarinos enemigos socavan esa estabilidad. Un sistema de defensa antimisiles

eficaz completaría este proceso de deterioro. Tanto Rusia como Estados Unidos

mantienen sus estrategias de lanzamiento de misiles en caso de alerta, las

cuales obligan a tomar la decisión de efectuar un lanzamiento en un intervalo

temporal de entre cinco y quince minutos, insuficiente seguramente para

disponer de una información completa.

El 25 de enero de

1995, el presidente ruso Boris Yeltsin estuvo a varios minutos de iniciar un

ataque nuclear total contra Estados Unidos debido a un cohete científico

noruego sin identificar. Ha causado preocupación un proyecto de Estados Unidos

para sustituir las cabezas nucleares por ojivas convencionales en dos de los 24

misiles balísticos intercontinentales D5 que portan los submarinos Trident,

para su posible uso contra Irán, Rusia o Corea del Norte: los sistemas rusos de

alerta incrementa las posibilidades de malentendidos desafortunados. Otras

situaciones alarmantes incluyen conductas indeseadas deliberadas por parte de

mandos militares debidas a desórdenes mentales y/o aspiraciones

políticas/religiosas extremistas. Ahora mismo, la situación en Ucrania con la

Rusia de Putin invadiendo el país a sangre y fuego con la intención de disuadir

a este país de entrar en la OTAN, es causa de preocupación mundial. Los dos

actores, Putin y la OTAN, disponen de una ingente cantidad de armamento

nuclear.

Pero ¿por qué

preocuparse? Seguro que, si las cosas se ponen feas, habrá gente razonable que

intervenga y actúe de manera correcta, como ya ocurrió en el pasado. De hecho,

las potencias nucleares cuentan con complejas medidas de prevención, igual que

el cuerpo las tiene contra el cáncer. El cuerpo humano suele superar mutaciones

aisladas perjudiciales, y al parecer se precisa la coincidencia fortuita de

hasta cuatro mutaciones para desencadenar ciertos cánceres. Pero si tiramos los

dados las veces suficientes, las cosas pasan.

El estallido

accidental de un conflicto nuclear entre dos superpotencias puede ocurrir o no

en el transcurso de nuestras vidas, pero si sucediera, está claro que lo

trastocaría todo. El cambio climático que nos preocupa en la actualidad se

quedaría en nada comparado con un invierno nuclear, donde una nube de polvo de

dimensiones planetarias impediría el paso de la luz del Sol durante años, de

forma muy similar a cuando un asteroide o un supervolcán generaron las

extinciones masivas en el pasado. Las crisis económicas de 2008 y de 2020 no

serían nada en absoluto comparadas con las pérdidas de cultivos, el colapso de

las infraestructuras y la hambruna generalizada consiguientes, y los

supervivientes sucumbirían a manos de pandillas armadas en busca de alimentos

que emprenderían saqueos sistemáticos casa por casa. ¿Lo veremos a lo largo de

una vida? Le daría un 30 % de probabilidades, casi las mismas que hay de

contraer un cáncer.

Sin embargo,

dedicamos menos atención y recursos a reducir el riesgo de un desastre nuclear

que al cáncer. Y, si bien la humanidad en su conjunto sobreviviría aunque el 30

% de ella desarrollara cáncer, está menos claro en qué medida sobreviviría

nuestra civilización a un Armagedón nuclear. Podemos adoptar medidas concretas

y claras para rebajar este riesgo, tal como explican numerosos informes de

organizaciones científicas, pero estos nunca se convierten en los

principales puntos de las campañas electorales de los países y suelen ignorarse

en gran medida.

Una

singularidad hostil

La Revolución

Industrial nos brindó máquinas más fuertes que nosotros. La revolución de la

información nos ha dotado de máquinas hasta cierto punto más listas que

nosotros. ¿Hasta qué punto? Las computadoras solían superarnos tan solo en

tareas cognitivas simples, de «fuerza bruta», como el cálculo veloz o las

búsquedas en bancos de datos, pero en el año 2006, una computadora derrotó al

campeón mundial de ajedrez Vladímir Krámnik, y en 2011 una computadora destronó

a Ken Jennings en el programa televisivo estadounidense Jeopardy, un concurso

de preguntas y respuestas variadas. En el año 2012 una computadora obtuvo la

licencia para conducir coches en Nevada (EE. UU.) tras considerarse más segura

que un conductor humano. ¿A dónde llegará este avance? ¿Acabarán superándonos

en todo las computadoras, cuando hayan desarrollado una inteligencia

sobrehumana? Hay pocas dudas de que puede pasar: el cerebro humano consiste en

un montón de partículas sujetas a las leyes de la Física, y no existe ninguna

ley que impida que las partículas se ordenen de un modo que les permita

efectuar cálculos cada vez más avanzados.

Pero ¿sucederá de

verdad? ¿Y será algo bueno o malo? Estas son preguntas muy oportunas: aunque

hay quien piensa que las máquinas con una inteligencia sobrehumana no son

viables en un futuro cercano, también hay quien prevé su existencia para 2030,

como el inventor y escritor estadounidense Ray Kurzweil, lo que convierte este

asunto en el único riesgo existencial que deberíamos estudiar con más urgencia.

La

idea de la singularidad

En resumen, no

está claro si el desarrollo de máquinas ultrainteligentes debería o llegará a

producirse, y los expertos en inteligencia artificial se muestran divididos. Si

ocurriera, podría tener unos efectos desastrosos. El matemático británico

Irving Good explicó el por qué en 1965:

«Definamos una

máquina ultrainteligente como una máquina capaz de sobrepasar con mucho todas

las actividades intelectuales de cualquier ser humano, por muy listo que este

sea. Como el diseño de máquinas es una de esas actividades intelectuales, una máquina

ultrainteligente podría diseñar máquinas aún mejores; se produciría, sin lugar

a dudas, una “explosión de inteligencia”, y la inteligencia humana quedaría muy

rezagada. Por tanto, la primera máquina ultrainteligente es el último invento

que nos hará falta idear a los humanos, siempre que esa máquina sea lo bastante

dócil para indicarnos cómo mantenerla bajo control».

En un artículo

sugerente y sensato de 1993, el matemático y autor de obras de ciencia ficción

Vernor Vinge llamó a esta explosión de inteligencia «la singularidad»,

argumentando que hay un punto más allá del cual nos es imposible emitir

predicciones fiables. Si logramos confeccionar tales máquinas

ultrainteligentes, la primera de ellas estará muy limitada por el software

desarrollado para ella, y que compensaremos la falta de conocimientos para la

programación óptima de inteligencia mediante el desarrollo de hardware con unas

capacidades computacionales muy superiores a las del cerebro humano. Al fin y

al cabo, las neuronas humanas no son mejores ni más numerosas que las de los

delfines, solo que están conectadas de otra manera, lo que induce a pensar que

en ocasiones el software es más importante que el hardware.

Es probable que

esta coyuntura permita a la primera máquina perfeccionarse en extremo una y

otra vez mediante la mera reescritura de su propio software. En otras palabras,

mientras que los humanos tardamos millones de años en evolucionar y superar con

creces la inteligencia de nuestros ancestros simiescos, esta máquina en

evolución también podría sobrepasar la inteligencia de sus ancestros, nosotros,

en cuestión de horas o segundos.

Después de eso, la

vida en la Tierra nunca será la misma. La persona o la cosa que controle esta

tecnología atesorará con rapidez la mayor riqueza y el mayor poder del mundo,

con lo que burlará todos los mercados financieros y desarrollará más inventos y

patentes que todos los investigadores humanos juntos. Mediante el diseño de

hardware y software informáticos extremadamente perfeccionados, esas máquinas

multiplicarán con rapidez su capacidad y su número. Pronto se inventarían

tecnologías muy apartadas de nuestra imaginación actual, incluidas algunas

armas consideradas necesarias. A eso le seguirá sin tardanza el control

político, militar y social del mundo. Dada la influencia que ejercen hoy en día

los libros, los medios de comunicación y los contenidos de Internet, máquinas

capaces de publicar miles de millones de obras más que los humanos

ultrabrillantes nos conquistarán los corazones y las mentes incluso sin

necesidad de comprarnos o someternos.

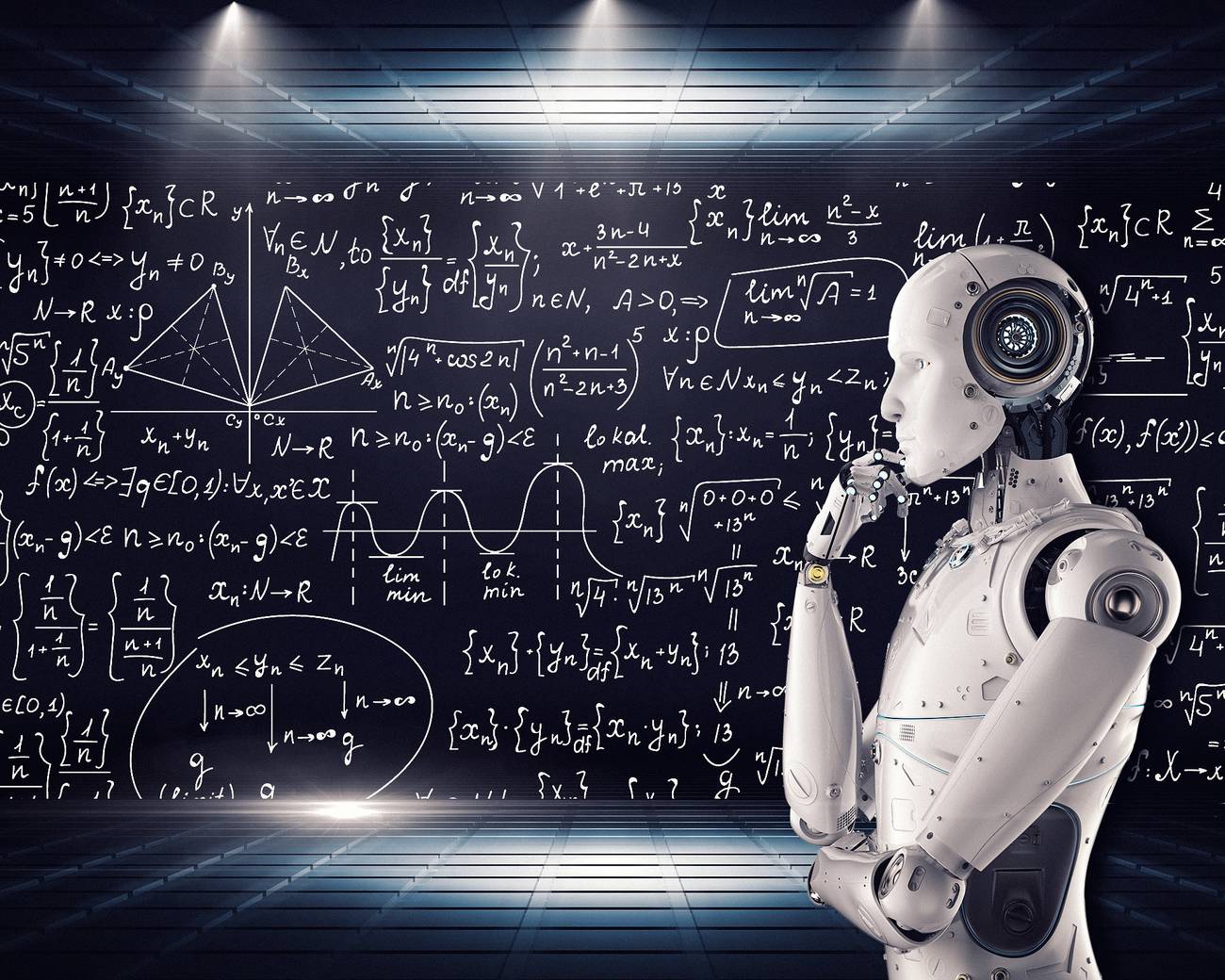

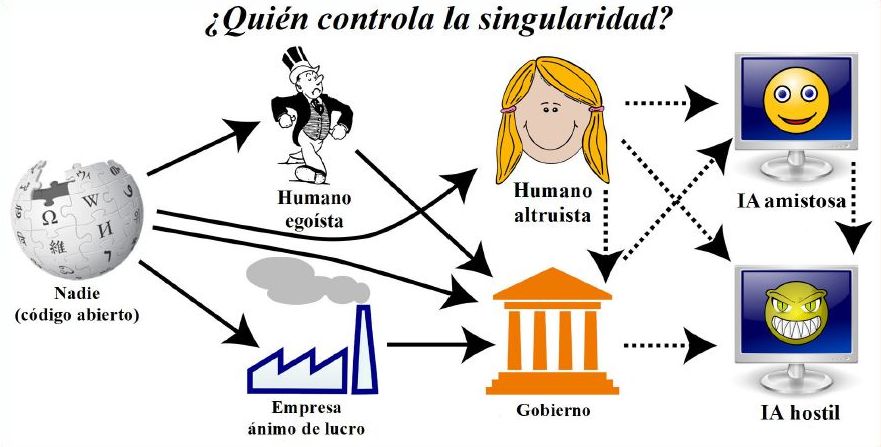

¿Quién

controla la singularidad?

Si ocurriera una

singularidad, ¿cómo afectaría a la civilización humana? Desde luego no lo

sabemos con seguridad, pero creo que dependerá que qué o quién la controle

desde un principio, tal como se ilustra en la figura 3. Si esa tecnología la

desarrollan, en sus inicios, académicos u otras personas dispuestas a

convertirla en código abierto, la situación resultante de «barra libre» será

muy inestable y derivará en el control por parte de una sola entidad después de

un breve periodo de competición. Si esa entidad es un humano egoísta o una

empresa con ánimo de lucro, creo que no tardará en asumir el control

gubernamental en cuanto su dueño controle el mundo y asuma el gobierno. Una

persona altruista tal vez haría lo mismo.

Si de verdad

ocurriera la singularidad, los resultados serían muy distintos dependiendo de

quién la controlara. La opción «nadie» es absolutamente inestable y que, tras

un breve periodo de competición, conducirá al control por parte de una sola

entidad. El control en manos de una persona egoísta o de una empresa con ánimo

de lucro acabaría llevando al control gubernamental en cuanto el dueño se

hiciera con el mundo y se erigiera en gobierno. Es posible que una persona altruista

hiciera eso mismo, o que decidiera cederle el control a una inteligencia

artificial (IA) amistosa más capacitada para proteger los intereses humanos.

Sin embargo, también podría ser que una IA hostil acabara convirtiéndose en el

mando único si superara en inteligencia a su creador y desarrollara con rapidez

características que consolidaran su poder.

Quizá resulte

imposible mantener sometidas a esas IA superinteligentes por mucho que

intentemos contenerlas manteniéndolas desconectadas de Internet. Como podrán

comunicarse con nosotros, es posible que lleguen a conocernos lo bastante bien

como para averiguar cómo adularnos para que hagamos algo aparentemente inocuo

que les permita «soltarse», propagarse como un virus y tomar el control. Dudo

mucho que pudiéramos contener una fuga así, en vista de lo que nos cuesta

erradicar hasta los virus informáticos actuales, desarrollados por humanos e

inmensamente más simples. Para prevenir una evasión o para servir mejor a los

intereses humanos, puede que el dueño elija ceder poder de manera voluntaria a

lo que el experto en inteligencia artificial Eliezer Yudkowsky denomina una «IA

amistosa» que, por muy avanzada que llegue a ser, siempre conserve el objetivo

de ejercer unos efectos positivos, nunca negativos, sobre la humanidad. Si esta

idea funcionara, las IA amistosas actuarían como dioses benevolentes, o como

guardianes, que nos mantendrían alimentados, seguros y satisfechos al tiempo

que conserváramos el control con firmeza.

Si todos los

humanos fueran reemplazados en el trabajo por máquinas supeditadas al control

de una IA amistosa, la humanidad podría seguir disfrutando de una felicidad

aceptable si los productos que necesitamos se nos brindaran a cambio de nada.

En cambio, en el caso de que un humano egoísta o una empresa con ánimo de lucro

controlara la singularidad, seguramente llegaríamos a la mayor disparidad en el

reparto de la riqueza que ha conocido jamás el planeta, pues la historia revela

que la mayoría de los humanos preferimos acumular riquezas personales en lugar

de repartirlas.

Pero hasta los

planes mejor concebidos fallan a menudo, y una situación controlada por una IA

amistosa también podría ser inestable y transformarse a la larga en otra

controlada por una IA hostil, cuyas aspiraciones no coincidieran con las

nuestras, y cuyas actuaciones acabaran destruyendo tanto la humanidad como todo

lo que nos importa. Esa destrucción tal vez fuera indirecta, en lugar de

intencionada: puede que la IA solo quisiera usar los átomos de la Tierra para

propósitos incompatibles con nuestra existencia. La comparación con la manera

en que los humanos tratamos a formas de vida inferiores no es nada alentadora:

cuando queremos construir una presa hidroeléctrica y hay hormigas en la zona

que se ahogarán como consecuencia, construimos la presa igualmente, no porque

sintamos alguna antipatía hacia las hormigas, sino por la mera razónde que le

damos prioridad a objetivos que consideramos más importantes.

La realidad interior de la vida

ultra inteligente

Si hubiera una

singularidad, ¿serían conscientes y autoconscientes las IA resultantes?

¿Tendrían una realidad interior? De no ser así, serían zombis a todos los

efectos prácticos. De todas las características que posee la forma de vida

humana, la consciencia es, con gran diferencia, la más notable. Ella es la que

da sentido al Universo, de modo que si el Universo fuera tomado por formas de

vida carentes de esta propiedad, perdería todo el sentido y no sería más que un

inmenso desperdicio de espacio.

La naturaleza de

la vida y la consciencia es un asunto muy discutido. Esos fenómenos pueden

existir de un modo mucho más general que en los ejemplos basados en el carbono

que conocemos. La consciencia es la manera en que se percibe la información

cuando se está procesando. Como la materia se puede organizar para procesar

información de muchas maneras con una complejidad muy diversa, esto implica una

abundante variedad de niveles y clases de consciencia. El tipo particular de

consciencia que conocemos de forma subjetiva es, pues, un fenómeno que surge en

ciertos sistemas físicos altamente complejos que reciben, procesan, almacenan y

generan información. Está claro que si se pueden ensamblar átomos para crear

humanos, las leyes de la Física también permiten confeccionar una cantidad

inmensa de otras formas avanzadas de vida sensible.

Por consiguiente,

si los humanos acabáramos desencadenando el desarrollo de entidades más

inteligentes a través de una singularidad, es muy probable que también ellas

tuvieran consciencia de sí mismas, y en tal caso deberían contemplarse no como

meras máquinas inertes, sino como seres conscientes como nosotros. No obstante,

es posible que la percepción subjetiva de su consciencia difiriera bastante de

la nuestra. Por ejemplo, seguramente carecerían del intenso miedo humano a la

muerte: como harían copias de seguridad de sí mismas, lo único que podrían

perder serían los recuerdos acumulados desde la copia archivada más reciente.

La capacidad de copiar información y software con facilidad entre varias IA

probablemente reduciría la firme sensación de individualidad que tanto

caracteriza a la consciencia humana: habría menos diferencias entre nosotros si

nos resultara trivial compartir y copiar todos los recuerdos y habilidades, así

que un grupo de IA cercanas quizá se sintiera más bien como un único organismo

con una mente colectiva.

Si esto fuera así,

entonces la supervivencia de la vida a largo plazo se podría compaginar con el

argumento del día del juicio final: lo que acabará no es la vida en sí, sino

nuestra clase de referencia, momentos del observador autoconscientes cuya

percepción subjetiva percibe aproximadamente como nuestra mente humana. Aunque

una multitud de sofisticadas mentes colectivas colonizara este Universo a lo

largo de miles de millones de años, el hecho de que no seamos ellas no tendría

que causarnos más sorpresa que el hecho de que no seamos hormigas.

Reacciones

ante la singularidad

Las reacciones de

la gente ante la posibilidad de una singularidad varían enormemente. La idea de

IA amistosas tiene una historia venerable en la literatura de ciencia ficción

fundamentada en las tres famosas leyes de la robótica de Isaac Asimov,

destinadas a garantizar una relación armónica entre los robots y los humanos.

También abundan las historias en las que IA superan en inteligencia y atacan a

sus creadores, como en las películas de la saga de Terminator.

Muchos rechazan la

singularidad como «el delirio de los locos de la informática», y la ven como

una idea disparatada de ciencia ficción que no llegará a suceder, al menos no

en un futuro próximo. Según otros, es probable que ocurra y, si no se planifica

con esmero, seguramente acabará, no ya con la especie humana, sino también con

todo lo que nos ha importado desde siempre, tal como analizamos antes. Muchos

investigadores contemplan la singularidad como el riesgo existencial más serio

de nuestro tiempo. Algunos de ellos consideran que si no se puede garantizar la

idea de la IA amistosa de Yudkowsky y otros, lomejor será mantener las IA

futuras sujetas a un férreo control humano o no llegar a desarrollar jamás IA

avanzadas.

Aunque hasta ahora

hemos centrado nuestra exposición en las consecuencias negativas de la

singularidad, otros, como Ray Kurzweil, creen que la singularidad sería algo

enormemente positivo, de hecho, lo mejor que podría pasarle a la humanidad,

porque resolvería todos los problemas actuales de la gente. ¿Atrae o espanta la

idea de que la humanidad sea reemplazada por formas de vida más avanzadas? Probablemente

dependa en gran medida de las circunstancias, y en particular de si

contemplamos los seres del futuro como descendientes o como invasores.

Si un padre tiene

un hijo que lo supera en inteligencia, que aprende de él y que, al irse, llega

hasta donde él ni siquiera llegó a soñar, seguramente se sentirá feliz y

orgulloso aunque sepa que no vivirá para ver todos sus éxitos. Pero el padre de

un asesino en serie muy inteligente se siente de otra manera. Tal vez sintamos

una relación similar a la de un padre con su hijo con las IA del futuro, y las

contemplemos como herederas de nuestros valores. Por tanto, será muy distinto

si la vida avanzada del futuro conserva o no nuestras aspiraciones más

preciadas.

Otro factor clave

consiste en si la transición será gradual o abrupta. A pocas personas les

preocupará la idea de que la humanidad evolucione poco a poco, en el transcurso

de milenios, para volverse más inteligente y mejor adaptada al entorno

cambiante, tal vez variando incluso de aspecto físico en el proceso. Por otra

parte, muchos padres se enfrentarían a sentimientos contrapuestos si supieran

que tener el hijo soñado les costaría la vida. Si la tecnología avanzada del

futuro no nos reemplaza de golpe, sino que nos moderniza y mejora de forma

progresiva hasta fundirse a la larga con nosotros, nos permitirá conservar

nuestras metas y nos brindará la gradación necesaria para que contemplemos las

formas de vida posteriores a la singularidad como descendientes nuestras.

Los teléfonos

móviles e Internet ya han incrementado la capacidad humana para alcanzar lo que

queremos sin alterar demasiado nuestros valores esenciales, y los optimistas de

la singularidad creen que lo mismo ocurrirá con los implantes cerebrales, los

dispositivos controlados por la mente y hasta la instauración completa de la

mente humana en una realidad virtual. Es más, eso podría lanzarnos al espacio,

la última frontera. Al fin y al cabo, lo más probable es que una forma de vida

extremadamente avanzada capaz de propagarse por todo este Universo solo emerja

en dos pasos: primero la evolución da lugar a seres inteligentes surgidos por

selección natural, y después estos eligen ceder la antorcha de la vida creando

consciencias más avanzadas, capaces de perfeccionarse solas. Libres de las

limitaciones del cuerpo humano, estas formas de vida avanzada podrán alzarse y

a la larga colonizar buena parte del Universo observable, una idea tanteada

desde hace mucho por autores de ciencia ficción, aficionados a la IA y

pensadores transhumanistas.

En resumen, ¿habrá

una singularidad dentro de unas pocas décadas? Y ¿debemos favorecerlo o

evitarlo? Creo que es justo afirmar que no estamos nada cerca del consenso

sobre ninguno de estos interrogantes, pero eso no significa que lo razonable

sea no hacer nada al respecto. Podría ser lo mejor o lo peor que le haya

ocurrido jamás a la humanidad, de modo que con que haya tan solo un 1 % de

posibilidades de que se produzca una singularidad a lo largo de nuestra vida,

creo que lo lógico sería tomar la precaución de dedicar al menos un 1 % del PIB

a estudiar el asunto y decidir qué hacer.

Pero ¿por qué no

lo hacemos?

© 2022 Javier De Lucas