UIVERSO EN CUERDAS

Imagine un universo en el que para entender algo usted tendría que entenderlo todo. Un universo en el que para decir algo acerca de por qué un planeta describe órbitas en torno a una estrella, de por qué una pelota de béisbol sigue una trayectoria particular, de cómo funciona un imán o una batería, de cómo actúan la luz y la gravedad, un universo en el que para decir algo acerca de algo, usted necesitaría desvelar las leyes más fundamentales y determinar cómo actúan sobre los constituyentes más finos de la materia. Afortunadamente, este universo no es nuestro universo.

Si lo fuera, es difícil ver cómo hubiera podido avanzar la ciencia. Durante siglos, la razón por la que hemos sido capaces de avanzar es que hemos sido capaces de trabajar por partes; hemos sido capaces de desvelar misterios paso a paso, y cada nuevo descubrimiento iba un poco más lejos que el anterior. Newton no necesitó saber sobre los átomos para hacer grandes avances en la comprensión del movimiento y la gravedad. Maxwell no necesitó saber sobre electrones y otras partículas cargadas para desarrollar una poderosa teoría del electromagnetismo. Einstein no necesitó abordar la encarnación primordial del espacio y el tiempo para formular una teoría de cómo se curvan al servicio de la fuerza gravitatoria. Más bien, cada uno de estos descubrimientos, así como los muchos otros que subyacen a nuestra concepción actual del cosmos, tuvo lugar dentro de un contexto limitado que inevitablemente dejaba muchas cuestiones básicas sin respuesta.

Cada descubrimiento pudo aportar su propia pieza al rompecabezas, incluso si nadie sabía, y seguimos sin saber, qué gran imagen de síntesis comprende todas las piezas del rompecabezas. Una observación íntimamente relacionada es que aunque la ciencia de hoy difiere drásticamente de la de hace incluso cincuenta años, sería simplista resumir el progreso científico como una sucesión de nuevas teorías que destronan a sus predecesoras. Una descripción más correcta es que cada nueva teoría refina a su predecesora proporcionando un marco más exacto y de más amplio alcance. La teoría de la gravedad de Newton ha sido reemplazada por la relatividad general de Einstein, pero sería ingenuo decir que la teoría de Newton era falsa. En el dominio de los objetos que no se mueven en ningún lugar a una velocidad próxima a la de la luz y no producen campos gravitatorios tan intensos como los de agujeros negros, la teoría de Newton es fantásticamente precisa.

Pero esto no quiere decir que la teoría de Einstein sea una variante menor de la de Newton; al mejorar la aproximación a la gravedad de Newton, Einstein introdujo todo un nuevo esquema conceptual, un esquema que alteraba radicalmente nuestra comprensión del espacio y el tiempo. Pero la potencia del descubrimiento de Newton dentro del dominio que él pretendía (movimiento planetario, movimiento terrestre común y demás) es incuestionable.

Imaginamos que cada nueva teoría nos lleva más cerca del escurridizo objetivo de la verdad, pero la pregunta de si hay o no una teoría final, una teoría que no pueda ser refinada más, porque ha revelado finalmente el funcionamiento del universo en el nivel más profundo posible, es una pregunta que nadie puede responder. Incluso así, la pauta seguida durante los trescientos últimos años de descubrimientos nos ofrece unos indicios tentadores de que puede desarrollarse una teoría semejante. Hablando en general, cada nuevo avance importante ha reunido un abanico más amplio de fenómenos físicos bajo menos paraguas teóricos. Los descubrimientos de Newton mostraron que las fuerzas que gobiernan el movimiento planetario son las mismas que las que gobiernan la caída de objetos aquí en la Tierra.

Los descubrimientos de Maxwell demostraron que electricidad y magnetismo son dos caras de la misma moneda. Los descubrimientos de Einstein demostraron que espacio y tiempo son tan inseparables como el toque de Midas y el oro. Los descubrimientos de una generación de físicos a principios del siglo XX establecieron que miríadas de misterios de la microfísica podían explicarse con precisión utilizando la mecánica cuántica. Más recientemente, los descubrimiento de Glashow, Salam y Weinberg demostraron que el electromagnetismo y la fuerza nuclear débil son dos manifestaciones de una única fuerza, la fuerza electro-débil, y existe incluso evidencia circunstancial y provisional de que la fuerza nuclear fuerte puede unirse a la fuerza electrodébil en una síntesis aún mayor. Juntando todo esto, vemos una pauta que va de la complejidad a la simplicidad, una pauta que va de la diversidad a la unidad. Las flechas explicatorias parecen estar convergiendo en un marco poderoso todavía por descubrir que unificaría todas las fuerzas de la Naturaleza y toda la materia dentro de una única teoría capaz de describir todos los fenómenos físicos.

El crédito por iniciar la búsqueda moderna de una teoría unificada se atribuye correctamente a Albert Einstein, quien durante más de tres décadas trató de combinar electromagnetismo y relatividad general en una única teoría. Durante largos períodos en esas décadas, él fue el único buscador de esa teoría unificada, y su búsqueda apasionada pero solitaria le alienó de la corriente principal de la comunidad de la física. Durante los últimos 20 años, sin embargo, ha habido un resurgimiento en la búsqueda de una teoría unificada; el sueño solitario de Einstein se ha convertido en la fuerza impulsora para toda una generación de físicos. Pero con los descubrimientos realizados desde la época de Einstein se ha producido un desplazamiento en el centro de atención. Incluso si aún no tenemos una teoría satisfactoria que combine la fuerza nuclear fuerte y la fuerza electrodébil, estas tres fuerzas (electromagnética, débil, fuerte) han sido descritas por un único lenguaje uniforme basado en la mecánica cuántica.

Pero la relatividad general, nuestra teoría más refinada de la cuarta fuerza, queda fuera del marco. La relatividad general es una teoría clásica: no incorpora ninguno de los conceptos probabilistas de la teoría cuántica. Un objetivo primordial del programa de unificación moderno es, por consiguiente, combinar relatividad general y mecánica cuántica, y describir las cuatro fuerzas dentro del mismo marco mecanocuántico. Esto ha resultado ser uno de los problemas más difíciles a los que se ha enfrentado nunca la física teórica. Veamos por qué.

Agitación cuántica y espacio vacío

Si yo tuviera que seleccionar la característica única y más reveladora de la mecánica cuántica, habría escogido el principio de incertidumbre. Probabilidades y funciones de onda proporcionan ciertamente un marco radicalmente nuevo, pero es el principio de incertidumbre el que resume la ruptura con la física clásica. Recordemos que en los siglos XVII y XVIII los científicos creían que una descripción completa de la realidad física equivalía a especificar las posiciones y velocidades de cada constituyente de la materia que formaba el cosmos. Y con la llegada del concepto de campo en el siglo XIX, y su posterior aplicación a las fuerzas electromagnética y gravitatoria, esta visión se amplió para incluir el valor de cada campo, es decir, la intensidad de cada campo, y la velocidad de cambio del valor de campo, en cada lugar en el espacio. Pero en la década de 1930, el principio de incertidumbre desmanteló esta idea de la realidad al demostrar que no se puede conocer a la vez la posición y la velocidad de una partícula; no se puede conocer a la vez el valor de un campo en un lugar en el espacio y con qué rapidez está cambiando el valor del campo. La incertidumbre cuántica lo prohíbe.

Esta incertidumbre cuántica asegura que el micromundo es un reino agitado y turbulento. Antes, nos centramos en las agitaciones cuánticas inducidas por la incertidumbre para el campo inflatón, pero la incertidumbre cuántica se aplica a todos los campos. El campo electromagnético, los campos de las fuerzas nucleares fuerte y débil, el campo gravitatorio, todos están sometidos a frenéticas agitaciones cuánticas en escalas microscópicas. De hecho, estas agitaciones del campo existen incluso en el espacio que usted hubiera considerado vacío normalmente, espacio que no parecería contener materia ni campos. Ésta es una idea de importancia crítica, pero si usted no la ha encontrado con anterioridad es natural que esté intrigado. Si una región del espacio no contiene nada, si es un vacío, ¿no significa eso que no hay nada que se pueda agitar? Bien, ya aprendimos que el concepto de nada es sutil. Piense simplemente en el océano de Higgs que según la teoría moderna permea el espacio vacío. Las agitaciones cuánticas a las que me refiero ahora sirven solamente para hacer la noción de «nada» todavía más sutil. He aquí lo que quiero decir.

En la física precuántica (y preHiggs), hubiéramos declarado que una región del espacio está completamente vacía si no contenía partículas y el valor de cualquier campo era uniformemente cero. Consideremos ahora esta noción clásica de vacío a la luz del principio de incertidumbre cuántico. Si un campo llegara a tener y mantener un valor nulo, conoceríamos su valor, cero, y también la velocidad de cambio de su valor, también cero. Pero según el principio de incertidumbre, es imposible que ambas propiedades estén definidas a la vez. En su lugar, si un campo tiene un valor definido en un instante, cero en nuestro caso, el principio de incertidumbre nos dice que su velocidad de cambio es completamente aleatoria. Y una velocidad de cambio aleatoria significa que en instantes posteriores el valor del campo fluctuará aleatoriamente arriba y abajo, incluso en lo que normalmente consideramos como espacio completamente vacío. De modo que la noción intuitiva de vacío, una noción en la que todos los campos tienen y mantienen el valor cero, es incompatible con la mecánica cuántica. El valor de un campo puede fluctuar alrededor del valor cero pero no puede ser uniformemente cero en una región durante más de un breve instante. En lenguaje técnico los físicos dicen que los campos sufren fluctuaciones del vacío.

La naturaleza aleatoria de las fluctuaciones de campo del vacío asegura que en todas las regiones salvo las más microscópicas hay tantas variaciones «arriba» como «abajo» y por ello su promedio es cero, de la misma forma que la superficie de una canica parece perfectamente lisa a simple vista incluso si un microscópico electrónico revela que está rayada a escalas minúsculas. No obstante, incluso si no podemos verlas directamente, hace más de medio siglo que la realidad de las agitaciones del campo cuántico, incluso en el espacio vacío, fue establecida de forma concluyente gracias a un descubrimiento sencillo pero profundo.

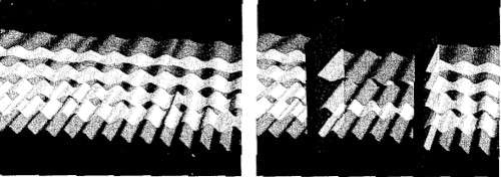

En 1948, el físico holandés Hendrik Casimir calculó cómo podrían detectarse experimentalmente las fluctuaciones de vacío del campo electromagnético. La teoría cuántica dice que las agitaciones del campo electromagnético en el espacio vacío adoptarán diversas formas, como se ilustra en la figura siguiente 1a. La idea de Casimir consistió en advertir que colocando dos placas metálicas ordinarias en una región por lo demás vacía, como en la figura 1b, se podría inducir una sutil modificación en estas agitaciones de campo de vacío. Es decir, las ecuaciones cuánticas muestran que en la región comprendida entre las placas habrá menos fluctuaciones (sólo están permitidas aquellas fluctuaciones del campo electromagnético cuyos valores se anulan en la posición de cada placa). Casimir analizó las consecuencias de esta reducción en las agitaciones del campo y encontró algo extraordinario. De la misma forma que una reducción en la cantidad de aire en una región crea un desequilibrio de presión (por ejemplo, a gran altitud usted puede sentir que el aire más enrarecido ejerce menos presión sobre el exterior de sus tímpanos), la reducción en las agitaciones del campo cuántico entre las placas también produce un desequilibrio de presión: las agitaciones de campo cuántico entre las placas se hacen un poco más débiles que las de fuera de las placas, y este desequilibrio impulsa a las placas una hacia otra.

FIGURA 1. (a) Fluctuaciones de vacío del campo electromagnético, (b) Fluctuaciones de vacío entre dos placas metálicas y las exteriores a las placas

Piense en lo extraño que es esto. Usted coloca dos placas metálicas ordinarias, lisas y descargadas, en una región vacía del espacio, una frente a otra. Puesto que sus masas son minúsculas, la atracción gravitatoria entre ellas es tan pequeña que puede ser completamente ignorada. Puesto que no hay nada más alrededor, usted concluye naturalmente que las placas no se moverán. Pero no es esto lo que los cálculos de Casimir predecían que sucedería. Él concluyó que las placas serían guiadas suavemente por el brazo fantasmal de las fluctuaciones de vacío cuántico para moverse una hacia otra.

Cuando Casimir anunció por primera vez estos resultados teóricos no existían aparatos suficientemente sensibles para poner a prueba sus predicciones. Pero antes de una década, otro físico holandés, Marcus Spaamay, pudo iniciar el primer test rudimentario de esta fuerza de Casimir, y desde entonces se han realizado experimentos cada vez más precisos. En 1997, por ejemplo, Steve Lamoreaux, entonces en la Universidad de Washington, confirmó las predicciones de Casimir con una precisión del 5 por 100.163 (Para placas del tamaño aproximado de una carta de baraja y separadas una diezmilésima de centímetro, la fuerza entre ellas es aproximadamente igual al peso de una simple lágrima; esto muestra el reto que supone medir la fuerza de Casimir.) Ahora hay pocas dudas de que la noción intuitiva de espacio vacío como un escenario estático, tranquilo, uniforme carece de base. Debido a la incertidumbre cuántica, el espacio vacío rebosa de actividad cuántica.

Los científicos necesitaron la mayor parte del siglo XX para desarrollar por completo las matemáticas necesarias para describir dicha actividad cuántica de la fuerza electromagnética y las fuerzas nucleares fuerte y débil. Los esfuerzos valieron la pena: los cálculos realizados con esta herramienta matemática coinciden con los hallazgos experimentales con una precisión sin paralelo (e. g., los cálculos del efecto de las fluctuaciones del vacío sobre las propiedades magnéticas de los electrones coinciden con los resultados experimentales hasta una parte en mil millones). Pero a pesar de todos estos éxitos, durante muchas décadas los físicos han sido conscientes de que las agitaciones cuánticas han estado fomentando el descontento dentro de las leyes de la física.

Agitaciones y su descontento

Hasta ahora sólo hemos discutido agitaciones cuánticas para campos que existen dentro del espacio. ¿Qué pasa con las agitaciones cuánticas del propio espacio? Aunque esto pueda sonar misterioso, realmente es sólo otro ejemplo de agitación de campo cuántica, un ejemplo, sin embargo, que se muestra particularmente problemático. En la teoría de la relatividad general Einstein estableció que la fuerza gravitatoria puede describirse por deformaciones y curvas en el tejido del espacio; demostró que los campos gravitatorios se manifiestan a través de la forma o la geometría del espacio (y del espaciotiempo, con más generalidad). Ahora bien, igual que cualquier otro campo, el campo gravitatorio está sometido a agitaciones cuánticas. El principio de incertidumbre asegura que sobre escalas de distancias minúsculas, el campo gravitatorio fluctúa arriba y abajo. Y puesto que el campo gravitatorio es sinónimo de la forma del espacio, tales agitaciones cuánticas significan que la forma del espacio fluctúa aleatoriamente.

Una vez más, como sucede con los ejemplos de incertidumbre cuántica, en escalas de distancias cotidianas las agitaciones son demasiado pequeñas para sentirse directamente, y el entorno circundante parece liso, plácido y predecible. Pero cuanto más pequeña es la escala de la observación, más grande es la incertidumbre, y más tumultuosas se hacen las fluctuaciones cuánticas.

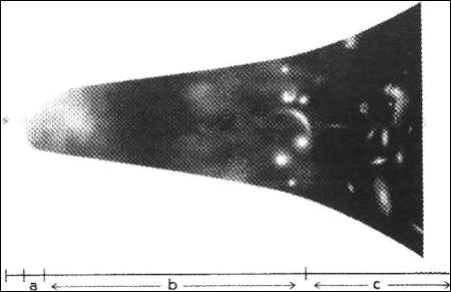

FIGURA 2. Amplificaciones sucesivas del espacio revelan que por debajo de la longitud de Planck el espacio se hace irreconociblemente tumultuoso debido a las agitaciones cuánticas. (Éstas son lentes de aumento imaginarias, cada una de las cuales amplifica entre 10 millones y 100 millones de veces.)

Esto se ilustra en la figura 2, en la que ampliamos secuencialmente el tejido del espacio para revelar su estructura a distancias cada vez menores. El nivel más bajo de la figura muestra las ondulaciones cuánticas del espacio en las escalas familiares y, como se puede ver, no hay nada que ver, las ondulaciones son inobservablemente pequeñas, de modo que el espacio parece tranquilo y plano, pero cuando seguimos ampliando secuencialmente la región, vemos que las ondulaciones del espacio se hacen cada vez más frenéticas. En el nivel superior de la figura, que muestra el tejido del espacio a escalas más pequeñas que la longitud de Planck, una milbillonésima de trillonésima (10-33) de centímetro, el espacio se hace un caldero hirviente de fluctuaciones frenéticas. Como deja claro la ilustración, las nociones habituales de izquierda/derecha, atrás/adelante y arriba/abajo quedan tan revueltas en el tumulto ultramicroscópico que pierden todo significado. Incluso la noción habitual de antes/después, que hemos estado ilustrando por rebanadas secuenciales en la barra del espaciotiempo, pierde significado por las fluctuaciones cuánticas en escalas de tiempo más cortas que el tiempo de Planck, aproximadamente una diezmillonésima de trillonésima de trillonésima (10-43) de segundo (que es aproximadamente el tiempo que tarda la luz en recorrer una longitud de Planck).

Como una fotografía borrosa, las ondulaciones salvajes en la figura 2 hacen imposible distinguir inequívocamente una rebanada temporal de otra cuando el intervalo temporal entre ellas se hace más corto que el tiempo de Planck. El resultado es que en escalas más cortas que las distancias y duraciones de Planck, la incertidumbre cuántica hace el tejido del cosmos tan retorcido y distorsionado que los conceptos habituales de espacio y tiempo ya no son aplicables. Aunque exótica en detalle, la lección de trazo grueso ilustrada por la figura es una con la que ya estamos familiarizados: conceptos y conclusiones relevantes en una escala pueden no ser aplicables en todas las escalas. Éste es un principio clave en física, y un principio que encontramos repetidamente incluso en contextos mucho más prosaicos.

Tomemos un vaso de agua. Describir el agua como un líquido suave y uniforme es a la vez útil y relevante en escalas cotidianas, pero es una aproximación que se viene abajo si analizamos el agua con precisión submicroscópica. A escalas minúsculas, la imagen suave da paso a un marco completamente diferente de moléculas y átomos ampliamente separados. Análogamente, la figura 2 muestra que la idea de Einstein, de un espacio geométrico y un tiempo uniformes y suavemente curvados, aunque poderosa y precisa para describir el universo a grandes escalas, se viene abajo si analizamos el universo a escalas de tiempo y distancia extraordinariamente cortas. Los físicos creen que, como sucede con el agua, la imagen suave del espacio y el tiempo es una aproximación que cede paso a otro marco más fundamental cuando se considera a escalas ultramicroscópicas. Cuál es ese marco, qué constituye las «moléculas» y «átomos» de espacio y tiempo, es una cuestión que actualmente se persigue con gran vigor. Todavía está por resolver.

Incluso así, lo que queda absolutamente claro de la figura 2 es que en escalas minúsculas el carácter suave del espacio y el tiempo imaginado por la relatividad general se da de bruces con el carácter frenético y agitado de la mecánica cuántica. El principio central de la relatividad general de Einstein, que espacio y tiempo tienen una forma geométrica que se curva suavemente, se da de bruces con el principio central de la mecánica cuántica, el principio de incertidumbre que implica un ambiente salvaje, tumultuoso y turbulento en las escalas más minúsculas. El choque violento entre las ideas centrales de la relatividad general y la mecánica cuántica ha hecho de la fusión de las dos teorías uno de los desafíos más difíciles con que los físicos han tropezado durante los últimos ochenta años.

¿Importa?

En la práctica, la incompatibilidad entre la relatividad general y la mecánica cuántica se manifiesta de una forma muy concreta. Si usted utiliza las ecuaciones combinadas de la relatividad general y la mecánica cuántica, casi siempre dan una respuesta: infinito. Y ése es un problema. Es absurdo. Los experimentadores nunca miden una cantidad infinita de nada. Los botones de los aparatos nunca giran hasta el infinito. Los metros nunca llegan al infinito. Las calculadoras nunca registran infinito. Casi siempre, una respuesta infinita carece de significado. Todo lo que nos dice es que las ecuaciones de la relatividad general y de la mecánica cuántica, cuando se fusionan, pierden sentido.

Nótese que esto es totalmente distinto de la tensión entre relatividad especial y mecánica cuántica a la que llegamos en nuestra discusión de la no localidad cuántica. Allí encontramos que reconciliar las principios de la relatividad especial (en particular, la simetría entre todos los observadores a velocidad constante) con el comportamiento de las partículas entrelazadas requiere una comprensión más completa del problema de la medida cuántica que la que se ha conseguido hasta ahora. Pero esta cuestión no completamente resuelta no da lugar a inconsistencias matemáticas o a ecuaciones que den respuestas absurdas. Por el contrario, las ecuaciones combinadas de la relatividad especial y la mecánica cuántica han sido utilizadas para hacer las predicciones confirmadas con más exactitud en la historia de la ciencia.

La tensión silencios entre relatividad especial y mecánica cuántica apunta a un área que necesita más desarrollo teórico, pero apenas tiene ningún impacto en su poder predictivo combinado. No sucede lo mismo con la unión explosiva entre relatividad general y la mecánica cuántica, en la que se pierde todo poder predictivo. No obstante, usted puede seguir preguntando si la incompatibilidad entre relatividad general y mecánica cuántica importa realmente. Ciertamente, las ecuaciones combinadas pueden dar lugar a absurdos, pero ¿cuándo necesita realmente utilizarlas juntas? Años de observaciones astronómicas han mostrado que la relatividad general describe el macromundo de estrellas, galaxias, e incluso la extensión entera del cosmos con impresionante precisión; décadas de experimentos han confirmado que la mecánica cuántica hace lo mismo para el micromundo de moléculas, átomos y partículas subatómicas. Puesto que cada teoría funciona maravillosamente en su propio dominio, ¿por qué preocuparse en combinarlas? ¿Por qué no mantenerlas separadas? ¿Por qué no utilizar la relatividad general para objetos que son grandes y masivos, la mecánica cuántica para objetos que son minúsculos y ligeros, y celebrar la impresionante hazaña de la Humanidad que supone el comprender satisfactoriamente un abanico tan amplio de fenómenos físicos?

En la práctica, esto es lo que la mayoría de los físicos han hecho desde las primeras décadas del siglo XX, y no hay que negar que ha sido un enfoque bastante fructífero. El progreso que ha hecho la ciencia trabajando en este marco disjunto es impresionante. Sin embargo, hay varias razones por las que el antagonismo entre la relatividad general y la mecánica cuántica debe reconciliarse. He aquí dos de ellas.

En primer lugar, a un nivel visceral es difícil aceptar que la comprensión más profunda del universo consiste en una unión incómoda entre dos poderosos marcos teóricos que son mutuamente incompatibles. El universo no viene equipado con una línea en la arena que separa los objetos que son adecuadamente descritos por la mecánica cuántica de los objetos adecuadamente descritos por la relatividad general. Dividir el universo en dos dominios separados parece artificial y caprichoso. Para muchos, esto es prueba de que debe haber una verdad más profunda y unificada que supera el abismo entre relatividad general y mecánica cuántica y que puede aplicarse a cualquier cosa. Tenemos un universo y, por lo tanto, muchos creen firmemente que deberíamos tener una teoría.

En segundo lugar, aunque la mayoría de los objetos son o grandes y pesados o pequeños y ligeros, y por consiguiente, en la práctica, pueden describirse utilizando la relatividad general o la mecánica cuántica, esto no es cierto para todos los objetos. Los agujeros negros proporcionan un buen ejemplo. Según la relatividad general, toda la materia que constituye un agujero negro está comprimida en un único punto minúsculo en el centro del agujero negro. Esto hace el centro de un agujero negro enormemente masivo e increíblemente minúsculo, y con ello cae a ambos lados de la divisoria propuesta: necesitamos utilizar la relatividad general porque la masa grande crea un campo gravitatorio importante, y también tenemos que utilizar la mecánica cuántica porque toda la masa está comprimida en un tamaño minúsculo. Pero en combinación, las ecuaciones dejan de ser válidas, de modo que nadie ha sido capaz de determinar lo que sucede precisamente en el centro de un agujero negro.

Éste es un buen ejemplo, pero si usted es un escéptico real, aún podría preguntar si esto es algo que no dejará dormir por la noche. Puesto que no podemos ver dentro de un agujero negro a menos que saltemos a su interior y, además, si saltáramos al interior no seríamos capaces de comunicar nuestras observaciones al mundo exterior, nuestra comprensión incompleta del interior de un agujero negro quizá no le parezca particularmente preocupante. Para los físicos, sin embargo, la existencia de un dominio en el que dejan de ser válidas las leyes conocidas de la física, por muy esotérico que el dominio pudiera parecer, levanta las banderas de alarma. Si las leyes conocidas de la física dejan de ser válidas bajo cualesquiera circunstancias, es una clara señal de que no hemos alcanzado el conocimiento más profundo posible. Después de todo, el universo funciona; hasta donde podemos decir, el universo no se viene abajo.

La teoría correcta del universo debería satisfacer, como mínimo, el mismo estándar. Bien, eso ciertamente parece razonable. Pero para mí, la plena urgencia del conflicto entre relatividad general y mecánica cuántica se revela solamente a través de otro ejemplo. Veamos la figura 3

FIGURA 3 Una línea cronológica de evolución cósmica, (a) Ráfaga inflacionaria. (b) Evolución big bang estándar, (c) Era de expansión acelerada.

Como puede ver, hemos dado grandes zancadas al componer una historia consistente y predictiva de la evolución cósmica, pero la imagen sigue siendo incompleta debido a la región borrosa cerca del nacimiento del universo. Y dentro de la neblina de estos primerísimos instantes hay una intuición sobre el más tentador de los misterios: el origen y naturaleza fundamental del espacio y el tiempo. ¿Qué nos ha impedido penetrar en la niebla? La culpa recae directamente en el conflicto entre la relatividad general y la mecánica cuántica. El antagonismo entre las leyes de lo grande y las de lo pequeño es la razón de que la región borrosa permanezca oscura y todavía no tengamos una idea de lo que sucedió en el comienzo mismo del universo.

Para entender por qué, imagine que pasa una película del cosmos en expansión al revés, hacia el big bang. Al revés, todo lo que ahora se está apartando se acerca, y por eso, cuando más atrás vamos en la película, más pequeño, más caliente y más denso se hace el universo. Cuando nos acercamos al instante cero, el universo observable entero está comprimido en un tamaño similar al del Sol, luego más comprimido en el tamaño de la Tierra, luego estrujado hasta el tamaño de una bola de bolos, un guisante, un grano de arena, el universo se contrae cada vez a medida que la película se rebobina hacia sus fotogramas iniciales. Llega un momento en esta película pasada al revés en el que todo el universo conocido tiene un tamaño cercano a la longitud de Planck, la milbillonésima de trillonésima de centímetro en la que la relatividad general y la mecánica cuántica se encuentran enfrentadas. En este momento toda la masa y toda la energía responsables de generar el universo observable están contenidas en una mota que es menor que una centésima de trillonésima del tamaño de un simple átomo. Así pues, como sucede en el caso del centro de un agujero negro, el universo primitivo cae a ambos lados de la divisoria. La enorme densidad del universo primitivo requiere el uso de la relatividad general.

El minúsculo tamaño del universo primitivo requiere el uso de la mecánica cuántica. Pero una vez más, en combinación las leyes se vienen abajo. El proyector se atranca, la película cósmica se quema, y somos incapaces de acceder a los primerísimos instantes del universo. Debido al conflicto entre la relatividad general y la mecánica cuántica, seguimos ignorantes de lo que sucedió en el principio y nos vemos reducidos a dibujar una región borrosa en la figura. Si queremos entender alguna vez el origen del universo, una de las preguntas más profundas de toda la ciencia, debemos resolver el conflicto entre la relatividad general y la mecánica cuántica. Debemos zanjar las diferencias entre las leyes de lo grande y las leyes de lo pequeño y fundirlas en una única teoría armoniosa.

El improbable camino a una solución

Como ejemplifica la obra de Newton y Einstein, las grandes ideas científicas nacen a veces del genio de un único científico, puro y simple. Pero eso es raro. Con mucha más frecuencia las grandes ideas representan el esfuerzo colectivo de muchos científicos, cada uno de los cuales construye sobre las ideas de los otros para conseguir lo que ningún individuo podría haber conseguido aisladamente. Un científico podría aportar una idea que pone en marcha el pensamiento de un colega, que lleva a una observación que revela una relación inesperada que inspira un avance importante, lo que inicia de nuevo el ciclo de descubrimiento. Conocimiento amplio, facilidad técnica, flexibilidad de pensamiento, apertura a conexiones inesperadas, inmersión en el flujo libre de ideas, trabajo duro y suerte son las partes críticas del descubrimiento científico. En tiempos recientes quizá no ha habido un avance más importante que ejemplifique esto mejor que el desarrollo de la teoría de supercuerdas.

La teoría de supercuerdas es una aproximación que muchos científicos creen que fusiona satisfactoriamente la relatividad general y la mecánica cuántica. Y como veremos, hay razones para esperar aún más. Aunque hay todavía mucho trabajo en marcha, la teoría de supercuerdas puede ser una teoría completamente unificada de todas las fuerzas y toda la materia, una teoría que alcance el sueño de Einstein y más allá, una teoría, creemos yo y muchos otros, que está señalando los inicios de un camino que nos llevará un día a las más profundas leyes del universo. A decir verdad, sin embargo, la teoría de supercuerdas no estaba concebida como un medio ingenioso para alcanzar estos viejos y nobles objetivos. En su lugar, la historia de la teoría de supercuerdas está llena de descubrimientos accidentales, salidas en falso, oportunidades erradas y casi carreras hundidas. Es también, en un sentido preciso, la historia del descubrimiento de la solución correcta al problema erróneo.

En 1968, Gabriele Veneziano, un joven investigador posdoctoral que trabajaba en el CERN, era uno de los muchos físicos que trataban de entender la fuerza nuclear fuerte estudiando los resultados de colisiones de partículas de alta energía producidas en aceleradores de átomos en todo el mundo. Tras meses de analizar pautas y regularidades en los datos, Veneziano reconoció una conexión sorprendente e inesperada con un área esotérica de las matemáticas. Se dio cuenta de que una fórmula con doscientos años de antigüedad descubierta por el famoso matemático suizo Leonhard Euler (la función beta de Euler) parecía encajar con precisión los datos de la fuerza nuclear fuerte. Aunque esto pudiera no sonar particularmente anormal, los físicos teóricos trabajan continuamente con fórmulas arcanas, era un caso sorprendente de un carro que rueda kilómetros por delante del caballo. En la mayor parte de los casos los físicos elaboran primero una intuición, una imagen mental, una amplia idea de los principios físicos subyacentes a lo que quiera que estén estudiando, y sólo entonces buscan las ecuaciones necesarias para basar su intuición en matemáticas rigurosas.

Veneziano, por el contrario, saltó directo a la ecuación; su brillantez consistió en reconocer pautas inusuales en los datos y establecer el vínculo imprevisto con una fórmula concebida siglos antes por intereses puramente matemáticos. Pero aunque Veneziano tenía la fórmula a mano, no tenía ninguna explicación de por qué funcionaba. Carecía de una imagen física de por qué la función beta de Euler debería ser relevante para las partículas que se influyen mutuamente a través de la fuerza nuclear fuerte. En menos de dos años la situación cambió por completo. En 1970, artículos de Leonard Susskind de Standford, Holger Nielsen del Instituto Niels Bohr y Yohichiro Nambu de la Universidad de Chicago revelaron los soportes físicos del descubrimiento de Veneziano.

Estos físicos demostraron que si la fuerza fuerte entre dos partículas fuera debida a una hebra minúscula, extraordinariamente delgada, casi como una goma elástica que conectara las partículas, entonces los procesos cuánticos que Veneziano y otros habían estado examinando se describirían matemáticamente utilizando la fórmula de Euler. Las pequeñas hebras elásticas fueron bautizadas como cuerdas y ahora, colocado el caballo adecuadamente delante del carro, la teoría de cuerdas había nacido oficialmente. Para los implicados en esta investigación, era gratificante entender el origen físico de la intuición de Veneziano, puesto que sugería que los físicos estaban en el camino para desenmascarar la fuerza nuclear fuerte. Pese a todo, el descubrimiento no fue acogido con entusiasmo universal.

Lejos de ello. Muy lejos. De hecho, el artículo de Susskind fue devuelto por la revista a la que lo envió con el comentario de que el trabajo era de mínimo interés, una valoración que Susskind recuerda muy bien:

«Estaba desconcertado, me caía de la silla, estaba deprimido, así que me fui a casa y me puse a beber»

Finalmente, su artículo y los otros que anunciaban el concepto de cuerda fueron publicados, pero eso fue no mucho antes de que la teoría sufriera otros dos reveses devastadores. Una examen detallado de datos más refinados sobre la fuerza nuclear fuerte, recogidos durante los primeros años de la década de 1970, mostraron que la aproximación de la cuerda no podía describir adecuadamente los resultados más recientes. Además, una nueva propuesta llamada cromodinámica cuántica, que estaba firmemente enraizada en los ingredientes tradicionales de partículas y campos, nada de cuerdas en absoluto, fue capaz de describir convincentemente todos los datos. Y así, en 1974 la teoría de cuerdas había recibido un doble K. O. O así parecía.

John Schwarz no se rinde

John Schwarz era uno de los primeros entusiastas de las cuerdas. En una ocasión que desde el primer momento él había tenido una sensación visceral de que la teoría era profunda e importante. Schwarz pasó varios años analizando sus diversos aspectos matemáticos; entre otras cosas, esto llevó al descubrimiento de la teoría de supercuerdas, como veremos, un refinamiento importante de la propuesta de cuerdas original. Pero con el ascenso de la cromodinámica cuántica y el fracaso del marco de las cuerdas para describir la fuerza fuerte, la justificación para seguir trabajando en teoría de cuerdas empezaba a agotarse. No obstante, había un desajuste concreto ente la teoría de cuerdas y la fuerza nuclear fuerte que seguía molestando a Schwarz, y él encontró que no podía dejarla. Las ecuaciones mecanocuánticas de la teoría de cuerdas predecían que una partícula concreta bastante inusual debería ser producida copiosamente en las colisiones a alta energía que tienen lugar en los aceleradores de átomos. La partícula tendría masa nula, como un fotón, pero la teoría de cuerdas predecía que tendría espín dbs, lo que significa, hablando en términos generales, que giraría el doble de rápido que un fotón.

Ninguno de los experimentos había encontrado nunca una partícula semejante, de modo que ésta parecía estar entre las predicciones erróneas de la teoría de cuerdas. Schwarz y su colaborador Joel Scherk se devanaron los sesos con este caso de una partícula ausente, hasta que en un magnífico salto establecieron una conexión con un problema completamente diferente. Aunque nadie había sido capaz de combinar la relatividad general y la mecánica cuántica, los físicos habían determinado ciertas características que surgirían de una unión acertada. Y una característica que encontraron era que de la misma forma que una fuerza electromagnética es transmitida microscópicamente por fotones, la fuerza gravitatoria debería ser transmitida microscópicamente por otra clase de partículas, los gravitones (los paquetes cuánticos más elementales de la gravedad). Aunque los gravitones todavía no han sido detectados experimentalmente, todos los análisis teóricos coinciden en que los gravitones deben tener dos propiedades: deben carecer de masa y deben tener espín dos.

Para Schwarz y Scherk esto hizo sonar una campana, éstas eran precisamente las propiedades de la partícula predicha por la teoría de cuerdas, y les inspiró a hacer una jugada atrevida, una que iba a transformar un fallo de la teoría de cuerdas en un éxito sorprendente. Ellos propusieron que la teoría de cuerdas no debería considerarse como una teoría mecanocuántica de la fuerza nuclear fuerte. Argumentaron que incluso si la teoría había sido descubierta en un intento de comprender la fuerza fuerte, era en realidad la solución a un problema diferente. Era en realidad la primera teoría mecanocuántica de la fuerza gravitatoria. Afirmaron que la partícula sin masa de espín dos predicha por la teoría de cuerdas era el gravitón, y que las ecuaciones de la teoría de cuerdas incorporaban necesariamente una descripción mecanocuántica de la gravedad.

Schwarz y Scherk publicaron su propuesta en 1974 y esperaban una reacción importante por parte de la comunidad física. Pero su trabajo fue ignorado. Visto en retrospectiva, no es difícil entender por qué. Para algunos parecía que el concepto de cuerda se había convertido en una teoría en busca de una aplicación. Parecía que, una vez que el intento de utilizar la teoría de cuerdas para explicar la fuerza nuclear fuerte había fracasado, sus proponentes no aceptaban la derrota y, en su lugar, estaban decididos a encontrar relevancia para la teoría en otro lugar. Se añadió gasolina al fuego de esta visión cuando se hizo evidente que Schwarz y Scherk necesitaban cambiar el tamaño de las cuerdas en su teoría de forma radical para que la fuerza transmitida por los candidatos a gravitón tuviera la intensidad conocida y familiar de la gravedad. Puesto que la gravedad es una fuerza extraordinariamente débil y puesto que, como es el caso, cuanto más larga es la cuerda, más fuerte es la fuerza transmitida, Schwarz y Scherk encontraron que las cuerdas tenían que ser extraordinariamente minúsculas para transmitir una fuerza con la débil intensidad de la gravedad; tenían que tener un tamaño de aproximadamente la longitud de Planck, cien trillones de veces menor que el imaginado previamente. Tan pequeño, señalaban sardónicamente los escépticos, que no había ningún aparato que fuera capaz de verlas, lo que significaba que la teoría no podía ser puesta a prueba experimentalmente.

Por el contrario, la década de 1970 fue testigo de un éxito tras otro para las teorías más convencionales y no basadas en cuerdas, formuladas con partículas puntuales y campos. Teóricos y experimentadores por igual tenían la cabeza y las manos llenas de ideas concretas para investigar y predicciones para comprobar. ¿Por qué dirigirse a la teoría de cuerdas especulativa cuando había tanto trabajo excitante que hacer dentro de un marco de ensayo y error?

En el mismo sentido, aunque los físicos eran conscientes de que el problema de fundir gravedad y mecánica cuántica permanecía irresuelto utilizando métodos convencionales, no era un problema que llamara la atención. Casi todos reconocían que era una cuestión importante que habría que abordar algún día, pero con la riqueza de trabajo aún por hacer sobre las fuerzas no gravitatorias, el problema de cuantizar la gravedad fue relegado a un rincón y, finalmente, a mitad de la década de 1970 la teoría de cuerdas estaba lejos de haber sido completamente desarrollada. Tener un candidato para el gravitón era un éxito, pero todavía había que abordar muchas cuestiones conceptuales y técnicas. Parecía bastante plausible que la teoría fuera incapaz de superar una o más de estas cuestiones, de modo que trabajar en la teoría de cuerdas significaba correr un riesgo considerable. En pocos años la teoría podría estar muerta.

Schwarz no se arredró. Creía que el descubrimiento de la teoría de cuerdas, la primera aproximación plausible para describir la gravedad en el lenguaje de la mecánica cuántica, era una idea importante. Si nadie quería oír, allá ellos. Él seguiría y desarrollaría la teoría, de modo que cuando la gente estuviera dispuesta a prestar atención, la teoría de cuerdas estaría mucho más avanzada. Su determinación se mostró profética.

A finales de los setenta y principios de los ochenta, Schwarz formó equipo con Michael Green, entonces en el Queen Mary College de Londres, y ambos se propusieron trabajar en uno de los obstáculos técnicos a los que se enfrentaba la teoría de cuerdas. Principal entre éstos era el problema de las anomalías. Los detalles no importan, pero, hablando en términos generales, una anomalía es un efecto cuántico pernicioso que condena a una teoría pues da a entender que viola ciertos principios sagrados, tales como la conservación de la energía. Para ser viable, una teoría debe estar libre de anomalías. Las investigaciones iniciales habían revelado que la teoría de cuerdas estaba plagada de anomalías, lo que era una de las principales razones técnicas por las que no había generado mucho entusiasmo. Las anomalías significaban que aunque la teoría de cuerdas parecía proporcionar una teoría cuántica de la gravedad, puesto que contenía gravitones, en una inspección más detallada la teoría adolecía de sus propias y sutiles inconsistencias matemáticas.

Sin embargo, Schwarz se dio cuenta de que la situación no era clara. Había una posibilidad, nada segura, de que un cálculo completo revelara que las diversas contribuciones cuánticas a las anomalías que afectaban a la teoría de cuerdas se cancelaran mutuamente cuando se combinaran de la forma correcta. Junto con Green, Schwarz emprendió la ardua tarea de calcular estas anomalías, y en el verano de 1984 los dos tuvieron su recompensa. Una noche tormentosa, trabajando hasta altas horas en el Centro Aspen de Física en Colorado, completaron uno de los más importantes cálculos del campo, un cálculo que demostraba que todas las anomalías potenciales se cancelaban mutuamente de una forma que parecía casi milagrosa. La teoría de cuerdas, revelaron, estaba libre de anomalías y por ello no adolecía de ninguna inconsistencia matemática. La teoría de cuerdas, demostraron convincentemente, era mecanocuánticamente viable.

Esta vez los físicos escucharon. Era a mediados de la década de 1980 y el clima en física había cambiado considerablemente. Muchas de las características esenciales de las tres fuerzas no gravitatorias habían sido calculadas teóricamente y confirmadas experimentalmente. Aunque quedaban por resolver detalles importantes, y algunos aún no lo están, la comunidad estaba dispuesta a abordar el siguiente problema importante: la fusión de la relatividad general y la mecánica cuántica. Entonces, desde un poco conocido rincón de la física, Green y Schwarz entraron en escena con una propuesta definida, matemáticamente consistente y estéticamente agradable sobre cómo proceder. Casi de la noche a la mañana, el número de investigadores que trabajaban en teoría de cuerdas saltó de dos a más de un millar.

La primera revolución de las cuerdas estaba en marcha

© 2025 JAVIER DE LUCAS