UN SIGLO DE CUANTICA

El estado de la Física a fines del siglo XIX se suponía que era estable. Un universo infinito, que existía desde un tiempo infinito y prolongándose indefinidamente en el tiempo con un espacio absoluto, y un tiempo cósmico, regido por la mecánica newtoniana, con sus principios de conservación de la energía, el impulso, el momento de la cantidad de movimiento; con conservación de la masa, que en última instancia se reducía a partículas materiales, átomos con trayectorias continuas en función del tiempo; existencia de reglas rígidas donde una señal se podrá trasmitir en forma instantánea; y finalmente todo esto conservándose invariante para una transformación de Galileo. Además estaba el campo gravitatorio que llenaba todo el espacio.

En otro orden de cosas, existían las cargas eléctricas, con su campo electromagnético y el principio de conservación de la cantidad de electricidad. Este campo electromagnético podría existir sin tener asiento en la materia, propagándose como una onda que, con sus fenómenos de interferencia y difracción, explicaba el comportamiento de la luz, que era una onda electromagnética. El electromagnetismo era invariante para un tipo de transformación que descubrió Voigt y que luego se llamó de Lorentz. Finalmente, la termodinámica con sus dos principios y su vinculación, a través de la estadística de Maxwell-Boltzman, con la mecánica.

Este era el mundo de la física que llamamos clásica y que existía a fines del siglo XIX. Muchos creían que ya este edificio estaba terminado y que solo faltaban detalles. Sin embargo, había algunas señales que indicaban que debían hacerse algunas modificaciones fuertes. En una dirección, los fenómenos de la radiación del cuerpo negro, la llamada catástrofe del ultravioleta, el espectro de los átomos de materia que emitían radiación y el efecto fotoeléctrico. En otra dirección, la incompatibilidad del electromagnetismo y la mecánica, el uno invariante para la transformación de Lorentz y el otro para la de Galileo, algebraicamente diferentes, aunque coincidentes para la velocidad de la luz igual a infinito.

Otra indicación de que graves problemas se avecinaban provenía de la fotografía, ya descubierta alrededor de 1830. El sistema óptico conducía a la luz hasta la placa fotográfica como onda, llegaba a ella como onda plana, pero al llegar impresionaba algunos gramos de la emulsión fotográfica, no todos. Llegando a la placa se comportaba como compuesta de partículas. Incluso cuando la intensidad luminosa era bajísima, se podían lograr muy pocos puntos de ennegrecimiento. Cambiando la placa y superponiendo los puntos se podrá deducir que este proceso, que era de orden probabilístico, reconstruiría la imagen final. Cada nuevo proceso tenía memoria del anterior y la onda plana al llegar a la placa fotográfica colapsaba en un punto. Todo esto, sin embargo, pasó desapercibido de forma inexplicable.

En esta breve descripción del estado de la física del siglo XIX queremos resaltar el concepto de partícula material y el de onda. El primero como una posición que depende en forma continua a través del tiempo y el segundo como una función del espacio y del tiempo que se adjudica a una porción finita del espacio. El primero se puede adjudicar a una región del espacio de volumen nulo, la segunda siempre necesita un volumen finito, incluso en la forma de paquetes de ondas que sería lo mas próximo entre una onda y una partícula. Otra similitud entre onda y partícula es que a los dos se les puede adjudicar una cantidad de movimiento y una energía. En el caso de las ondas electromagnéticas, las únicas que se conocieron en el siglo XIX, la cantidad de movimiento y la energía aparecen como interacción con las partículas que contienen electricidad: ya se sabía de la existencia de los electrones. Ondas y partículas eran conceptos irreducibles.

Max Karl Ludvig Planck (1858-1947).

La emisión de radiación por un cuerpo a una temperatura dada, tenía un aspecto que la física clásica no podrá explicar. Muy pequeña para frecuencia bajas, pasaba por un máximo y luego disminuía hasta anularse a frecuencias altas. La mecánica estadística clásica de Maxwell-Boltzman, basada en que el espacio de las fases podría subdividirse en celdas tan pequeñas como se quiera, espacio de las fases formado por las coordenadas y cantidades de movimientos de todos los átomo del sistema, asignaba a cada grado de libertad el valor de energía kT/2, donde k era la constante llamada de Boltzaman y T la temperatura absoluta, y un grado de libertad era cada variable independiente que corresponde aquí a una frecuencia. Como hay un número infinito de frecuencias, la cantidad de energía emitida, que abarca todo el espectro de frecuencias, era divergente.

Para ser mas exactos, la energía media emitida en un rango de la frecuencia n , era proporcional al producto de la densidad de frecuencias, proporcional al cuadrado de la frecuencias por la energía media de esa frecuencia kT/2. La manera de solucionar este problema fue que la energía no podrá emitirse ni absorberse en forma continua, sino en forma discreta, por paquetes E, 2E, 3E...., donde E = h v y h una constante, a la que se llamó constante de Planck. Así que los resonadores que componían el cuerpo, en equilibrio con la radiación, solo podrán absorber y emitir la energía en cantidades discretas. Al calcular la energía media, en base a estas hipótesis, en un rango dv de frecuencia v, Planck obtuvo una fórmula que describía los resultados experimentales con exactitud. En esta fórmula figuraban dos constantes, h y k, que luego se llamaría constante de Boltzman. En base a las medidas experimentales pudo Planck determinar h y k. Como k es el producto de la constante de los gases ideales por el número de Avogadro, pudo determinar este número con muy buena coincidencia con el obtenido por otros métodos. Esta coincidencia de un valor determinado por métodos independientes mostró que la teoría estaba muy cerca de la realidad. También pudo determinar, contando con la constante de Faraday, la carga del electrón.

Posteriormente, para poner de acuerdo la naturaleza de una onda electromagnética, la radiación, con la estructura de energías discontinúas, elaboró una teoría de absorción continua de los resonadores y emisión discontinua. Esta teoría no fructificó. Con el objeto de hacer coexistir ondas y discontinuidades elaboró, junto con Poincaré, el espacio discontinuo de fases. Para N partículas tiene 3N velocidades y 3N posiciones, en ese espacio el elemento de volumen con q posiciones y p cantidades de movimientos y h la constante de Planck. Este espacio discontinuo de las fases es el que se usa para las estadísticas cuánticas, Bose-Einstein y Fermi-Dirac. Finalmente descubrió las unidades, llamadas de Planck, en las cuales la velocidad de la luz c, h, k y f (la constante gravitatoria) tienen el valor 1. Estas unidades corresponden a las dimensiones donde las fuerzas básicas, electromagnetismo, gravitación y cuántica están unificadas, o tienen el mismo valor.

1905 Albert Einstein (1879-1955).

El efecto fotoeléctrico fue descubierto por Thomson y Lenard y consistía fundamentalmente en que iluminando un sólido este desprendía electrones. Efectuaron mediciones con un sólido especial, como el Na o K, en alto vacio, luz monocromática y un método para medir la energía de los electrones emitidos. Esta energía no dependía de la intensidad de la luz con que se iluminaba sino de su frecuencia. Se encontró que obedecía a una ley del tipo E = hv - A, donde A es una constante del metal iluminado. Este fenómeno sólo puede interpretarse como una interacción entre partículas que forma la luz, con energía hv, que al chocar con los electrones del metal iluminado, interacciona con ellos y les entregan esta energía. La constante A es la energía necesaria para desplazar el electrón del metal. El número de electrones de energía E depende de la intensidad de la luz. Esta interpretación, trasmitió directamente a la radiación la cuantificación que Planck había dado a los osciladores que emitían y absorbían energía en cuantos. Se creo así el concepto de fotón, partícula luminosa que compone la luz de energía hv. La interacción de la luz como onda absorbida en forma continua por todos los electrones no permite interpretar el fenómeno fotoeléctrico. Pero, una vez más, aparece la dualidad: la luz hasta que incide en el metal se comporta como una onda, interaccionando con él como partícula.

1907. Albert Einstein.

El calor específico de los sólidos, a bajas temperaturas no obedecía a la estadística clásica; según ella, un oscilador en tres dimensiones tenía una energía media de 3 kT por grado de libertad para la posición y para la velocidad. Luego un sólido tenía como energía media 3 NkT . Sin embargo a bajas temperaturas el calor específico disminuye llegando a anularse. Einstein cuantificó los osciladores tridimensionales de los sólidos usando la fórmula de Planck y pudo demostrar este comportamiento. Esto, que fue denominado tercer principio de la termodinámica por Nernst, es ahora un teorema. Esta teoría fue mejorada por Debye, Karman y Born.

1913 Niels Hendrik David Bohr (1885-1962).

El gran problema de la emisión de radiación por un elemento atómico es que, según la teoría clásica, suponiendo un electrón girando alrededor de un núcleo, éste pierde energía en forma continua hasta caer en el núcleo y anularse las cargas eléctricas. Esto no ocurre y las líneas espectrales producidas al dispersar la luz emitida por un elemento incandescente, son estable y discontinuas. Bohr explicó este fenómeno con un modelo de átomo que contaba de dos partes, uno correspondiente a la mecánica clásica. Un electrón de carga -e y masa girando alrededor del núcleo con una frecuencia v, a una distancia r y atraído por el núcleo por una carga positiva +e. La otra obtenida de la experiencia y combinada con la energía cuantizada de Planck. Estas dos expresiones tienen que estar de acuerdo para frecuencias muy bajas, lo cual permite calcular una constante espectroscópica, la llamada de Rydberg, Ro = 2 p2 m e4/h3, con mucha exactitud. La idea de la coincidencia entre la mecánica clásica y la cuántica para frecuencias bajas o velocidades pequeñas se llamara después principio de correspondencia

Theodore Lyman (1874-1954).

Lyman descubre la serie de líneas espectrales que lleva su nombre en el ultravioleta del espectro del hidrógeno. Estas líneas estaban descritas por el modelo de Bohr.

Robert Andrew Millikan.

Determina h con gran exactitud a partir del efecto fotoeléctrico. Así que junto con el método espectroscópico derivado del valor de la constante del Rydberg y el que proviene de la radiación del cuerpo negro, son tres los métodos independientes que dan el mismo valor de h.

Arnold Johannes Wilhem Sommerfeld (1868-1951).

Planck y Poincaré establecieron una condición cuántica para el volumen encerrado en el espacio de las fases en un sistema de energía constante E, que determina una hipersuperficie E(q1 q2,.... q3N, p1, p2, ....., p3N). En el caso de un átomo de hidrógeno, se trata de un área encerrada por una curva. Si esta curva no cierra porque se está en presencia de dos o mas períodos inconmensurables, habrá tantas condiciones cuánticas como períodos. Si el número de período es u y el de grados de libertad v , el grado de degeneración es w = v-u. En el caso del átomo de hidrógeno es simplemente periódica y el electrón tiene tres grados de libertad, así que se trata de un caso de doble degeneración. Esta degeneración se elimina parcialmente introduciendo la variación de la masa con la velocidad. Esto produce una rotación del perihelio, que elimina parcialmente esta degeneración. Esta rotación del perihelio no coincide con el caso real y sólo puede ser explicado, en el caso del planeta Mercurio, mediante la relatividad general. Así que la coincidencia de esta teoría con la experiencia debe considerarse casi casual. De todos modos, con la introducción de tres números cuánticos, el principal, el azimuntal y el complementario, se logró la explicación de los espectros de los átomos de H, He++, Li++, con su estructura fina y el efecto Zeeman, interacción con un campo magnético. También se pudo explicar los espectros de los átomos alcalinos.

James Franck (1882-1964) y Gustav Ludwig Hertz (1887-1975).

La teoría de Bohr tuvo una confirmación en la experiencia de bombardear átomos con electrones.

1916.Gilbert Newton Lewis (1875-1946).

Usando el modelo de Bohr del átomo formado por capas de electrones, describió la unión química con el enlace covalente, donde dos átomos comparten dos electrones completando la capa. El otro enlace es ceder un electrón, como el caso NaCl.

1916.Abert Einstein.

Einstein introduce la idea de momento del fotón. Si a la energía E = hn se le atribuye una masa E = m c2, se tiene hn = mc2 = mc.c = p.c ( ln = c) . Además pudo deducir la ley de radiación de Planck, mediante el concepto de transiciones radiactivas espontáneas entre los niveles En de los átomos de la cavidad y la radiación. Debe complirse Em - En = hn.

1916. Richard Gans (1880-1954).

La luz no se propaga en un medio refringente excitando las moléculas componentes y emitiendo, es decir por un proceso de excitación y emisión. La luz puede propagarse cuando la energía de la onda es inferior a la necesaria para excitar las moléculas. Los fotones pasan a travéz del medio sin roce ni alteración.

1917.Walter Kossel (1888-1956).

Se explica los espectros de rayos X mediante el modelo de Bohr de capas.

Arthur Holly Compton (1892-1962).

Un cuanto de luz al chocar con un electrón le transfiere parte de su energía y momento, y luego de su dispersión, su longitud de onda se hace mayor. Se prueba así la naturaleza corpuscular de la luz.

Louis-Victor Pierre Raymond Prince de Broglie (1892-1987).

Broglie extendió la idea de Einstein del momento del fotón a toda partícula material. Toda partícula material tiene asociada una longitud de onda.

1925 Wolfrang Pauli.

Pauli enuncia al principio de exclusión. Con él se explica por qué cada orbital en un átomo no puede estar con más de dos electrones; además dos sistemas de números cuánticos que pueden deducirse mutuamente por intercambio de los electrones, representan un estado. El segundo principio enuncia la indiscernibilidad de los electrones, importante para la enumeración de los estados posibles, tal como lo exige la teoría del sistema periódico y, en especial, para las estadísticas.

1924. Satyendranath Bose (1894-1974).

Encontró un método para deducir la ley de radiación de Planck basándose exclusivamente en la idea de que la luz está compuesta de fotones. Caracterizando el espacio de las fases por las componentes de la cantidad de movimiento, se obtiene la densidad de estados entre p y p + ?p. Esta capa se divide en celdas de tamaño finito y en ella el número n de fotones puede ocupar de cualquier forma esas celdas. Esta estadística se llama de Bose - Einstein.

1924. Wolfrang Pauli (1900-1958).

Enuncia la idea de que el cuarto número cuántico corresponde al spin del electrón, que puede asimilarse a un momento rotatorio del electrón sobre sí mismo, y que sólo puede tener dos direcciones "arriba" y "abajo".

George Eugene Uhlenbeck (1900-1988) y Sammuel Abrahan Goudsmit (1902 1978).

Explicaron un experimento que implicaba la división de un haz de átomos de plata en dos por un campo magnético. Esta experiencia es de Stern y Gerlach . Sugirieron que esto proviene de que los átomos de Ag poseen un spin. Debido a que los electrones tienen spin, y puesto que el átomo de plata tiene 47 electrones, todos salvo uno de los electrones anulan su spin entre ellos dejando uno solo. Como una mitad de los átomos lo tiene "arriba" la otra mitad lo tiene para "abajo". Esto explica por qué dos electrones pueden ocupar el mismo nivel de energía en el átomo.

1925.Wener Karl Heisenberg (1901-1976), Max Born (1886-1970) y Ernest Pascual Jordan (1902-1980).

Desarrollan la llamada mecánica cuántica de matrices. A toda propiedad clásica como q, p o E, posición, momento o energía, le corresponde una matriz , obedeciendo a las reglas de conmutación .

Paul Adrien Maurice Dirac (1902-1984).

Dirac desarrollo la mecánica de matrices según una versión que se conoce como teoría de operadores o álgebra cuántica.

Max Born.

Introduce la interpretación probabilística de la mecánica cuántica. Todo fenómeno cuántico es de ese tipo.

1926. Enrico Fermi (1901-1954).

Junto con Dirac desarrolló la estadística conocida ahora como de Fermi-Dirac. Se aplica a un gran número de partículas que tienen spin 1/2, como el electrón, y no pueden dos partículas estar en el mismo estado. Luego cada celda del espacio de las fases solo puede estar vacía o contener un electrón. Así que el número total de Fermiones debe ser constante aisladamente en la interacción de partículas. Por lo tanto, el número total de Fermiones debe ser constante en el Universo y debió ser determinado por las condiciones existentes durante el Big-Bang.

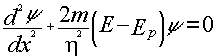

1926.Erwin Schrödinger (1887-1961).

Enunció la mecánica ondulatoria. Mediante una correlación con la óptica se obtiene la ecuación que lleva su nombre. Actualmente se desarrolla en base a postulados que se justifican experimentalmente. Su expresión más simple es

El cuadrado de la función deonda se interpreta como probabilidad por unidad de volumen de existencia de la partícula. La ecuación de Schördinger tiene autofunciones y autovalores que representan los valores necesarios de energía y la probabilidad de existencia de la partícula. Todos los problemas que se resolvieron anteriormente, oscilador armónico, átomo de hidrógeno, etc, encuentran en la ecuación una solución y además se pueden plantear y resolver otros problemas.

1926. Paul Adrien Maurice Dirac.

Dirac muestra que la mecánica de matrices y la de ondas son equivalentes.

Werner Karl Heisemberg.

Heisemberg demuestra el principio de incertidumbre (incerteza) . El producto de la dispersión de variables complementaran (p, q) y (E, t), es mayor o igual a h. A Heisenberg se debe la idea de que la naturaleza onda corpúsculo de una partícula se debe a que son "guiadas" por "ondas piloto".

Walter Heitler (1904-1981) y Fritz Wolgang London (1900-1954).

Heither y London logran calcular la energía de disociación del H2 con mecánica ondulatoria.

1927,Niels Bohr.

Bohr presenta lo que se conocerá en el futuro como interpretación de Copenhagen de la mecánica cuántica. De acuerdo a esa interpretación la medición forma parte del problema, así que lo único que se puede hacer es calcular la probabilidad de que un experimento específico nos dé un resultado particular. Hay experiencias que permiten esclarecer mucho esta interpretación como la experiencia de la interferencia con dos rendijas. Si iluminamos una ranura que a su vez ilumina dos ranuras en una pantalla paralela a la de la primera ranura, colocando una tercera pantalla paralela a las dos primeras, se forman franjas de luz y sombras paralelas a las dos primeras ranuras. Hay luz cuando la luz llega en fase, es decir, difiere en un número entero de ondas; cuando difieren en un número entero más media onda hay sombra. Esta experiencia, que tiene muchas variantes, no puede explicarse sino con la teoría ondulatoria de la luz. La interpretación de Bohr es que el fotón o partícula material existe como superposición de estados cuánticos, que miden las probabilidad de un estado particular. Cuando la onda llega a la tercera pantalla "colapsa" y se produce el impacto puntual. Todo este proceso, que tiene sus antecedentes en el fenómeno fotográfico, no entra dentro de la lógica de la física clásica. Planck, Einstein y Schrödinger no estuvieron de acuerdo con esta interpretación. Einstein mismo ideó experiencias para tratar de poner de manifiesto lo absurdo de esta idea.

1928,Oscar Klein (1894-1977) Paul Adrian Maurice Dirac.

La ecuación relativista de Schrödinger presenta grandes dificultades. La ecuación de Klein-Gordon , para una partícula libre, es más simple, aunque implica, entre otras cosas, la existencia de electrones con carga positiva. Existen también partículas y antipartículas.

1927. Clinton Joseph Davisson (1881-1958), Lester Germer ( ), George Payet Thomson (1892-1975).

Se prueba la naturaleza ondulatoria de la materia mediante la difracción de electrones por una lámina delgada de metal.

1927.Paul Adrian Marie Dirac.

La cuantificación de un campo. La primera cuantificación trata de partículas, electrones, que saltan de un nivel a otro en un átomo. La segunda trata de dos campos y muestra que pueden ser descritos en términos de intercambio de partículas. Hoy sin embargo ha perdido totalmente importancia.

George Gamow (1904-1968).

Gamow explicó la desintegración. Estos cálculos fueron aplicados a las reacciones nucleares dentro de las estrellas. Además se le debe el modelo de la gota líquida del núcleo, donde las partículas del núcleo son contenidas por una especie de tensión superficial.

Werner Karl Heisemberg y Wolfrang Pauli.

Versión Lagrangiana de la mecánica cuántica.

1929.Ernest Pascual Jordan.

Teoría de los operadores para la mecánica cuántica.

1930.Werner Karl Heisenberg.

Se sugiere que el núcleo está formado por partículas que solo difieren en lo que se llama spin isotópico.

1930.Nevill Francis Mott (1905-1996).

Teoría cuántica de las colisiones atómicas

1930.Fritz Wolgang London (1900-1954).

Cálculo de las fuerzas de Van der Walls.

1930.Albert Einstein

Einstein presenta en el Congreso Solvay del año 1930 un argumento para mostrar que se podrá invalidar uno de los principios de incertidumbre .

1930.Julius Robert Oppenheimer (1904-1967) .

Usa las ecuaciones de Dirac para probar la existencia del electrón positivo.

1932.Carl David Anderson (1905-1991).

Descubrimiento del positrón, el electrón positivo, producido por los rayos cósmicos en una cámara de niebla .

1932, John Janos von Neuman (1903-1957).

Publica la prueba errónea de que la Mecánica Cuántica no puede contener variable ocultas. Según la escuela de Copenhagen algo acontece cuando observamos un sistema: colapsan las funciones de onda y el fenómeno ocurre. De acuerdo a las variables ocultas las cosas van ocurriendo, pero con un conocimiento global instantáneo de todo lo que ocurre.

1932.Hans Albreacht Bethe (1906- ) y Enrico Fermi (1901-1954).

Se sugiere el fotón como partícula de intercambio que produce la interacción entre partículas cargadas.

1933. Grette Herman ( ).

Se pone de manifiesto el error de la prueba de von Neuman de que no puede haber variables ocultas. Esto no se toma en centa debido al gran prestigio de von Neuman.

1935. Albert Einstein, Nathan Rosen (1909- ) y Boris Podolsky (1896 - 1966).

Einstein, Rosen y Podolsky llaman la atención sobre una paradoja (E.P.R.) que anula el principio de incertidumbre. Dos partículas parten simultáneamente de un lugar, la cantidad de movimiento total es cero en el momento de partir, a gran distancia una de otra, se mide el momento o cantidad de movimiento de una, luego se conoce el de la otra y además, se puede medir su posición. Con esto se viola el principio de incerteza . Si es válido el principio de incerteza, en todos los casos, al medir el momento de una partícula con un error, automáticamente se produce una incerteza con la otra. Hay que recordar que son respecto de una cantidad grande de medidas. Esta acción a distancia instantánea no permite sin embargo transportar información. Las experiencias, como veremos mas adelante, confirman la acción a distancia y la validez del principio de incertidumbre.

1940. Richard Phillips Feynman (1918-1988) y John Anchibald Wheeler (1911- ).

Feynman y Wheeler desarrollan lo que se llamará la teoría de la absorción de Wheeler - Feynman. Cuando un electrón se acelera radia energía, luego se forma una masa adicional. Esto es válido para cualquier partícula cargada. Considerando el caso más simple posible, que solo haya dos electrones en el universo, el resultado es que entre los dos electrones hay una onda sola que equivale a la solución clásica de las ecuaciones de Maxwell, pero fuera se anulan y esa infinita energía no aparece.

1940. Sin-tiro Tomonaga (1906- 1979), Julian Seymur Schwinger (1918-1994) y Richard Phillips Feynman.

Los tres desarrollan independientemente la Electrodinámica cuántica. Esta describe la interacción entre fotones y partículas cargadas. El éxito de esa teoría se manifestó con la explicación del corrimiento de Lamb en el átomo de hidrógeno y el momento magnético del electrón.

1942. Richard Phillips Feynman.

Feynman propone por primera vez lo que se denomina integrales de camino, una manera de iniciar probabilidades cuánticas basada en el formalismo de Lagrange. La entidad cuántica toma todos los caminos posibles de A a B, en algunos casos se anulan unos a otros salvo la trayectoria clásica. Pero bajo condiciones especiales se obtienen los casos de interferencia de ondas como en la difracción por una rendija o la interferencia por dos. Esta versión es mas satisfactoria que la de Schrödinger, que es Hamiltoniana. La partícula se mueve como si conociera todas las posibles trayectorias; un caso parecido ya ocurría en el principio de Fermat con los fotones.

1947. Willis Engene Lamb (1913- ).

Se mide con exactitud lo que se denomina el corrimiento de Lamb en el átomo de hidrógeno. Ese corrimiento proviene de la interacción del electrón con un campo electromagnético.

1949. Freeman John Dyson (1923- ).

Dyson muestra que las teorías de EDC propuestas por Feynman, Schwinger y Tomonaga son matemáticamente equivalentes.

Hugh Everett (1930-1982).

Everett desarrolla la interpretación de los universos múltiples. La idea es que cada vez que el mundo se enfrenta, en el nivel cuántico, con una elección, el universo se divide en tantos universos como elecciones tiene. Por ejemplo, en la experiencia de las dos ranuras, el electrón pasa por la ranura A en un universo y por la B en el otro . Esta idea es interesante para los cosmologístas quienes pueden obviar la paradoja que ocurre en la escuela de Copenhagen, sobre cuál es la observación que hace colapsar la función de onda que describe la totalidad del universo. La creación de la figura de interferencia en la experiencia de los dos ranuras, necesita de electrones o fotones de los dos universos.

David Joseph Bohm (1917-1992).

Bohm pone de manifiesto que el efecto fotoeléctrico se puede explicar por la absorción de energía de una onda continua en forma discontinua. Una idea similar a la de Planck, que trató de explicar el espectro de radiación del cuerpo negro mediante una absorción continua y una emisión discontinua.

1952.David Joseph Bohm.

Bohm sugiere como experiencia crucial E.P.R una variación con fotones.

1957. John Bardeen (1908-1991), Leon Niels Cooper (1930- ) y John Albert Schrieffer (1931 - ).

Bardeen, Cooper y Schrieffer logran explicar la superconductividad como un fenómeno cuántico. Los electrones interactúan con la red cristalina en pares y esos electrones se comportan como bosones por que los dos medios spin se suman formando un spin uno. Como bosones, todos los electrones ocupan el mismo nivel de energía y pueden ser descritos como una sola función de onda.

1958. Richard Phillips Feynman y Murray Gell-Mann (1929- ).

Desarrollan la teoría de la interacción débil. Las fuerzas de la naturaleza son cuatro, la gravitatoria, la electromagnética y las nucleares, la fuerte y la débil. Estas dos últimas fuerzas están en el núcleo atómico.

La fuerza gravitatoria, que es siempre aditiva, es la que interactúa entre las masas a distancias interplanetarias y mayores, la electromagnética es la que mantiene unidos los átomos para formar moléculas y los electrones al núcleo para formar átomos. Son las fuerzas nucleares fuertes las que mantienen unidas las partículas que forman el núcleo; los neutrones y protones se dispersarían sin estas fuerzas. Es la fuerza que mantienen unidas los quarks a través del intercambio de gluones. Esta fuerza tiene un rango limitado porque los gluones tienen masa, a diferencia de los fotones que transportan las fuerzas electromagnéticas y los gravitones, que transportan la gravedad. El rango de influencia de portadores como los gluones es inversamente proporcional a su masa.

La fuerza débil opera como las otras a través del intercambio de partículas mensajeras, los bosones vectoriales intermedios que tienen masa; por lo tanto su rango de influencia es limitada. Pero además de mantener unidas o separadas a las partículas, cambian la naturaleza de las partículas entre las que se mueve. Afecta a los leptones y hadrones, en particular al proceso de desintegración b. Los bosones tienen una gran masa y un rango de influencia muy corto.

1959. Richards Phillips Feynman.

Sugiere la nanotecnología como posible

1961. Murray Gell-Mann y Yuval Neieman ( ) .

Proponen independientemente, un esquema para clasificar las partículas elementales. Puede afirmarse que los quarks, leptones y los bosones son las únicas partículas elementales. Los bosones son los que transportan fuerza. Hay seis variedades de quarks: up, down, strange, charm, top y bottom y sus antipartículas. Ellos y las partículas en que se combinan para formar los hadrones, están bajo la influencia de la fuerza fuerte. Hay seis tipos de leptones, electrón, muon , tau, electrón neutrino, muon neutrino y tau neutrino y sus antipartículas. Estas últimas seis partículas están bajo la influencia de las fuerzas débiles.

1962 Richards Phillips Feynman.

Feynman introduce el concepto de gravedad cuántica, combinando la teoría general de la relatividad con la mecánica cuántica. El núcleo de la teoría es que la fuerza gravitacional es producida por el intercambio de gravitones, de la misma forma que el intercambio de fotones produce las interacciones electromagnéticas. La principal dificultad en el desarrollo de esta teoría es la equivalencia entre masa inerte y gravitatoria, que no puede expresarse en la mecánica cuántica. Por otra parte los gravitones, por poseer energía, les corresponde una masa que interactúa con todas las otras masas. Esto no ocurre en la Electro Dinámica Cuántica puesto que los fotones, que al tener energía tienen masa, no interactuan con el sistema electromagnético. El gravitón aparece con spin 2. Para evitar estos problemas se introduce la técnica de perturbación. Persisten, sin embargo, los que derivan de la existencia de infinitos.

Brian David Josephson (1940 - ).

Descubre lo que se llamará la unión de Josephson, que permite medir campos magnéticos con gran precisión y puede usarse en computadoras. Se trata de una capa aislante entre dos superconductores.

Chien - Shiang Wa (1912-1997).

Sus experiencias confirman la violación de la paridad en procesos que involucran la interacción débil de Feynman y Gell-Man.

1964. Peter Ware Higgs (1929- ), Robert Brout ( ) y FranVois Englert ( ).

Introducen lo que se llamará partícula de Higgs, que tiene masa. Esto permite que cualquier fotón por absorción de un bosón de Higgs obstenga masa. Así que los portadores de la fuerza débil tienen masa.

John Stuart Bell (1928-1990).

En 1952 Bohm sugirió que la experiencia de Einstein, Podolsky y Rossen (EPR, 1935) podrá efectuarse con fotones. Ahora Bell mostró cómo podía efectuarse el experimento midiendo lo que se denominará desigualdad de Bell.

1964.

Diferentes autores descubren el kaón que produce piones que no conservan la paridad, la partícula omega-menos. Se introduce el cuarto quark para explica los hadrones. Walter Greenberg introduce la "para estadística" que distingue tripletes de quarks que de otra manera serían idénticos

Yoichiro Nambu y M.Y. Han.

Se introduce una teoría matemática de los quarks con el agregado de que están "coloreados". Se esboza una primera teoría de las cuerdas.

1965, Richard Phillips Feynman.

Aparecen los "partones".

John Stuart Bell.

Repite lo que demostró Grete Herman (1933): la prueba de von Neuman (1932) de que no existen variables ocultas en la mecánica cuántica es falsa.

Abdus Salam (1926-1996) y Eugene Paul Wigner (1902-1995).

Se unifica la interacción débil y la electromagnética entre bosones, como interacción electro débil .

Andrei Dimitriedich Sakharov (1921-1989).

Sakharov muestra la asimetría en las leyes de la física. Esto significa que en el principio, el Big-Bang, el universo quedó con aquellas partículas que no se anularon con su antipartícula y se transformaron en el ruido de fondo compuesto por microondas.

1970. Jerome Isaac Friedman (1928- ), Henry Way Kendall (1926- ) y Richard Edward Taylor (1929- ).

Se demuestra experimentalmente la existencia de quarks en el núcleo atómico bombardeable con electrones de alta energía.

1970. Ion Clauser ( ), Michael Horne ( ), Abner Shimony ( ) y Richard Holt ( ).

Demuestran experimentalmente que la desigualdad de Bell no se cumple. Se trata de una versión del experimento EPR y por lo tanto se ve que hay una acción a distancia. El mundo no es local.

1970. Murray Gell-Mann y Harold Fritzsch ( ).

Desarrollan una aproximación tipo teoría de campo describiendo las interacciones entre los quarks, especialmente el cuarto ("charm").

SPEAR (Stanford Positron - Electron Asymmetric Rings).

Se observa por primera vez el efecto jet, generado por quarks, antiquarks o gluones.

1970. Sheldon Lee Glashow (1932 - ).

Desarrolla la interacción electrónica débil de bosones comenzada por Abdus Salam y Steve Weinberg en 1967.

1970. John Schcoarz (1941- ) y André Neveu ( ).

Ecuentran un método para describir los fermíones usando la teoría de las cuerdas.

1974. John Schwarz y Joel Scherk, ( ).

Descubren la conexión entre la teoría de las cuerdas y la gravedad. El origen de la teoría de las cuerdas esta en la teoría de la relatividad de Klein-Kaluza. Cuando se escriben la ecuaciones de la relatividad general en cinco dimensiones aparecen por un lado la ecuaciones del campo gravitatorio y por otro las de Maxwell. Resulta así la primera teoría del campo unificado. Del mismo modo si se escribe la ecuación de Schrödinger en cinco dimensiones, cuatro espaciales y una temporal, se obtienen soluciones que pueden representarse como partículas - ondas que se mueven bajo la influencia de campos electromagnéticos y gravitacionales. Para describir más campos se agregan más dimensiones.

1979. Tony Klein ( ) y colaboradores.

Demuestran la difracción de neutrones y confirman la naturaleza dual, onda-partícula, del neutrón.

1980. John Cramer ( ).

Hasta este momento tenemos dos interpretaciones de la mecánica cuántica: La interpretación de Copenhagen y la interpretación de los universos múltiples. Ahora tenemos una nueva interpretación que no altera las predicciones conocidas. Cramer uso la teoría de Wheler - Feynman de la radiación. Gracias a esta teoría cada parte del universo conoce lo que ocurre en todas las otras partes. En la teoría de Wheler - Feynman hay una onda retardada que fluye hacia el futuro y una onda avanzada que fluye hacia el pasado. En la ecuación de Schrödinger la onda fluye del pasado al futuro, pero cuando se calcula su norma se supone una onda que fluye del futuro al pasado. Cuando esa onda es recibida por otra partícula se produce una respuesta y hay una onda progresiva hacia la primera partícula emisora que cancela la onda regresiva. Así que hay un intercambio instantáneo entre las dos partículas. Cada fotón que es emitido conoce cuándo y cómo va a ser absorbido, sabe - en la experiencia de las dos ranuras - qué clase de detector lo espera. Esta es la interpretación transaccional.

1982. Alain Aspect ( ).

La experiencia de Aspect probó que Einstein (EPR) no tenía razón al creer que la acción a distancia era imposible. La experiencia crucial (EPR) fue transformada por Bohm en una con fotones en lugar de partículas. Bell demostró que si vale la idea de Einstein se cumple una desigualdad llamada de Bell. En sus experiencias Aspect demostró que esta desigualdad es violada. En esta experiencia se usa la emisión de fotones polarizados en forma que se anulan, si uno es "arriba" el otro es "abajo". El universo no es local. Para evitar toda influencia del equipo se cambian los ángulos en que se mide la polarización, pero la desigualdad de Bell es siempre violada.

Richard Phillips Feynman.

Se anuncia la posibilidad de que se construya un computador basado en principios cuánticos.

1985. John Archibald Wheeler (1911- ).

La experiencia sugerida por Wheeler fue realizada en Maryland y Munich con éxito. En la experiencia de la doble ranura, en la pantalla se constata la llegada individual de fotones que forman franjas de interferencia. Cuando se tapa una ranura desaparecen las franjas. Los fotones que pasan por la otra ranura saben que se tapa una. Lo mismo ocurre si se coloca un detector. ¿Qué pasa cuando se coloca un detector después que el fotón paso por una ranura, antes de llegar a la pantalla?. Las nuevas experiencias mostraron que incluso en este último caso las franjas desaparecen. Los fotones saben antes de llegar al detector que éste está puesto. Esto puede realizarse en forma aleatoria e incluso introducir esta aleatoriedad cuando los fotones están ya en vuelo entre el orificio y el detector. Wheeler propone hacer esta experiencia con luz llegada de un quasar por dos caminos, uno directo y el otro a través de una lente gravitacional. En caso de éxito, y esto es lo más probable, el fotón conocería lo que va a pasar con una antelación del orden de 10.000 x 106 años.

1985, Cosmología Cuántica.

Diferentes autores desarrollan lo que puede denominarse cosmología cuántica. El origen del universo es una fluctuación cuántica seguida de un proceso de expansión. En el principio se trata de energía pura contenida en una celda de Planck, luego esa energía se transforma en una capa de protones, electrones y neutrones que se transforma en una mezcla de hidrógeno y helio con algo de deuterio. De aquí saldrán las galaxias que hoy día forman el universo.

1988. Akira Tonomura ( ).

Realizó el experimento de las dos ranuras con electrones pero emitiéndolos uno por vez. Se van formando puntos en la pantalla hasta que finalmente se forma la figura de interferencia. Los electrones se comportan como ondas por la figura de interferencia y como partículas al llegar a la pantalla.

1990. Hendrik Brugt Gerhardt Carimer (1909 - ).

El principio de incertidumbre permite que durante un tiempo exista una energía que aparece y desaparece de y en la nada; como la materia esta formada de energía esto significa que se forman partículas virtuales en el espacio vacío. Como los fotones tienen masa cero son los que mas fácilmente pueden aparecer. Poniendo dos placas reflectantes muy cerca, los fotones que pueden existir allí son los que tienen una longitud de onda múltiplo de esa distancia. Estos son menos de los que hay afuera, luego hay una presión de afuera que tiende a unir las placas. Este efecto también ocurre en los átomos en el vacío. En la Universidad de Yale se midió este efecto para átomos de Na.

El satelite COBE.

Cosmic Background Explorer (COBE). Este satélite encontró fluctuaciones en la radiación de fondo de magnitud de acuerdo a la teoría normal del Big-Bang. La forma de las desigualdades en radiación de fondo muestra la forma de las fluctuaciones que debieran haber imprimido la fluctuaciones cuánticas cuando el tamaño del universo (su radio de curvatura) era del orden de 10-25cm.

1994.

Se crean las condiciones para recrear el plasma quark-gluon haciendo chocar núcleos masivos en aceleradores de partículas produciendo pequeños Big-Bang Los fotones producidos confirman la teoría del Big-Bang.

En Chicago en el Fermilab se identifica el último de los seis quarks.

1994-96 Peter Shor ( ) y Seth Lloyd.

Hay avances en el computador cuántico. Se puede resolver códigos en segundos. La conjetura de Richard Feynman de un computador cuántico como simulador cuántico universal es correcta.

1995.

En los Alamos se mide la masa del electrón neutrino. En el CERN se fabrica el primer antiátomo de Hidrógeno.

Conclusión.

En este breve esquema del desarrollo histórico - crítico de la Mecánica Cuántica se dejo un poco de lado el problema de las partículas, pero se insistió en las experiencias iniciales y su estructura interna. Puede afirmarse que supuesto un espacio infinito de cuatro dimensiones, con un tiempo cósmico y una cantidad de dimensiones extras - de las cuales algunas no se desarrollaron y tienen una dimensión de alrededor de 10-33cm, mas las leyes de la Física, un universo puede surgir de la nada - gracias al principio de incertidumbre y crecer y oscilar con tamaños de 1027cm y períodos de 15.000 x 106 años. Este universo es auto consiente, conoce instantáneamente, en lo que respecta al tiempo cósmico, todo lo que ocurre, y realiza las modificaciones necesarias para que no se viole ninguna ley de la Física. Desde un punto de vista temporal conoce, además, todo lo que ocurrió, lo que ocurre y lo que ocurrirá. Es una figura fija en el espacio (de muchas dimensiones) más el tiempo y es capaz de además de multiplicarse. Esta figura multidimensional nace en un punto del espacio y desaparece en él.

Bibliografía

Born, Max; Física atómica, numerosas ediciones en todos los idiomas desde 1933.

De Broglie, L. y Brillouin, L. Selected Papers on Wave Mechanics, Blackie, 1928.

Dirac, P.A.M., The principles of Quantum Mechanics Clarendor Press, 1935.

Heinsenberg, W., The Principles of Quantum Theory, University of Chicago Press, 1930.

Schorödinger E., Collected Papers on Wave Mechanics, Blackie, 1928.

Sobre los orígenes de la mecánica cuántica, la paradoja E.P.R. y las controversias Einsten-Bohr:

Pais, A. "El Señor es Sutil". La ciencia y la vida de Albert Einstein, Ariel, 1984.

Bibliografía interesante se encuentra en :

Kleppner, D. y Jackiw, R., One Hundred Years of Quantum Physics, Science, 289 (2000)893-898.

Roessler, Jaime. Sobre el significado de la mecánica cuántica, Sociedad Chilena de Física, Publicaciones Científicas, 181.

Datos biográficos y desarrollos científicos con bastante extensión en :

Frabke, H., Diccionario de Física, Editorial Labor 1967.

Biografías y comentarios sumamente acertados en:

Gribbin, J., Q is for Quantum, The Free Press, 1999.

Elemental pero acertado.

Gribbin, J., The Search for Superstrings, Symmetry, and the Theory of Everithing, Little, Brown and Company, 1999.

El aspecto filosófico en:

Popper, K.R:, La lógica de la Investigación Científica, Tecnos, 19662.

Una visión de lo que se hizo en Latinoamérica a principios del siglo XX en:

Gans, R. y Pereyra Mingez., Refrengibilidad de luz de poca intensidad, Contribución al Estudio de la Ciencias Físicas y Matemáticas, La Plata, 1916.

© 1999 Ernesto Valle y Javier de Lucas