EL VASTO TAPIZ

Los últimos años de la década de 1990 fueron la culminación de un periodo dorado de descubrimientos en cosmología. Considerada hasta entonces una disciplina de especulación desenfrenada, la cosmología —la ciencia que se atreve con el estudio del origen, la evolución y el destino del universo como un todo— alcanzaba por fin la madurez. Científicos de todo el mundo asistían emocionados a las espectaculares observaciones obtenidas por sofisticados instrumentos, desde satélites o desde la Tierra, que transformaban nuestra imagen del universo hasta hacerla irreconocible. Parecía que el universo nos hablaba. Estos avances ponían a prueba a los teóricos, a quienes se pedía que refrenaran sus especulaciones y extrajeran predicciones de sus modelos.

Con la cosmología descubrimos el pasado. Los cosmólogos son viajeros en el tiempo, y los telescopios, las máquinas que les permiten viajar por él. Cuando miramos el espacio profundo, en realidad miramos hacia atrás en el tiempo profundo, pues la luz de las estrellas y galaxias lejanas ha viajado millones o incluso miles de millones de años antes de alcanzarnos. Ya en 1927 el sacerdote y astrónomo belga Georges Lemaître predijo que el espacio, considerado a tan largos periodos de tiempo, se expande. Pero no fue hasta la década de 1990 cuando los avances en la tecnología de los telescopios nos permitieron medir la historia de la expansión del universo.

Esa historia escondía algunas sorpresas. Por ejemplo, en 1998 los astrónomos descubrieron que la expansión del espacio comenzó a acelerarse hace unos cinco mil millones de años pese a que todas las formas conocidas de materia se atraen y, por tanto, deberían frenar la expansión. Desde entonces, los físicos se preguntan si esa extraña aceleración cósmica viene determinada por la constante cosmológica de Einstein, una energía oscura, etérea e invisible que hace que la gravedad repela en lugar de atraer. Un astrónomo bromeó con que el universo se parece a Los Ángeles: un tercio de sustancia y dos de energía.

Como es obvio, si el universo se está expandiendo es que debió estar más comprimido en el pasado. Si presenciásemos la historia del universo hacia atrás (como un ejercicio matemático, naturalmente), encontraríamos que toda la materia tuvo que estar algún día densamente empaquetada y muy caliente, puesto que la materia se calienta e irradia cuando se comprime. Este estado primigenio se conoce como «big bang caliente». Desde la década dorada de 1990, las observaciones astronómicas nos han permitido establecer la edad del universo —el tiempo transcurrido desde el big bang— en 13800 millones de años, 20 millones arriba o abajo.

Ansiosa por saber más sobre el nacimiento del universo, la Agencia Espacial Europea (ESA) lanzó un satélite en mayo de 2009 con la intención de realizar la más ambiciosa y detallada exploración del firmamento nocturno jamás acometida. El objetivo era un enigmático patrón de parpadeos en la radiación térmica que había dejado el big bang. Tras viajar por el cosmos en expansión durante 13800 millones de años, el calor del nacimiento del universo que hoy nos alcanza ya está frío: 2,275 K, unos −270 grados centígrados. A esta temperatura, la radiación se encuentra en la banda de microondas del espectro electromagnético, por lo que el calor residual se conoce como «radiación cósmica de fondo de microondas», o CMB (por sus siglas en inglés).

Los esfuerzos de la ESA por captar el antiguo calor culminaron en 2013, cuando una curiosa imagen moteada que recuerda un cuadro puntillista decoró las primeras planas de los periódicos de todo el mundo. Es la imagen que aparece reproducida en la figura , que muestra una proyección de todo el firmamento compilada con exquisito detalle a partir de millones de píxeles que representan la temperatura de la radiación CMB residual en distintas direcciones del espacio.

Mapa del resplandor del big bang caliente en todo el firmamento obtenido por la Agencia Espacial Europea mediante el satélite Planck, así bautizado en honor al pionero de la física cuántica Max Planck. Las motas de distintos tonos de gris representan ligeras variaciones de la temperatura de la antigua radiación cósmica de fondo de microondas que nos llega desde distintas direcciones del espacio.

A primera vista, estas fluctuaciones parecen aleatorias, pero un estudio más detallado ha revelado que son patrones que conectan distintas regiones en el mapa. Estudiándolas, los cosmólogos pueden reconstruir la historia de la expansión del universo y modelar la formación de las galaxias e incluso predecir su futuro. Estas detalladas observaciones de la radiación de fondo de microondas nos ofrecen una instantánea del aspecto que ofrecía el universo apenas 380000 años después del big bang, cuando se había enfriado hasta unos pocos miles de grados, lo bastante como para liberar la radiación primigenia, que desde entonces ha viajado sin obstáculos por el cosmos.

El mapa de la radiación de fondo de microondas confirma que el calor residual del big bang se encuentra distribuido por todo el espacio de manera casi uniforme, pero no completamente. Las motas de la imagen representan variaciones minúsculas de temperatura, diminutas fluctuaciones de no más de una centésima de milésima de grado. Pero, por minúsculas que sean, estas variaciones revisten una enorme importancia, pues indican las semillas en torno a las cuales se acabarían formando las galaxias. Si el big bang hubiera sido uniforme en todo el espacio, hoy no habría galaxias.

La instantánea de la antigua radiación CMB marca nuestro horizonte cosmológico: no es posible mirar más atrás. Pero podemos averiguar algo sobre los procesos que tuvieron lugar en épocas más tempranas con la ayuda de la teoría cosmológica. Del mismo modo que los paleontólogos averiguan a partir de fósiles pétreos cómo fue la vida en la Tierra, los cosmólogos pueden descifrar los patrones que se hallan codificados en estos parpadeos fósiles para hacerse una idea de lo que podría haber sucedido antes de que el mapa del calor residual quedase impreso en el firmamento. Eso convierte el CMB en una piedra de Rosetta cosmológica que nos permite rastrear la historia del universo aún más atrás, tal vez hasta tan solo una fracción de segundo después de su nacimiento.

Y lo que descubrimos es muy interesante. Las variaciones de temperatura de la radiación CMB indican que el universo al principio se expandió deprisa, luego se desaceleró y más recientemente (hace unos cinco mil millones de años) comenzó a acelerarse de nuevo. Frenarse parece ser más la excepción que la regla a las escalas de tiempo profundo y espacio profundo. Es una de esas propiedades del universo en apariencia fortuitas que lo hacen acogedor para la vida, pues solo en un universo que se desacelera puede agregarse la materia para formar galaxias. De no haber sido por la extensa cuasipausa de la expansión en nuestro pasado, hoy, como decíamos, no habría ni galaxias, ni estrellas, ni, por tanto, vida.

De hecho, la historia de la expansión del universo se encuentra en el centro mismo de uno de los primeros momentos en que las condiciones para nuestra existencia se colaron en el pensamiento cosmológico moderno. Ese momento se produjo a principios de la década de 1930, cuando Lemaître hizo una notable anotación en uno de sus cuadernos púrpura acerca de lo que calificaba de universo «vacilante», con una historia de expansión parecida a la que surgiría de observaciones realizadas setenta años más tarde. Lemaître llegó a abrazar la idea de una larga pausa en la expansión tras considerar la habitabilidad del universo. Sabía que las observaciones astronómicas de galaxias cercanas apuntaban a una elevada tasa de expansión en tiempos recientes. Pero, cuando rastreó la evolución del universo hacia atrás en el tiempo con esa misma tasa, vio que las galaxias habrían estado todas mezcladas hace no más de mil millones de años. Eso, por supuesto, era imposible, pues la Tierra y el Sol son mucho más viejos. Para evitar un obvio conflicto entre la historia del universo y la de nuestro sistema solar, concibió una era intermedia de expansión muy lenta, con el fin de dar tiempo para que se desarrollasen las estrellas, los planetas y la vida.

En las décadas que han trascurrido desde los trabajos pioneros de Lemaître, los físicos no han dejado de tropezarse con muchas más de esas «felices coincidencias». Cualquier cambio que no sea nimio en casi cualquiera de sus propiedades físicas básicas, desde el comportamiento de los átomos y las moléculas hasta la estructura del cosmos a las más grandes escalas, pondría contra las cuerdas la habitabilidad del universo.

Veamos si no qué pasa con la gravedad, la fuerza que esculpe y gobierna el universo a gran escala. La gravedad es muy débil; necesita la masa de la Tierra solo para mantenernos con los pies en el suelo. Pero, si fuera más fuerte, las estrellas brillarían con mayor intensidad y, por consiguiente, morirían antes, sin dar tiempo para la evolución de vida compleja en ninguno de los planetas en órbita que recibieran su calor.O pensemos en las pequeñas variaciones, de una parte por cien mil, en la temperatura de la radiación residual del big bang. Si esas variaciones fuesen algo mayores, por ejemplo, en una parte por diez mil, las semillas de las estructuras cósmicas habrían crecido hasta convertirse en agujeros negros gigantes en lugar de acogedoras galaxias llenas de estrellas. Y al contrario: variaciones aún más pequeñas, de una millonésima o menos, ni siquiera producirían galaxias. El big bang caliente tenía las características justas. De algún modo, hizo que el universo siguiera una trayectoria muy acogedora para la vida, aunque sus frutos no se hiciesen palpables hasta varios miles de millones de años después. ¿Por qué?

Abundan los ejemplos de coincidencias cósmicas como estas. Habitamos un universo con tres dimensiones grandes de espacio. ¿Tiene ese tres algo de especial? Pues sí. Basta con añadir una sola dimensión más para que las órbitas de átomos y planetas se tornen inestables. La Tierra se abalanzaría en espiral contra el Sol en lugar de trazar una órbita estable en torno a él. Los universos de cinco o más dimensiones espaciales grandes tienen problemas aún mayores. Por otro lado, los mundos de dos dimensiones espaciales quizá no ofrecieran espacio suficiente para que en él funcionasen los sistemas complejos. Tres dimensiones de espacio parecen ser las justas para la vida.

Además, esta extraña idoneidad para la vida se extiende a las propiedades químicas del universo, que vienen determinadas por las propiedades de las partículas elementales y de las fuerzas que actúan entre ellas. Por ejemplo, los neutrones son un poquito más pesados que los protones. La razón de masas entre neutrones y protones es 1,0014. Si hubiera sido al revés, todos los protones del universo se habrían desintegrado en neutrones poco después del big bang. Pero sin protones no habría núcleos atómicos ni, por tanto, átomos ni química.

Otro ejemplo de lo mismo es la producción de carbono en las estrellas. Por lo que sabemos, el carbono es esencial para la vida. Pero no nació con el universo, sino que se formó en la fusión nuclear que tiene lugar en el interior de las estrellas. En la década de 1950, el cosmólogo británico Fred Hoyle señaló que la síntesis eficiente de carbono a partir de helio en las estrellas depende de un delicado equilibrio entre la fuerza nuclear fuerte, que mantiene unidos los núcleos de los átomos, y la fuerza electromagnética. Si la fuerza fuerte fuese una fracción más fuerte o más débil que ahora (apenas unos pocos puntos porcentuales), las energías que unen los núcleos se desplazarían, comprometiendo la fusión de carbono y, por consiguiente, la formación de la vida basada en el carbono. A Hoyle eso le pareció tan extraño que dijo que el universo le parecía un «montaje», como si «un superintelecto hubiera manipulado la física, pero también la química y la biología».

Pero el más desconcertante de los ajustes finos propicios para la vida guarda relación con la energía oscura. El valor de la densidad de energía oscura que hemos medido es muy bajo, unas sorprendentes 10−123 veces más bajo de lo que muchos físicos considerarían un valor natural. Sin embargo, esa pequeñez es justo lo que hizo que el universo «dudase» durante unos ocho mil millones de años antes de que la energía oscura consiguiese hacer acopio de la fuerza suficiente para acelerar la expansión. Ya en 1987, Steven Weinberg señaló que, si la densidad de la energía oscura fuese tan solo un poco más alta, digamos 10−121 veces su valor natural, entonces su efecto repulsor habría sido mayor y habría entrado en juego antes, cerrando, una vez más, la ventana de oportunidad cósmica para la formación de galaxias. En definitiva, parece como si el universo hubiese estado de algún modo diseñado para hacer posible la vida.

En este contexto el celebrado escritor y físico teórico Paul Davies habló del factor «Ricitos de Oro» en el universo: «Como las gachas del cuento de Ricitos de Oro y los tres ositos, el universo parece ser “justo” lo que necesita la vida, y de muchas y curiosas maneras»6. Y, aunque eso no signifique que el cosmos tenga que estar repleto de vida, los sensatos ajustes que lo hacen habitable no son de ningún modo cualidades superficiales del mundo, sino que están inscritos de manera muy profunda en la forma matemática de las leyes de la física. Las masas y propiedades de la variedad de partículas, las fuerzas que rigen sus interacciones, incluso la composición global del universo —todo lo cual parece hecho adrede para sustentar la vida— reflejan el carácter específico de las relaciones matemáticas que definen lo que los físicos llaman leyes de la naturaleza. Así que el enigma del diseño en la cosmología es que las leyes fundamentales de la física parecen estar pensadas ex profeso para facilitar que surja la vida. Es como si hubiera una conspiración oculta para entretejer nuestra existencia con las leyes básicas sobre las que funciona el universo. Parece increíble, ¡y lo es!

¿Qué conspiración es esa?

Debo recalcar que este es un enigma del todo insólito para los físicos teóricos. Estos, por lo general, utilizan las leyes de la naturaleza para describir tal o cual fenómeno o predecir el resultado de un experimento. También intentan generalizar las leyes existentes con el fin de que se apliquen a una variedad mayor de fenómenos naturales. Pero estas preguntas sobre el diseño nos llevan por un camino bastante distinto. Nos fuerzan a reflexionar sobre la naturaleza profunda de las leyes y sobre cómo encajamos en su esquema. Lo emocionante de la cosmología moderna es que nos ofrece un marco científico en el que podemos albergar la esperanza de dilucidar este misterio de misterios. Y es que la cosmología es el campo de la física en el que nosotros mismos somos parte inherente del problema que intentamos resolver.

Históricamente, el aparente diseño del mundo se ha tomado como prueba de que un propósito subyace al funcionamiento de la naturaleza. Este parecer se remonta a Aristóteles, tal vez el filósofo más influyente de todos los tiempos. Apasionado también por la historia natural, Aristóteles observó que muchos de los procesos que se dan en el mundo vivo parecen tener intención. Pensó entonces que, si los seres vivos que carecen de raciocinio tienen un objeto, debe existir una causa final que dirige el cosmos como un todo. El argumento teleológico de Aristóteles era persuasivo, lógico, reconfortante y, hasta cierto punto, tenía base empírica, pues el mundo que nos rodea está colmado de ejemplos del funcionamiento de causas finales, desde el ave que recoge ramillas para hacer un nido hasta el perro que escarba en el jardín para desenterrar un hueso.

No debe sorprender, entonces, que las tesis teleológicas de Aristóteles persistieran, sin apenas desafío, durante casi dos milenios.Pero entonces, en el siglo XVI, en un extremo del continente euroasiático, el trabajo de un pequeño círculo de pensadores prendió la mecha de la revolución científica moderna. Copérnico, Descartes, Bacon, Galileo y sus coetáneos se fijaron en que nuestros sentidos pueden traicionarnos. Hicieron suyo el adagio latino Ignoramus, literalmente, «No sabemos». Este cambio de perspectiva ha tenido repercusiones de enorme alcance. Hay incluso quien lo tiene por la más influyente de todas las transformaciones que se han producido en los doscientos mil años que hace que los humanos habitamos este planeta. Además, su plena significación todavía está por desplegarse del todo. El resultado inmediato de la revolución científica, al menos en círculos académicos, fue acabar con la tan arraigada cosmovisión aristotélica para sustituirla por la idea de que la naturaleza está regida por leyes naturales que actúan aquí y ahora, y que podemos descubrir y comprender. De hecho, la esencia misma de la ciencia moderna es que, una vez admitida la ignorancia, podemos adquirir nuevo conocimiento experimentando y observando, y desarrollando modelos matemáticos que organizan estas observaciones en teorías generales o «leyes».

Paradójicamente, sin embargo, la revolución científica hizo aún más profundo el enigma de la biofilia de nuestro universo. Antes de la revolución científica, una suerte de unidad subyacía a la concepción que el hombre tenía del mundo: se creía que tanto lo animado como lo inanimado estaban guiados por un propósito global, divino o no. El diseño del mundo se veía como una manifestación de un gran plan cósmico que, como es lógico, asignaba al hombre un papel privilegiado. El antiguo modelo del mundo que propugnaba el astrónomo alejandrino Ptolomeo en su libro Almagesto, por ejemplo, era tan geocéntrico como antropocéntrico.

Pero, con la llegada de la revolución científica, la naturaleza fundamental de la relación de la vida con el universo físico se llenó de confusión. Casi cinco siglos después, nuestro desconcierto con el hecho de que las en teoría objetivas, impersonales y atemporales leyes de la física estén ajustadas de manera casi perfecta para permitir la vida es una manifestación clara de esa confusión. Así, aunque la ciencia moderna consiguió abolir la antigua dicotomía entre el cielo y la Tierra, abrió una nueva y fenomenal brecha entre el mundo vivo y el inanimado, dejando la percepción que teníamos de nuestro lugar en el gran esquema del cosmos en perpetua incertidumbre.

De hecho, quizá podamos comprender mejor de qué modo se ha configurado la visión que tiene el hombre de la ontología de las leyes de la naturaleza si volvemos a fijarnos en las raíces profundas de la idea de que hay leyes. Los primeros indicios de que hubiera leyes que gobiernan la naturaleza aparecieron en el siglo VI a.C. en Mileto, en la escuela jónica de Tales, en lo que hoy es la región más occidental de Turquía. Mileto, la más rica de las ciudades griegas jónicas, se fundó en un puerto natural cerca de donde el río Meandro desemboca en el mar Egeo. Allí el legendario Tales, como luego los modernos científicos, estaba dispuesto a mirar bajo la superficie de las apariencias del mundo en busca de un conocimiento más profundo.

Tales tuvo un pupilo, Anaximandro, que creó lo que los griegos dieron en llamar περι φυσεως ιστοϑια, o «investigación acerca de la naturaleza», o sea, física. A Anaximandro también se lo considera el padre de la cosmología por ser el primero en ver la Tierra como un planeta, una gigantesca roca que flota con libertad en el espacio vacío. Razonaba que más allá de la Tierra no había tierra sin límite ni columnas gigantes, sino el mismo cielo que vemos sobre nuestra cabeza. De este modo, dio profundidad al cosmos, transformándolo de caja cerrada —con el cielo encima y la Tierra debajo— en espacio abierto. Este cambio conceptual permitía imaginar cuerpos celestes más allá de la Tierra y abría así el paso a la astronomía griega. Además, Anaximandro escribió un tratado titulado Sobre la naturaleza que, aunque perdido, se cree que contenía el siguiente fragmento:

Con permiso del Ministerio de Cultura-Museo Nazionale Romano, Terme di Diocleziano, foto n.º 573 616: Servizio Fotografico SAR. Este fragmento nos ha llegado a través de Simplicio de Cilicia, que lo cita en su comentario de la Física de Aristóteles. Relieve del antiguo filósofo griego Anaximandro de Mileto. Hace veintiséis siglos, Anaximandro puso las primeras piedras del largo y sinuoso camino de la ciencia para repensar el mundo.

Las cosas perecen en aquellas de las que han recibido su ser, como es debido; pues mutuamente se dan justa retribución por su injusticia según el ordenamiento del tiempo.

En estas pocas líneas, Anaximandro articula la idea revolucionaria de que la naturaleza no es ni arbitraria ni absurda, sino que está gobernada por algún tipo de ley. Esta es la suposición fundacional de la ciencia: bajo la superficie de los fenómenos naturales hay un orden abstracto pero coherente. Anaximandro no especificó qué forma podían tomar las leyes de la naturaleza más allá de establecer una analogía con las leyes civiles que regulan las sociedades humanas. Pero su más célebre pupilo, Pitágoras, propuso que el orden del mundo debía tener una base matemática. Los pitagóricos daban a los números un significado místico e intentaban construir el cosmos entero a partir de ellos.

Platón adoptó y defendió su idea de que el mundo podía describirse en términos matemáticos y la convirtió en uno de los pilares de su teoría de la verdad. Decía que el mundo de nuestra experiencia se asemejaba a las sombras de una realidad muy superior de formas matemáticas perfectas que existía separada de la que nosotros percibimos. Los antiguos griegos llegarían a pensar que, aunque no podamos llegar a tocar o ver el orden que subyace al mundo, podemos deducirlo por medio de la lógica y la razón.

Sin embargo, por impresionantes que sean sus teorías, las especulaciones de los antiguos acerca de la naturaleza tienen poco en común con la física moderna, ya sea en sustancia, en método o en estilo. Para empezar, los griegos antiguos razonaban casi por completo sobre una base estética y a partir de suposiciones previas, con poco o nulo esfuerzo por ponerlas a prueba. Sencillamente, no se les pasaba por la cabeza. En consecuencia, su concepción de la física y de una realidad regida por leyes no se asemejaba en nada a la moderna teoría científica. En su último libro, "Explicar el mundo", Steven Weinberg argumentaba que, desde un punto de vista contemporáneo, debemos ver a los antiguos griegos no como físicos o científicos o siquiera filósofos, sino como poetas, puesto que su metodología difería de manera fundamental de la práctica académica actual. Por supuesto, los físicos modernos también ven la belleza de sus teorías, pero esas consideraciones no constituyen una alternativa a la verificación de las teorías mediante experimentos y observaciones, que son, al fin y al cabo, las innovaciones cruciales de la revolución científica.

No obstante, la visión de Platón de hacer matemático el mundo resultaría tener una enorme influencia. Cuando varios siglos más tarde se inició la revolución científica moderna, sus protagonistas se vieron motivados por su fe en el programa platónico de buscar un orden oculto que subyaciera al mundo físico y se expresara en forma de relaciones matemáticas. «El gran libro de la naturaleza —escribió Galileo— pueden leerlo solo aquellos que conocen el lenguaje en el que fue escrito. Y ese lenguaje es la matemática».

Isaac Newton, alquimista, místico y persona de carácter difícil, pero que se cuenta entre los mayores matemáticos de todos los tiempos, consolidó el enfoque matemático a la filosofía natural en sus Principia, que algunos consideran la obra más importante de la historia de la ciencia. Newton le dio un buen empujón a esta durante un confinamiento decretado a raíz de la peste de 1665, que obligó a la Universidad de Cambridge a cerrar sus puertas. Bachiller reciente, Newton regresó a la casa materna y su huerto de manzanos en Lincolnshire. Allí reflexionó sobre el análisis matemático, sobre la gravedad y el movimiento, y descompuso la luz con un prisma, demostrando así que la luz blanca está constituida por los colores del arcoíris. Pero no fue hasta mucho más tarde, en abril de 1686, cuando Newton presentó a la Royal Society para su publicación sus Philosophiae Naturalis Principia Mathematica, que contenían ya tres leyes del movimiento y la ley de la gravitación universal. Esta última, quizá la más célebre de todas las leyes de la naturaleza, postula que la fuerza de la gravedad entre dos cuerpos es directamente proporcional a su masa e inversamente proporcional al cuadrado de la distancia que los separa.

La demostración de Newton en los Principia de que los mismos principios universales subyacen al funcionamiento de los cielos divinos y del imperfecto mundo que nos rodea marcó una ruptura conceptual y espiritual con el pasado. Se dice a veces que Newton unificó cielo y tierra. Su síntesis de los movimientos planetarios en un puñado de ecuaciones matemáticas transformó todas las ilustraciones previas del sistema solar y señaló la transición de la era de la magia a lo que habría de convertirse en la física moderna. El modo de hacer de Newton se convirtió en el paradigma general de toda la física que le siguió. A diferencia de la «física» de los antiguos griegos, que apenas podemos reconocer como tal, la física contemporánea está como en su propia casa en la física newtoniana.

Uno de los éxitos más famosos de las leyes de Newton fue el descubrimiento del planeta Neptuno en 1846. Algunos astrónomos ya se habían percatado de que la trayectoria de Urano se desviaba un poco de la órbita que predecía la ley de la gravedad de Newton. En busca de una explicación de esta obstinada discrepancia, el francés Urbain Le Verrier tuvo el coraje de sugerir que era debida a un planeta desconocido y aún más lejano, cuya atracción gravitatoria debía influir un poco en la trayectoria de Urano. Con la ayuda de las leyes de Newton, Le Verrier consiguió predecir dónde se hallaría en el firmamento este planeta desconocido para explicar las desviaciones de la órbita de Urano, suponiendo, claro está, que las leyes de Newton fuesen correctas. Y, en efecto, los astrónomos no tardaron en descubrir Neptuno a menos de un grado de donde Le Verrier les había indicado. Este se convirtió en uno de los momentos más señalados de la ciencia del siglo XIX. Se dijo entonces que Le Verrier había descubierto un nuevo planeta «con la punta de su pluma»

Éxitos abrumadores como estos a lo largo de varios siglos parecían confirmar las leyes de Newton como verdades universales definitivas. Ya en el siglo XVIII el matemático francés Joseph-Louis Lagrange señaló que Newton había tenido la suerte de vivir en aquel tiempo único en la historia de la humanidad en el que era posible descubrir las leyes de la naturaleza. Al parecer, el propio Newton no hizo mucho por evitar el nacimiento de este mito. Inmerso en una tradición de misticismo, veía la elegante forma matemática de sus leyes como una manifestación de la mente de Dios.

Es a esta formulación matemática de las leyes de la naturaleza a lo que se refieren los físicos actuales cuando usan la palabra «teoría». Las teorías físicas deben su utilidad y poder predictivo al hecho de que logran describir el mundo real mediante ecuaciones matemáticas abstractas que se pueden manipular para predecir lo que ocurrirá sin necesidad de hacer observaciones o realizar experimentos. ¡Y funciona! Desde el descubrimiento de Neptuno hasta el registro de ondas gravitacionales o la predicción de nuevas partículas o antipartículas fruto de colisiones en aceleradores de partículas, una y otra vez los fundamentos matemáticos de las leyes de la física nos han conducido a fenómenos nuevos y sorprendentes que más tarde se observaron. Muy impresionado por este poder de predicción, el premio Nobel Paul Dirac promovió, en célebres declaraciones, la exploración de la matemática bella e interesante como la mejor manera de practicar la física. La matemática «nos lleva de la mano —sentenció— a descubrir nuevas teorías físicas». La mayoría de los actuales teóricos de cuerdas han adoptado la máxima de Dirac en su búsqueda de una teoría final unificada, lo que a veces los ha llevado a sucumbir a la tentación de los antiguos de tomar la belleza matemática de su marco teórico como garantía de su veracidad. Más de un pionero de la teoría de cuerdas ha expresado con tonos líricos que la teoría era una estructura demasiado bella como para ser irrelevante para la naturaleza.

A un nivel más profundo, sin embargo, todavía no acabamos de comprender por qué la física teórica funciona tan irrazonablemente bien. ¿Por qué se ajusta la naturaleza a un sistema de sutiles relaciones matemáticas que actúan bajo su superficie? ¿Qué significado tienen en realidad esas leyes? ¿Y por qué adoptan la forma que adoptan?

La mayoría de los físicos todavía siguen a Platón en este punto. Tienden a concebir las leyes de la física como verdades matemáticas eternas, que no viven solo en nuestra mente, sino que actúan en una realidad abstracta que trasciende el mundo físico. Las leyes de la gravedad o la mecánica cuántica, por ejemplo, suelen verse como aproximaciones de una teoría final que debe existir en algún sitio, en algún dominio que todavía no hemos descubierto. Así que, aunque las leyes físicas surgieron en la era científica moderna sobre todo como herramientas para describir los patrones que encontramos en la naturaleza, desde que Newton identificó sus raíces matemáticas han cobrado vida propia y han adquirido una suerte de realidad que reemplaza al mundo físico. Para el polímata francés de principios del siglo XX Henri Poincaré, la idea de leyes platónicas incondicionales era una presuposición indispensable para la ciencia.

Aunque la proposición de Poincaré no carece de interés e importancia, también resulta desconcertante. ¿En concreto de qué modo esas leyes «socialmente lejanas», allí en su reino platónico, se coligan para gobernar un universo físico, cuanto más uno que es tan acogedor para la vida? El descubrimiento del big bang es crucial por cuanto significa que no estamos tratando «solo» de una cuestión filosófica. De hecho, si el big bang es en realidad el origen del tiempo, será mejor que Poincaré lleve razón, pues, si las leyes físicas determinan cómo comenzó el universo, cabe imaginar que debieron tener alguna forma de existencia más allá del tiempo. Lo interesante, pues, es que la teoría del big bang arrastra lo que podrían haber parecido meras consideraciones metafísicas hasta el dominio propio de la física y la cosmología. La teoría nos enfrenta con algunas de nuestras presuposiciones acerca de la verdadera naturaleza de las leyes físicas.

En definitiva, la idea de que las leyes de la física de algún modo trascienden el mundo natural se arriesga a dejar el origen de su extraordinaria biofilia en un puro misterio. Los físicos que se aferran a esta concepción no pueden más que albergar la esperanza de que un poderoso principio matemático en el núcleo mismo de la teoría final nos explique algún día su carácter biofílico. Hoy por hoy, la respuesta de los físicos platónicos ante el enigma del diseño es que acabará resultando ser una cuestión de necesidad matemática: el universo es como es porque la naturaleza no tiene elección. En la medida en que eso sea una respuesta, tiene un regusto a causa final aristotélica, solo que disfrazada de física teórica moderna. Además, dejando a un lado el hecho de que una teoría final de este tipo sigue siendo un sueño lejano, aun en el caso de que algún día se encontrase un principio matemático tan potente, apenas nos ayudaría a dilucidar por qué el universo resulta ser tan acogedor para la vida. Ninguna verdad platónica, del tipo que sea, podría salvar la brecha entre el mundo vivo y el inanimado que se abrió con el nacimiento de la ciencia moderna. Al contrario, tendríamos que concluir que la vida y la inteligencia no son más que felices coincidencias en una realidad matemática impersonal e ideal, y poco más habría que comprender.

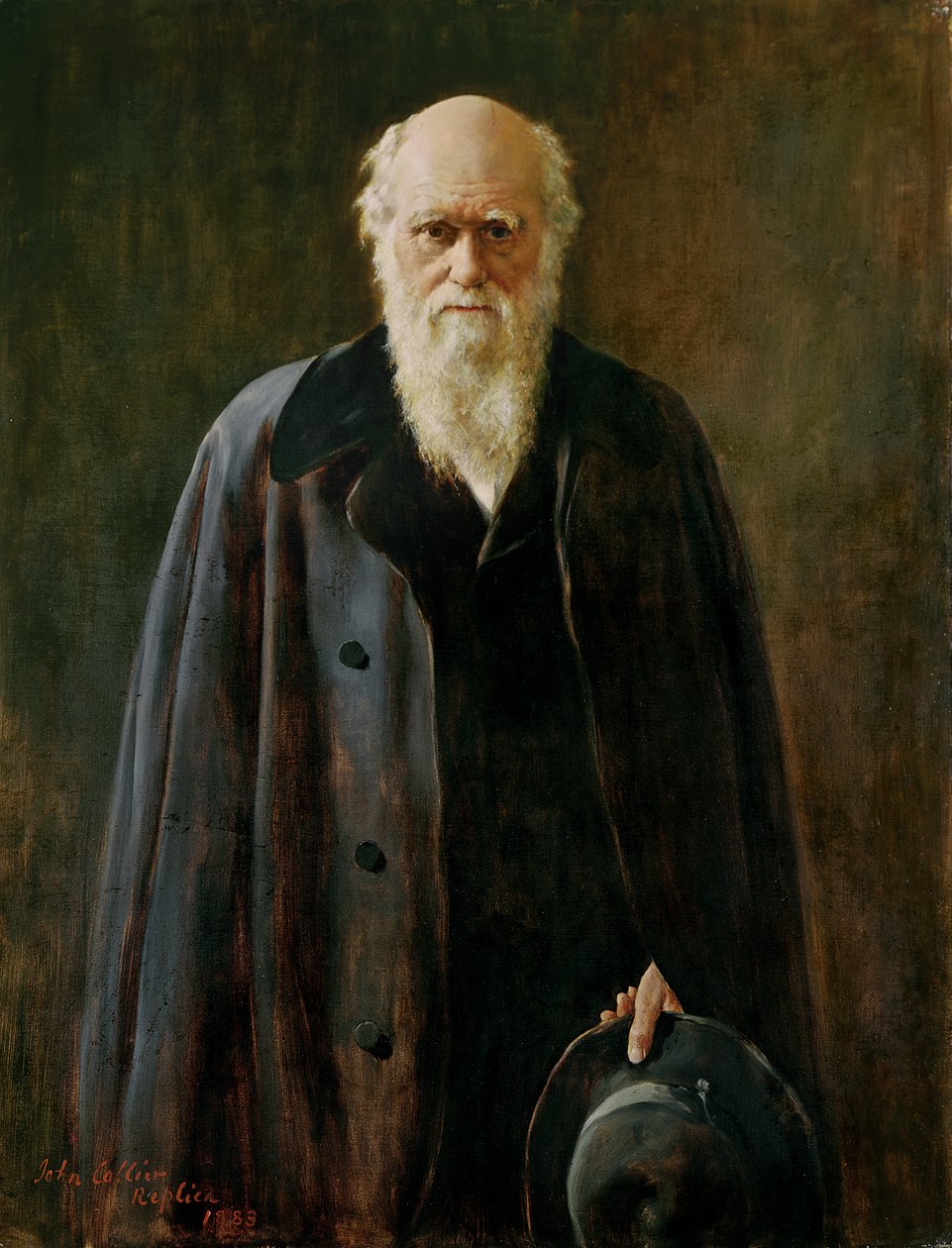

Estas inclinaciones platónicas en cuestiones de diseño en la física y la cosmología, aunque no obviamente erróneas, difieren por completo de cómo ven los biólogos desde Darwin el diseño en el mundo vivo. Los procesos dirigidos a un fin y los diseños en apariencia intencionados son ubicuos en el mundo biológico. De hecho, son estos los que se encuentran en la base de las tesis teleológicas de Aristóteles. Los organismos vivos son de una enorme complejidad. Incluso una sola célula viva contiene una gran variedad de componentes moleculares que cooperan a la perfección para ejecutar sus numerosas tareas. En organismos de mayor tamaño, un gran número de células trabajan de manera coordinada para construir estructuras sofisticadas y con fines definidos, como el ojo o el cerebro.

Charles Darwin

Antes de Charles Darwin, no se comprendía de qué modo los procesos físicos y químicos podían haber creado una complejidad funcional tan sorprendente, de manera que se apelaba a un Diseñador para explicarla. El clérigo inglés del siglo XIX William Paley comparó los prodigios del mundo físico con el funcionamiento de un reloj. Igual que en este, argumentaba Paley, las señales del diseño del mundo biológico son demasiado fuertes como para ignorarlas, y «un diseño debe tener un Diseñador». Pero la teoría de la evolución de Darwin acabó con ese paradigma extirpando con decisión el pensamiento teleológico de la biología. La profunda idea de Darwin fue que la evolución biológica es un proceso natural y que unos mecanismos simples (variaciones al azar y selección natural) pueden explicar el aparente diseño de los organismos vivos sin la necesidad de apelar a un Diseñador.

En las islas Galápagos, Darwin encontró una variedad de pinzones que diferían en la forma y tamaño del pico. Los pinzones terrestres tenían un pico fuerte, eficaz para cascar nueces y semillas, mientras que los pinzones arbóreos tenían pico fino y puntiagudo, bien adaptado para extraer insectos. Estos datos y otros recabados durante su viaje llevaron a Darwin a pensar que las distintas variedades de pinzones estaban relacionadas y habían evolucionado con el tiempo bajo la influencia de sus particulares nichos ecológicos. En 1837, recién llegado de su viaje a las Galápagos en el HMS Beagle, Darwin bosquejó en uno de sus cuadernos rojos un sencillo esquema de un árbol de ramas irregulares. Este bosquejo de un árbol ancestral capturaba la grandeza de su profunda y floreciente teoría de que todos los seres vivos de la Tierra están emparentados y descienden de un único antepasado común, el tronco del árbol, por medio de un proceso gradual y progresivo de selección natural que actuaba sobre replicantes que mutaban al azar . La idea central del darwinismo es que la naturaleza no mira hacia delante, no anticipa lo que podría necesitar para sobrevivir.

Cualquier tendencia, como la forma cambiante del pico o el crecimiento progresivo del cuello de una jirafa, responde a presiones selectivas del ambiente que, al actuar durante largos periodos de tiempo, refuerzan los rasgos útiles. «Hay grandeza en esta visión de que la vida —escribiría Darwin más de veinte años más tarde—, con sus diferentes fuerzas, ha sido alentada al principio en un corto número de formas o en una sola, y que, mientras este planeta ha ido girando según la constante ley de la gravitación, se han desarrollado y se están desarrollando, a partir de un principio tan sencillo, infinidad de las formas más bellas y portentosas».

El darwinismo le dio la vuelta al argumento de Paley al demostrar que el reloj no necesita un relojero suizo. Proporcionó una descripción por completo evolutiva del mundo vivo en la que su diseño aparente, incluidas las leyes que obedece, se entiende como propiedades emergentes de procesos naturales, no como resultado de un acto sobrenatural de creación. Pese a su belleza y grandeza, las leyes biológicas suelen verse como algo menos fundamentales que las de la física. Y es que, aunque los patrones que emergen con carácter de ley pueden ser persistentes, nadie piensa en ellos como verdades eternas. Además, el determinismo y la predictibilidad han desempeñado un papel mucho menor como principios en la biología. Las leyes del movimiento de Newton son deterministas; permiten a los físicos predecir dónde estarán unos objetos en el futuro a partir de su posición y velocidad en el momento presente (o en cualquier otro momento del pasado).

En el esquema conceptual de Darwin, el azar de las mutaciones de los sistemas vivos implica que casi nada se puede determinar por adelantado, ni siquiera las leyes que algún día podrían emerger. Esta falta de determinismo imbuye en la biología un elemento retrospectivo: solo podemos entender la evolución biológica estudiando su pasado. La teoría de Darwin no nos proporciona los detalles de la trayectoria evolutiva que en realidad se ha producido, desde la vida primigenia hasta la diversa y compleja biosfera de nuestros días. No predice el árbol de la vida, pues ese ni ha sido ni puede ser su propósito. Lo que el genio de Darwin sí consiguió fue esbozar unos principios generales de organización, dejando para la filogenia y la paleontología los registros históricos específicos. Es decir, la teoría de la evolución de Darwin reconoce que la vida tal como la conocemos es el producto conjunto de unas regularidades afines a leyes y de una historia particular. Su utilidad reside en el hecho de que permite a los científicos construir de forma retrospectiva el árbol de la vida, comenzando por nuestras observaciones de la biosfera actual y la hipótesis de un antepasado común.

Los pinzones de Darwin vienen al caso. Si Darwin hubiera razonado hacia delante en el tiempo e intentado predecir las distintas especies de pinzones de las islas Galápagos a partir de las condiciones ambientales de la Tierra prebiótica, habría fracasado por completo. La existencia de pinzones, o de cualquier otra especie de las que se mueven por nuestro planeta, no se puede deducir solo de las leyes de la física y la química, porque toda bifurcación durante la evolución biológica implica un juego de azar. Algunos de los resultados de ese juego se ven favorecidos por las circunstancias ambientales y quedan congelados, a menudo con drásticas consecuencias para el futuro. Esos accidentes congelados contribuyen a determinar el carácter de la evolución subsiguiente y pueden incluso tomar la forma de leyes biológicas. El nacimiento de las leyes de la herencia mendelianas, por ejemplo, descansa sobre el resultado de bifurcaciones colectivas que condujeron a la aparición de los organismos con reproducción sexual.

En la figura presento una versión moderna del árbol filogenético de la vida basado en los análisis de secuencias de ARN ribosómico que muestra tres dominios —bacterias, arqueas y eucariotas— y su antepasado común en la base del árbol. Todo en este árbol, desde su base molecular hasta las ramas de las especies de pinzones, resume y contiene la compleja y retorcida historia de miles de millones de años de «experimentación» química y biológica, lo que hace de la biología una ciencia eminentemente retrospectiva. En palabras de biólogo evolucionista Stephen Jay Gould: «Si rebobinásemos la historia de la vida y dejásemos correr de nuevo la cinta, las especies, el plan corporal y los fenotipos que evolucionarían serían completamente distintos».

El elemento aleatorio inherente a la evolución biológica se extiende a otros niveles de la historia, desde la abiogénesis hasta la historia humana. Como Darwin, los historiadores dan cuenta de los giros accidentales del curso de la historia distinguiendo entre describir el «cómo» y explicar el «porqué». Para describir el cómo, los historiadores razonan ex post facto, como hacen los biólogos, y reconstruyen la serie de sucesos concretos que llevan de tal punto a tal consecuencia. Explicar por qué, sin embargo, nos obliga a pensar como un físico y avanzar en el tiempo identificando las conexiones causales, deterministas, que predicen una trayectoria histórica concreta de otra. Una lectura superficial de la historia a menudo parece que ofrece una explicación causal determinista de por qué las cosas ocurrieron de un modo y no de otro.

El árbol de la vida con sus tres dominios y, en la base, su último antepasado común universal —LUCA, por sus siglas en inglés —, la forma de vida más reciente desde la cual ha evolucionado toda la vida de la Tierra.

Pero un análisis más fino tiende a revelar una enrevesada maraña de fuerzas que compiten en las encrucijadas y que, junto a un gran número de accidentes, hacen que el camino tomado deje de ser evidente y en realidad no inevitable, lo que nos obliga a una descripción del cómo, no del porqué. En 17 de junio de 1815, en vísperas de la principal batalla, Napoleón Bonaparte ordenó a su general, Emmanuel de Grouchy, que persiguiera al ejército prusiano para impedirle que se uniese a las fuerzas anglo-aliadas que estaban tomando posición algo más al norte. Grouchy obedeció y emprendió camino hacia el nordeste con buena parte de las tropas francesas, pero no logró encontrar a los prusianos. A la mañana siguiente —desde los bosques que veo—, oyó el profundo estruendo de los cañones franceses en la distancia y comprendió que la batalla ya había comenzado.

Durante unos minutos cruciales, dudó si debía desobedecer las órdenes de Napoleón, dar la vuelta y apresurarse a asistir a las tropas francesas que allí habían quedado. Pero decidió seguir adelante, alejándose del destino, persiguiendo a los prusianos. La decisión de Grouchy en ese momento es un notable accidente congelado, y uno que no solo afectó al desenlace de la batalla, sino también al curso de la historia de Europa. O, por proporcionar otro ejemplo, pensemos en el auge del cristianismo durante el Imperio romano del siglo IV d.C. Cuando el emperador Constantino accedió al trono en el año 306 d.C., el cristianismo no pasaba de ser una oscura secta que competía por influencia con diversos cultos coetáneos. ¿Por qué acabó introduciéndose en el Imperio romano y creciendo hasta convertirse en la fe común? El historiador Yuval Harari argumenta en su libro "Sapiens" que no hay una explicación causal y que la influencia dominante del cristianismo en Europa Occidental se entiende mejor como otro accidente congelado. Haciéndose eco de Gould al hablar de la biología, Harari sentencia que, «si pudiéramos rebobinar la historia y volver a correr el siglo IV un centenar de veces, encontraríamos que el cristianismo solo habría invadido el Imperio romano unas pocas veces».

Pero el accidente congelado del cristianismo tuvo consecuencias de gran alcance. Para empezar, el monoteísmo alentó la creencia en un Dios creador con un plan racional para el mundo creado. No debe sorprendernos, pues, que cuando doce siglos más tarde surgió por fin la ciencia moderna en la Europa cristiana, los primeros científicos viesen sus investigaciones como un empeño religioso, desbrozando así el camino hacia el enigma del diseño con el que todavía nos andamos peleando.

En general, la multitud de caminos que se abren ante cada punto de la historia, desde la historia humana hasta la evolución biológica y astrofísica, significa que las explicaciones deterministas solo valen a un nivel grosero, de poco detalle. En todo momento de la evolución, determinismo y causalidad moldean tan solo las tendencias y propiedades más generales, a menudo sobre la base de leyes que actúan a un nivel de complejidad inferior. La historia humana, por ejemplo, repleta como está de giros accidentales, se ha desplegado hasta ahora casi confinada al planeta Tierra, con la excepción de unas pocas excursiones a otros cuerpos celestes del sistema solar. Este confinamiento planetario no es sorprendente, a la vista del entorno físico y geológico en el que surgió la vida humana, y es predecible. Pero no indica nada concreto acerca de cualquiera de las épocas de la historia humana. De modo parecido, el orden de los elementos químicos y la estructura de la tabla periódica de Mendeléyev quedó congelado en su esencia por las leyes de la física de partículas que actúan a un nivel inferior. Pero las abundancias específicas de los elementos en la Tierra son contingentes a innumerables accidentes que han ido dando forma a su evolución.

Si nos movemos ahora a un nivel bioquímico, pensemos en la regla que dice que toda la vida en la Tierra está basada en el ADN y que los genes están constituidos por cuatro nucleótidos concretos abreviados: A, C, G y T. Las piezas de construcción específicas de la molécula de ADN son, con toda probabilidad, el resultado de la abiogénesis en nuestro planeta. Pero la capacidad computacional básica que la vida debe dominar para sustentarse discurre a un nivel más profundo y bien podría determinar las propiedades estructurales básicas de la molécula portadora de la información genética en función de principios matemáticos y físicos subyacentes. Así lo sugiere la construcción teórica de autómatas autorreplicantes de la mano del matemático húngaro-estadounidense John von Neumann en 1948. Cinco años antes de que Watson y Crick descubriesen la estructura del ADN, Von Neumann identificó los problemas computacionales críticos que la vida tiene que resolver para existir y propuso una ingeniosa estructura, en teoría la única posible, que logra la capacidad de replicarse. En la estructura que dibujó se reconoce de inmediato el ADN.

La evolución construye de continuo sobre una enorme cadena de accidentes congelados. Los niveles de complejidad más bajos definen el entorno de los niveles superiores de evolución, pero dejan tanto espacio para giros sorprendentes que a menudo acaban por hacerse realidad trayectorias del todo improbables, y el determinismo fracasa. Los incontables resultados del azar en los sucesos de bifurcación infunden en la evolución un elemento genuinamente emergente. Añaden una cantidad ingente de estructura e información que simplemente no se encuentra contenida en las leyes de nivel inferior, y de la cual pueden emerger, y a menudo emergen, nuevos patrones afines a leyes. Por ejemplo, aunque en la actualidad ningún científico que se precie cree que haya en la biología «fuerzas vitales» especiales que carezcan de origen físico-químico, el nivel físico por sí solo no determina cuáles serán las leyes de la biología en la Tierra.

Apenas dieciocho días después de la publicación de su obra maestra, "El origen de las especies", el 24 de noviembre de 1859, Charles Darwin recibió una carta del astrónomo sir John Frederick William Herschel. Hijo del descubridor de Urano, Herschel expresaba escepticismo sobre la arbitrariedad de la evolución tal como la concebía Darwin y añadía que su libro era «la ley del desbarajuste». Pero es justo ahí donde reside su fuerza. Lo hermoso de la teoría de Darwin es que sintetiza la competencia de las fuerzas de la variación al azar y la selección ambiental en el mundo vivo. Darwin encontró el punto óptimo entre el «porqué» y el «cómo» en la biología, integrando explicaciones causales y razonamiento inductivo en un solo marco conceptual coherente. Demostró que, pese a su naturaleza sobre todo histórica y accidental, la biología puede ser una verdadera ciencia productiva que contribuya a nuestra comprensión del mundo vivo.

El darwinismo reforzó la revolución científica y la llevó hasta un dominio, el mundo vivo, en el que la visión teleológica parecía inexpugnable. Pero la cosmovisión que irradia no podía ser más distinta de la que emana de la física moderna. Esta diferencia se manifiesta con especial claridad en sus visiones contrastadas sobre el enigma del diseño. El darwinismo ofrece una explicación evolutiva de la apariencia de diseño en el mundo vivo. En cambio, la física y la cosmología han buscado en la naturaleza de unas leyes matemáticas atemporales la explicación de qué hizo posible en un principio la aparición de la vida. Tanto los estudiosos de las ciencias de la vida como los de la física han contrastado a menudo el «desbarajuste» de la evolución darwiniana con el carácter rígido e inmutable de las leyes de la física. No se concibe que en la base de la física rijan ni la historia ni la evolución, sino la eterna belleza matemática.

La monumental contribución de Lemaître sobre la expansión del universo sin duda introdujo un fuerte pensamiento evolutivo en la cosmología. Pero a un nivel más profundo, el que atañe al origen fundamental del aparente diseño, los bosquejos de Lemaître y Darwin parecen exudar visiones profundamente distintas. Ese es el abismo que ha apartado a la física y la biología desde la revolución científica. Tender puentes sobre ese abismo es algo que estuvo en la mente de Stephen Hawking desde sus primeras incursiones científicas, pero solo se concretó en un auténtico programa de investigación hacia el final del siglo XX, cuando buena parte de sus esfuerzos acabaron centrándose en el enigma del diseño cósmico. Lo que pretendía era nada menos que cambiar la cosmología desde dentro.

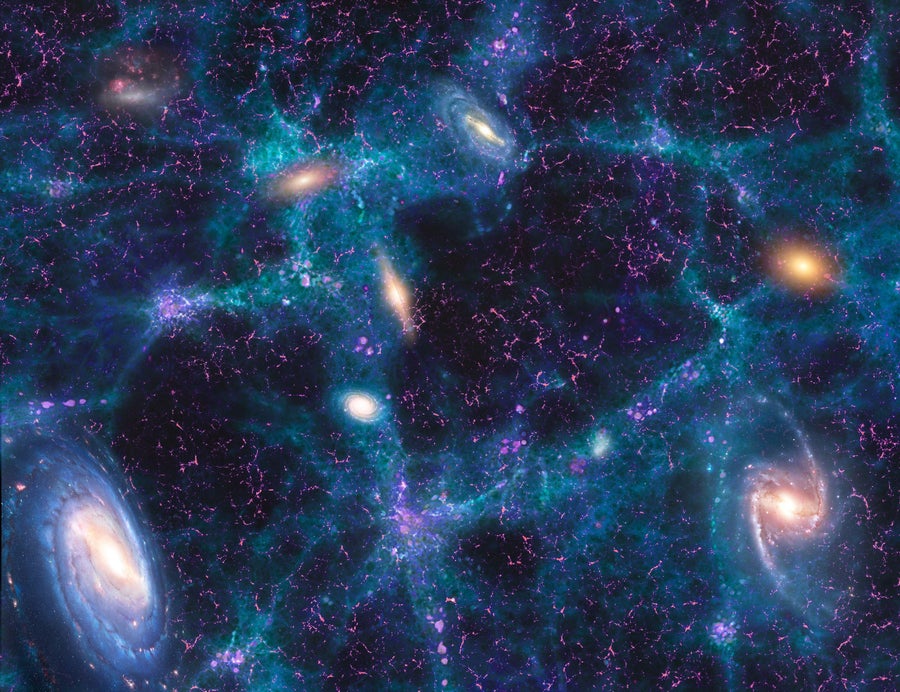

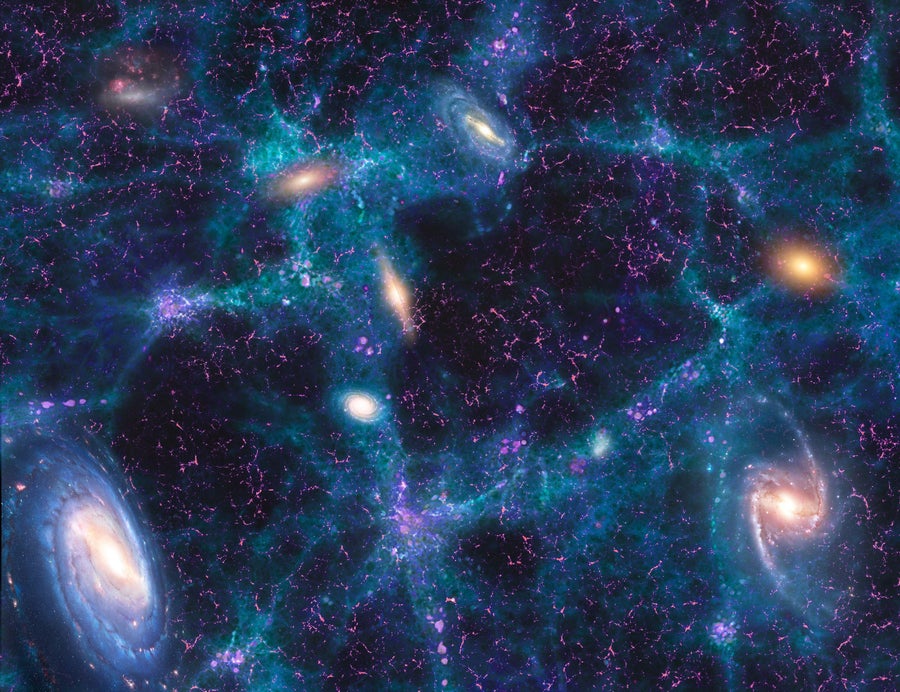

El inesperado descubrimiento observacional de que el universo se estaba acelerando se alió con desarrollos teóricos igual de sorprendentes que sugerían que las leyes de la física podrían no estar grabadas en piedra. Crecían las pruebas de que al menos algunas propiedades de las leyes físicas podrían no ser necesidades matemáticas, sino accidentes que reflejan la manera particular en que este universo se enfrió en el breve periodo del big bang caliente. Desde las especies de partículas hasta la magnitud de las fuerzas, pasando por la cantidad de energía oscura, se hizo patente que la biofilia del universo tal vez no estaba inscrita en su arquitectura básica desde el principio mismo, como si fuera parte de su certificado de nacimiento, sino que habría sido el resultado de una antigua evolución escondida en lo más profundo del big bang caliente.

Los teóricos de cuerdas no tardaron en concebir un abigarrado multiverso, un enorme espacio en inflación que contendría una multitud de universos isla, cada uno con su propia física. Esta grandiosa extensión cósmica condujo a un cambio de perspectiva radical sobre las cuestiones relacionadas con el ajuste fino del cosmos. En lugar de lamentar el fin del sueño de una única teoría final que prediga cómo debería ser el universo, los proponentes del multiverso intentaron darle la vuelta a tan embarazoso fracaso transformando la cosmología en una ciencia ambiental (¡aunque con un ambiente de dimensiones ingentes!). Un teórico de cuerdas comparó el carácter local de las leyes físicas en el multiverso con el clima de la costa este de Estados Unidos: «Tremendamente variable, casi siempre horrible, pero delicioso en contadas ocasiones»

La historia de la ciencia nos permite hacernos una idea de la magnitud de este cambio. En el año 1597, el astrónomo alemán Johannes Kepler ideó un modelo del sistema solar basado en los antiguos sólidos platónicos, los cinco poliedros regulares, de los que el cubo es el más conocido. Kepler pensó en asociar las órbitas más o menos circulares de los seis planetas conocidos a esferas invisibles que giraban en torno al Sol. Entonces propuso que los tamaños relativos de esas esferas venían dictados por la condición de que cada una de ellas, salvo la más exterior de Saturno, encajaba dentro de uno de los poliedros regulares, y que cada una, salvo la más interior de Mercurio, encajaba justo por fuera de uno de los poliedros. La ilustración de Kepler que se puede ver en la figura ilustra esta configuración. Cuando Kepler colocó los cinco sólidos geométricos en el orden preciso, cada uno dentro de otro, todos ellos perfectamente ajustados, encontró que las esferas encajadas en ellos se situaban a intervalos que se correspondían con la distancia de cada planeta al Sol, con Saturno sobre una esfera que circunscribía el más exterior de los poliedros, sin que quedase margen alguno para alterar los radios relativos. Su modelo predecía el número total de planetas (seis), así como los tamaños relativos de sus órbitas.

En su primera gran obra astronómica, el Mysterium Cosmographicum, Johannes Kepler propuso un modelo platónico del sistema solar que relacionaba los tamaños de las órbitas (circulares) de los planetas con los cinco sólidos regulares. En el dibujo de Kepler se pueden observar claramente cuatro esferas planetarias, así como el dodecaedro, el tetraedro y el cubo.

Para Kepler, el número de planetas y sus distancias desde el Sol eran una manifestación de la profunda simetría matemática de la naturaleza. Su obra Mysterium Cosmographicum es en realidad un intento por reconciliar el antiguo sueño platónico de la armonía de las esferas con el descubrimiento del siglo XVI de que los planetas se desplazan alrededor del Sol. En tiempos de Kepler, se solía considerar que el sistema solar comprendía casi todo el universo. Nadie sabía que las estrellas eran soles con sus propios sistemas de planetas, de modo que fue perfectamente natural suponer que las órbitas planetarias eran una cuestión del todo fundamental. Hoy sabemos que el número de planetas o su distancia desde el Sol no revisten mayor importancia.

Entendemos que la constelación de planetas del sistema solar no es única o siquiera especial, sino el resultado accidental de la historia de su formación a partir de una nebulosa de gas y polvo que se arremolinaba en torno a un protosol. En las últimas tres décadas, los astrónomos han observado cientos de miles de sistemas planetarios con configuraciones orbitales muy variadas. Algunas estrellas tienen planetas del tamaño de Júpiter que completan una órbita en cuestión de días, otros tienen tres o más planetas habitables, parecidos a la Tierra, y aun otros sistemas planetarios poseen dos estrellas, lo que produce un patrón caótico de días y noches, y muchos otros fenómenos celestes curiosos. Si de verdad vivimos en un multiverso, a las leyes de la física de nuestro universo les espera el mismo destino que a las órbitas planetarias del sistema solar. Sería inútil seguir los pasos de Kepler y buscar una explicación más profunda de los ajustes finos que engendraron la vida.

En el multiverso, las propiedades biofílicas de las leyes no serían más que el resultado accidental de procesos aleatorios durante el big bang caliente que dio origen a nuestro particular universo isla. Los proponentes del multiverso arguyen que los platónicos de nuestros días han estado buscando en la dirección equivocada. No es para ellos una profunda verdad matemática la que hace a nuestro universo acogedor para la vida, sino solo un estupendo clima cósmico. Cualquier impresión de un gran diseño cósmico no es más que una ilusión. Pero en este razonamiento se esconde un problema que será de enorme importancia cuando comentaré el núcleo de la teoría final de Stephen Hawking: el multiverso es también un constructo platónico. La cosmología del multiverso postula algún tipo de metaleyes eternas que rigen todo el conjunto. Pero esas metaleyes no especifican en cuál de los muchos universos se supone que estamos nosotros. Eso es un problema, pues, sin una regla que relacione las metaleyes del multiverso con las leyes locales dentro de nuestro universo isla, la teoría queda atrapada en una espiral de paradojas que nos deja sin predicciones verificables de ningún tipo.

La cosmología del multiverso es sobre todo indeterminada y ambigua. Carece de información crucial acerca de nuestra ubicación en ese demencial tapiz cósmico, y, en consecuencia, no puede predecir qué deberíamos ver. El multiverso es como una tarjeta de crédito sin pin o, lo que es peor, un armario de IKEA sin instrucciones de montaje. En un sentido profundo, la teoría no logra decirnos quiénes somos en el cosmos y por qué estamos aquí. Los multiversistas, sin embargo, no se rinden con facilidad y han propuesto una forma de remendar la teoría tan radical que ha sacudido a la comunidad científica desde entonces. Se trata del «principio antrópico».

El principio antrópico hizo su aparición en la cosmología en 1973. El astrofísico Brandon Carter, que, igual que Stephen, estudiaba entonces en Cambridge, propuso el principio en una conferencia celebrada en Cracovia para conmemorar a Copérnico. Este es un curioso giro de la historia, pues había sido Copérnico quien, en el siglo XVI, había dado los primeros pasos para destronar a la humanidad de su posición central en el cosmos. Más de cuatro siglos después, Carter se mostraba de acuerdo con Copérnico en que no ocupamos ese lugar en el orden cósmico, pero, según razonaba, ¿no nos estaríamos equivocando al suponer que no somos especiales de ningún modo, sobre todo en lo que concierne a nuestras observaciones del cosmos? ¿No podría ser que descubramos un universo que es como es porque nosotros lo habitamos?

Carter tenía su parte de razón. Es evidente que no podemos observar nada donde o cuando no existimos. Ya en la década de 1930, científicos como Lemaître y el astrónomo estadounidense Robert Dicke reflexionaron sobre qué propiedades debería tener el universo para sustentar seres inteligentes. Las formas de vida, inteligentes o no, dependen del carbono, por ejemplo, que es producto de la fusión termonuclear que tiene lugar en las estrellas, un proceso que requiere miles de millones de años. Pero un universo en expansión no puede proporcionar miles de millones de años de tiempo salvo que contenga miles de millones de años luz de espacio. No debe sorprendernos entonces que Lemaître y Dicke concluyeran que vivimos en un universo grande y viejo. Los universos en expansión tienen un periodo definido en el que pueden trabajar astrónomos hechos de carbono, y eso influye por necesidad en lo que pueden ver.

Estas conclusiones no difieren en lo esencial de las que extraemos cuando consideramos sesgos de selección en situaciones cotidianas. Pero Carter fue un poco más allá. Mucho más allá. Sugirió que los efectos de selección no se producen en un único universo, el nuestro, sino en todo el multiverso. Sugirió que en todo ello se aplica un principio antrópico, una regla que está por encima y más allá de las metaleyes impersonales que gobiernan el multiverso, que encierra las condiciones cósmicas óptimas para la vida y que «actúa» seleccionando cuál de los muchos universos debería ser el nuestro.

Esa era una proposición decididamente radical. Al situar de nuevo la vida en una posición privilegiada en el centro de la explicación del universo, el principio antrópico de Carter parece llevarnos cinco siglos atrás, hasta los tiempos anteriores a Copérnico. Pero, además, al postular un particular estado predilecto que incluye la vida, la inteligencia e incluso la consciencia, coquetea incluso con la teleología, la visión aristotélica que la revolución científica había conseguido destituir, o eso creíamos. No debe sorprendernos, entonces, que cuando en 1973 Carter propuso su principio antrópico cosmológico, sin que hubiera apenas prueba alguna de ningún tipo de multiverso, sus cavilaciones se recibieron en general como un sinsentido. Sin embargo, cuando a finales de siglo, en un notable giro de los acontecimientos, la teoría del multiverso ganó terreno, el pensamiento antrópico de Carter experimentó una rápida resurrección y se apeló a él para comprender nuestro lugar en este vasto tapiz cósmico. El principio antrópico pasó a verse como el pin que transformaba la teoría del multiverso del edificio platónico abstracto en teoría física formal con auténtico potencial explicativo.

Los aficionados a los multiversos declararon que habían hallado una segunda respuesta posible al misterio del diseño del universo; la primera era que solo es resultado de una coincidencia, una feliz consecuencia del profundo, pero, hasta el momento, misterioso principio matemático que se hallaría en el corazón mismo de la existencia. La nueva respuesta que ofrecía la cosmología antrópica del multiverso era que el aparente diseño es una propiedad de nuestro entorno cósmico «local»: dentro de un enorme mosaico de universos isla, habitamos en un raro universo biofílico que se ve destacado por el principio antrópico. No fue poca la excitación que provocaron estas tesis. «Estamos juntos, el universo y nosotros —proclamó Linde—. No puedo imaginar una teoría coherente del universo que ignore la vida y la conciencia». En su obra "El paisaje cósmico", el acérrimo defensor de la teoría de cuerdas Leonard Susskind, de la Universidad de Stanford, con quien siempre se puede contar para una buena especulación, presentaba el tándem formado por unas metaleyes objetivas y un principio antrópico subjetivo como el nuevo paradigma de la física fundamental.

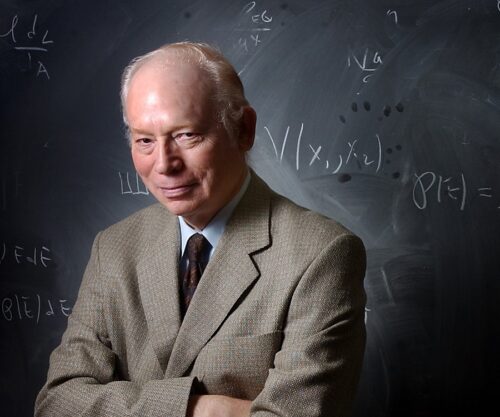

El gigante de la física de partículas Steven Weinberg también sugirió que el razonamiento antrópico señalaba el albor de una nueva era para la cosmología. Su teoría unificada de finales de la década de 1960, que reconocía que las fuerzas nucleares fuerte y débil eran una y la misma, está en la base del llamado modelo estándar de la física de partículas. Desde entonces, algunas de las predicciones de este modelo se han podido verificar con una asombrosa precisión, de no menos de catorce decimales, lo que la convierte en la teoría física contrastada con mayor precisión de todos los tiempos. Pese a ello, a Weinberg le parecía que, para comprender las razones profundas por las que el modelo estándar adopta la forma particular que tiene, era necesario complementar los principios matemáticos de la física ortodoxa con un principio de una naturaleza distinta por completo.

Steven Weinberg

«La mayoría de los avances de la historia de la ciencia han estado jalonados por descubrimientos acerca de la naturaleza —nos explica en su conferencia “Viviendo en el multiverso”, impartida en Cambridge—, pero en determinados momentos hemos hecho descubrimientos sobre la propia ciencia y sobre qué consideramos una teoría aceptable. Tal vez nos hallemos en una de esas bifurcaciones. […] El multiverso legitima el razonamiento antrópico como una nueva base para las teorías físicas». La visión del mundo a la que Weinberg apela aquí se asemeja a una forma de dualismo. Hay leyes físicas o metaleyes, y las estamos descubriendo, pero son frías e impersonales. Sin embargo, también está el principio antrópico que a su propia y enigmática manera tiende puentes entre las (meta)leyes y el mundo físico que experimentamos.

La respuesta fue feroz. A lo largo de los años, el principio antrópico se ha convertido, bajo cualquier medida, en la cuestión más polémica de la física teórica. Algunos son firmes en su oposición. «La teoría inflacionaria ha cavado su propia tumba», ha declarado desde Princeton Paul Steinhardt, el codescubridor de la inflación cósmica. «Es como rendirse», lamentó secamente David Gross, premio Nobel de la Universidad de California. Otros piensan que toda discusión sobre nuestro lugar en el cosmos es prematura. «Es demasiado pronto para ocuparse de esas cuestiones», confesó el teórico, por lo general visionario, Nima Arkani-Hamed ante un público de teóricos de cuerdas en el verano de 2019. Cinco siglos después de la revolución científica moderna, que plantó las semillas del dualismo en la física, esta es una declaración notable.

Para frustración de Stephen Hawking, una callada mayoría de teóricos siguió mirando hacia otro lado, perdidos en la matemática. La mayoría de los físicos teóricos creían —y todavía creen— que una investigación sobre el origen profundo de la biofilia del universo cae fuera del ámbito de su disciplina. Prefieren pensar que, de algún modo, el problema se desvanecerá cuando descubramos la ecuación maestra de la teoría de cuerdas que rige el universo. Stephen sostenía que para dilucidar el misterio del universo no bastaba con encontrar las metaleyes matemáticas abstractas. Para él, la búsqueda de una teoría unificada en la física estaba indisolublemente ligada a nuestros orígenes en el big bang. El sueño de una teoría final, argumentaba, no se alcanzará si la concebimos «tan solo» como un problema de laboratorio más, sino que debemos perseguirla en el contexto de la evolución cosmológica. En su búsqueda de una nueva visión del universo, la matemática era la vasalla de Stephen, no su señora.

Así que Hawking coincidía con los defensores del principio antrópico en que era importante comprender mejor las propiedades que hacen el universo acogedor para la vida, y que el simple platonismo no bastaría, sino que haría falta un cambio de paradigma, un cambio fundamental en nuestra manera de concebir la física y el estudio del universo. No obstante, cada vez iría recelando más de que el razonamiento antrópico fuese el tipo de cambio revolucionario que se necesitaba a la luz de aquellos avances. Su preocupación principal respecto al principio antrópico como parte de un nuevo paradigma cosmológico no era tanto su naturaleza cualitativa, pues la biología y otras ciencias históricas están repletas de predicciones de un tipo más cualitativo. Para él, el verdadero problema radicaba en que el razonamiento antrópico escapa al proceso científico básico de predicción y falsación.

Este proceso lo había desarrollado a fondo el filósofo austro-húngaro de la ciencia Karl Popper. Según su teoría, lo que hace de la ciencia una forma especialmente potente de adquirir conocimiento es que una y otra vez se alcanza el consenso entre científicos mediante la argumentación racional sobre la base de las pruebas empíricas disponibles. Popper comprendió que nunca se puede demostrar que una teoría científica sea cierta, pero se puede falsar, es decir, contradecir con experimentos. Sin embargo, y esta es la clave del método de Popper, este proceso de falsación solo es posible porque se exige que las hipótesis teóricas produzcan predicciones inequívocas, de manera que, si se obtienen resultados contrarios, se demuestre que al menos una de las premisas de la teoría no se aplica en la naturaleza. En "La estructura de las revoluciones científicas", el filósofo americano de la ciencia Thomas Kuhn explicó que los cambios de paradigma se producen cuando el paradigma reinante bajo el que funciona la ciencia normal se manifiesta incompatible con nuevos fenómenos. Cabe preguntarse cuáles debían ser los «nuevos fenómenos» que aparecieron y desataron las voces de renovación en la cosmología hacia el cambio de siglo al XXI. Los principales, según creo, fueron las observaciones astronómicas de la expansión acelerada obtenidas de finales de la década de 1990.

Estas se confabularon con nuevas ideas teóricas de la teoría de cuerdas que ejemplificaban la naturaleza accidental de las leyes biofílicas. La razón de que esto sea crucial para el funcionamientode la ciencia es que esta situación es asimétrica; la confirmación de una predicción teórica apoya una teoría, pero no la prueba, mientras que la refutación de una predicción puede demostrar que es falsa. En la ciencia, la posibilidad de que una hipótesis fracase siempre se esconde a la vuelta de la esquina, y esa es una parte esencial de su modo de progresar. Pero el principio antrópico hace descansar este proceso sobre unos cimientos inestables porque los criterios personales sobre qué constituye un universo biofílico introducen un elemento subjetivo en la física que compromete el proceso popperiano de falsación. La perspectiva antrópica de uno podría seleccionar una sección del universo con cierto conjunto de leyes, y la de otro, otra sección con un conjunto de leyes distinto, sin que tengamos a mano ninguna regla objetiva que nos permita decidir cuál es la correcta.

Esto es muy diferente de la evolución darwiniana, que de manera muy ingeniosa evita que nada parecido al razonamiento antrópico se cuele en la biología. Que exista o no vida extraterrestre, por no decir cómo evolucionó, no desempeña ningún papel en la teoría de Darwin, como tampoco deja margen alguno el darwinismo para destacar una u otra especie para un papel privilegiado en los asuntos de la biología, ya se trate de Panthera leo, de Homo sapiens o de cualquier otra. Muy al contrario, nuestra relación con el resto del mundo vivo se encuentra en el meollo mismo del darwinismo, que reconoce su profunda interconexión.

En agosto de 2001, Martin Rees, en pie a la izquierda de Stephen Hawking, convocó una reunión en su casa de campo en Cambridge (Inglaterra) para debatir los méritos (si los tiene) del principio antrópico en la física fundamental y la cosmología. Fue en el contexto de esta conferencia cuando Stephen y Thomas Hertog (tercera fila, detrás de Hawking) comenzaron a discutir en serio de qué modo una mirada cuántica al cosmos podría sustituir el razonamiento cosmológico antrópico. La conferencia de Rees reunió a muchos de los colegas que habrían de desempeñar un papel clave en nuestro viaje, entre ellos Neil Turok (sentado a la izquierda), Lee Smolin (sentado a la derecha) y Andrei Linde, en pie en el extremo derecho de la fila media. A la izquierda de Linde está Jim Hartle, apenas visible detrás de Bernard Carr, y luego Jaume Garriga, Alex Vilenkin y Gary Gibbons.

Una de las aportaciones de mayor calado de Darwin fue comprender que Homo sapiens coevolucionó con el resto del mundo vivo. «Debemos admitir, según me parece, que el hombre con todas sus nobles cualidades […] todavía lleva marcado en su cuerpo el sello indeleble de sus bajos orígenes», escribió en "El origen del hombre". Qué diferente es eso del principio antrópico de Carter en la cosmología, que actúa por fuera de la evolución natural del universo, como si fuese un añadido. En un sentido popperiano, por lo que concierne a la falsación, el multiverso antrópico apenas difiere de la cosmología del polímata alemán del siglo XVII Gottfried Leibniz. En su obra "Monadología", Leibniz sugirió que hay infinitos universos, cada uno de ellos con su propio espacio, tiempo y materia, y que habitamos en el mejor de los mundos posibles, seleccionado por Dios en toda su bondad. Es bastante comprensible, pues, que la comunidad científica se encuentre en perpetuo desacuerdo acerca de los méritos del principio antrópico. En su incisiva crítica de la teoría de cuerdas, "Las dudas de la física en el siglo XXI", el escritor y físico estadounidense Lee Smolin señala sin ambages que «en el momento en que se prefiere una teoría no falsable a otras alternativas que sí lo son, el proceso de la ciencia se para y queda descartado cualquier aumento del conocimiento».

Llegamos así a un callejón sin salida. El principio antrópico había de especificar «quiénes somos» en el vasto tapiz que es el cosmos y, de ese modo, actuar como puente entre la abstracta teoría del multiverso y nuestras experiencias como observadores dentro de este universo. Sin embargo, no consigue hacerlo respetando los principios básicos de la práctica científica y despoja a la cosmología del multiverso de todo poder explicativo. Esto nos conduce a una observación singular: en el más amplio de los sentidos, desde la moderna revolución científica hemos avanzado sorprendentemente poco en el objetivo de sondear el origen más profundo del diseño aparente que subyace a la realidad física. Sí, entendemos la historia de la expansión del universo con todo lujo de detalles, comprendemos cómo la gravedad moldea el universo a gran escala y entendemos el comportamiento cuántico preciso de la materia hasta escalas mucho más pequeñas que el tamaño de un protón. Pero ese detallado conocimiento físico, sin duda de enorme significación, solo ha servido para acentuar el más profundo enigma del diseño. El carácter biofílico del universo sigue generando confusión, dividiendo por igual a la comunidad científica y al público en general. Una profunda brecha conceptual sigue separando nuestra comprensión del mundo vivo de nuestro conocimiento de las condiciones físicas subyacentes que hacen posible la vida en un principio. ¿Por qué las leyes matemáticas que quedaron establecidas en el big bang han resultado ser apropiadas para la vida? El abismo que separa el mundo animado del inanimado parece ser más profundo que nunca.

Los físicos dicen que el multiverso nos lastra con una paradoja. La cosmología del multiverso se construye sobre la inflación cósmica, la idea de que el universo experimentó un breve periodo de rápida expansión en sus primeros estadios. La teoría inflacionaria gozó de una gran cantidad de apoyo observacional durante algún tiempo, pero tiene la inconveniente tendencia a generar no uno, sino muchísimos universos. Y como no nos dice en cuál de ellos deberíamos estar, carece de esa información, la teoría pierde buena parte de su capacidad de predecir qué deberíamos ver. Esta es la paradoja. Por un lado, nuestra mejor teoría del universo temprano sugiere que vivimos en un multiverso. Al mismo tiempo, el multiverso destruye gran parte del poder predictivo de esta teoría.

Esta no era la primera vez que Hawking había de enfrentarse a una enigmática paradoja. Ya en 1977 se había implicado en un rompecabezas parecido referido al destino de los agujeros negros. La teoría de la relatividad general de Einstein predice que casi toda la información sobre lo que cae en un agujero negro queda para siempre oculta en su interior. Pero Stephen descubrió que la teoría cuántica da un giro paradójico a esta historia. Lo que encontró fue que los procesos cuánticos cerca de la superficie de un agujero negro hacen que el agujero radie un chorro leve pero constante de partículas, entre ellas partículas de luz. Esta radiación, que hoy conocemos como radiación de Hawking, es demasiado tenue para detectarla físicamente, aunque su mera existencia ya es inherentemente problemática. La razón es que, si los agujeros negros irradian energía, se ven abocados a encogerse y, con el tiempo, desaparecer. ¿Qué pasa entonces con la ingente cantidad de información que queda oculta en su interior cuando el agujero negro radia su último gramo de masa? Los cálculos de Hawking indicaban que esa información se perdía para siempre. Argumentaba que los agujeros negros eran la papelera definitiva. Sin embargo, este escenario contradice un principio básico de la teoría cuántica que dicta que los procesos físicos pueden transformar y retorcer la información, pero nunca pueden acabar con ella de manera irreversible. Una vez más, llegamos a una paradoja: los procesos cuánticos hacen que los agujeros negros radien y pierdan información, mientras que la teoría cuántica dice que eso es imposible.

Las paradojas sobre el ciclo de vida de los agujeros negros y sobre nuestro lugar en el multiverso se convirtieron en dos de los rompecabezas más insidiosos y debatidos de las últimas décadas. Conciernen a la naturaleza y el destino de la información en la física y, por consiguiente, golpean el corazón mismo de la cuestión de la naturaleza última de las teorías físicas. Ambas surgen en el contexto de la llamada gravedad semiclásica, una descripción teórica de la gravedad de la que fueron pioneros Hawkingy su grupo de Cambridge a mediados de la década de 1970, que se basa en una amalgama de pensamiento clásico y cuántico. Las paradojas aparecen cuando se aplican estos razonamientos semiclásicos a escalas de tiempo ingentes (el caso de los agujeros negros) o a distancias ingentes (el caso del multiverso). Juntas encarnan las profundas dificultades que surgen cuando intentamos que trabajen con armonía los dos pilares de la física del siglo XX: la relatividad y la teoría cuántica. De este modo, han actuado como exasperantes experimentos mentales con los que los físicos teóricos han forzado su pensamiento semiclásico sobre la gravedad hasta el extremo de ver justo cómo y dónde se desmorona.

Los experimentos mentales siempre han sido los favoritos de Stephen Hawking. Aun habiendo renunciado a la filosofía, a Stephen le encantaba jugar con cuestiones filosóficas profundas: si el tiempo tuvo un principio, si la causalidad es fundamental y, la más ambiciosa de todas, cómo encajamos nosotros, como «observadores», en el esquema del cosmos. Y lo hacía enmarcando estas preguntas en ingeniosos experimentos de física teórica. Tres de los descubrimientos más destacados de Stephen fueron el resultado de experimentos mentales ingeniosos y diseñados con precisión. El primero fue la serie de teoremas sobre la singularidad del big bang en la gravedad clásica; el segundo, el descubrimiento, en 1974, en el contexto de la gravedad semiclásica, de que los agujeros negros radian; y el tercero, su proposición de ausencia de límites, también en el marco de la gravedad semiclásica, para el origen del universo.

Ahora bien, aunque se podría argüir que la paradoja del agujero negro solo tiene interés académico (es improbable que podamos nunca medir los detalles más finos de la radiación de Hawking), la paradoja del multiverso atañe directamente a nuestras observaciones cosmológicas. En el centro mismo de la paradoja se encuentra la tensa relación entre el mundo vivo y el universo físico en la cosmología moderna. El paradigma del multiverso se convirtió en un faro que guio los esfuerzos de Hawking por reimaginar esta relación por medio del desarrollo de una perspectiva del cosmos completamente cuántica. Su teoría final del universo, cuántica de principio a fin, redefine los fundamentos de la cosmología y es la cuarta gran contribución de Hawking a la física. En cierto sentido, el gran experimento mental que hay detrás de la teoría llevaba cinco siglos forjándose.

© 2025 JAVIER DE LUCAS